Découvrez nos

ressources

Vous retrouverez ici l'ensemble du contenu pédagogique élaboré par nos experts en Intelligence Artificielle afin de vous guider au mieux dans votre apprentissage des concepts de l'intelligence artificielle en utilisant la solution AlphAI.

- Si vous n'avez pas encore téléchargé le logiciel AlphAI, nous vous invitons à vous rendre sur la page téléchargement afin de bénéficier des 60 jours d'essai gratuit.

- Si vous découvrez tout juste notre solution, nous vous invitons d'abord à en apprendre un peu plus sur celle-ci en visitant la page La Solution AlphAI.

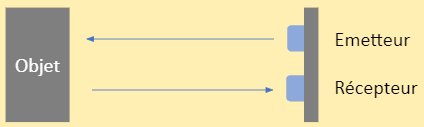

Le logiciel est conçu pour fonctionner sans connexion internet (à l’exception de l’activation de la licence et des mises à jour).

Il demande néanmoins une connexion wifi (recommandé) ou bluetooth pour communiquer avec le robot.

Si vous n’avez pas encore acheté de licence, vous pouvez profiter d’une version d’essai de 60 jours !

Installation Windows

Attention : la vidéo a été réalisée sur notre ancien site web mais le principe reste le même.

- Téléchargez le logiciel

- Lancez le programme d’installation

- Suivez les instructions puis lancez le logiciel !

Vous obtenez cet écran une fois le logiciel téléchargé :

.png)

Configuration requise:

- Windows 8.1 minimum*

- 4 Go de RAM

- 2 Go de place sur le disque dur

- OpenGL version ≥ 2.1

- Accès à internet (à l’installation uniquement pour la récupération de la licence)

* Windows 7 n’est pas supporté par Python 3.9, notre logiciel ne peut donc pas y être installé. N’hésitez pas à nous contacter pour toute assistance lors de l’installation.

Installation Mac

Rendez-vous sur la page téléchargement et suivez les instructions indiquées.

Configuration requise:

- Mac OS

- 4 Go de RAM

- 2 Go de place sur le disque dur

- OpenGL version ≥ 2.1

- Accès à internet (à l’installation uniquement pour la récupération de la licence)

En cas de difficulté, vous pouvez vous reporter à la page FAQ.

Installation Linux

- AlphAI est compilé pour fonctionner avec python 3.9 (idéalement python 3.9.13). Si vous avez un environnement python 3.9, vous pouvez utiliser celui-ci. Dans le cas contraire, vous pouvez télécharger python 3.9.13 à l’adresse suivante :

https://www.python.org/downloads/release/python-3913/.

Dans la suite des instructions, la commande python3 fait référence à cet environnement python 3.9. - Téléchargez une version du logiciel AlphAI : Téléchargez le script d’installation.

- Dé-zippez le dossier téléchargé à l’emplacement où vous souhaitez installer AlphAI.

- Ouvrez un terminal et rendez-vous dans le dossier nouvellement créé, par exemple en utilisant la commande : cd AlphAI-1.8.10.11.

- Dans le terminal, exécutez la commande : python3 -m pip install -r requirements-mac.txt. Ceci doit avoir pour effet d’installer toutes les bibliothèques python nécessaires à l’utilisation du logiciel.

- Finalement, pour lancer le logiciel, entrez la commande : sudo python3 Start_Alphai.pyc, puis entrez votre mot de passe utilisateur. Attention, il faudra ici remplacer python3 par un chemin explicite vers l’interpréteur python, par exemple ./python3 ou ~/Documents/AlphAI/alphaienv/bin/python3, car sinon c’est l’interpréteur par défaut qui va se lancer.

Configuration requise:

- Ubuntu 18

- 4 Go de RAM

- 2 Go de place sur le disque dur

- OpenGL version ≥ 2.1

- Accès à internet (à l’installation uniquement pour la récupération de la licence)

En cas de difficulté, vous pouvez vous reporter à la page FAQ.

Lors du premier lancement du logiciel, vous allez voir apparaître la fenêtre d’activation de licence.

.png)

Assurez-vous de disposer d’une connexion à internet, et choisissez l’une des options suivantes :

Cochez la case Version d’essai

Dans ce cas, vous avez la possibilité d’utiliser le logiciel gratuitement sur cet ordinateur pendant une durée de 60 jours. Attention : cette option ne peut être activée qu’une seule fois par ordinateur !

.png)

Utilisez une clé d’activation

Cela vous permettra d’utiliser le logiciel sans condition de durée. Pour cela, entrez votre clé d’activation dans le champ prévu à cet effet et sélectionnez une période de validité. À la fin de la période de validité, vous devrez réactiver votre licence. Afin de ne pas égarer celle-ci, vous avez la possibilité de sauvegarder votre clé d’activation sur l’ordinateur.

⚠️ Attention : cela rend possible la réactivation de la licence sur cet ordinateur par un simple clic, ne sauvegardez donc pas votre clé d’activation sur un ordinateur qui ne vous appartient pas !

.png)

Réactivez votre licence grâce à une clé enregistrée, en cochant la case utiliser la clé enregistrée. Vous devrez également sélectionner la durée de la nouvelle période de validité.

.png)

La fenêtre suivante vous propose de nous fournir des informations :

.png)

Cette étape n’est pas obligatoire, mais nous vous prions de bien vouloir remplir les différents champs, ces informations nous permettrons de vous fournir une assistance si besoin mais également de vous informer en cas de mise à jour du logiciel.

À propos de la période de validité :

- La période de validité correspond à la durée pendant laquelle vous pouvez utiliser notre logiciel sans connexion à internet.

- À l’expiration de cette période, il vous sera demandé de réactiver votre licence, étape qui requiert une connexion à internet.

- Chaque clé d’activation est délivrée avec une limite sur le nombre d’activations simultanées autorisées (généralement 2 ordinateurs ou 30 ordinateurs).

- Dans le cas d’utilisation du logiciel dans une salle de classe, il est conseillé de choisir une durée d’activation correspondant à la période d’utilisation prévue, par exemple jusqu’à la fin de l’année scolaire. Ainsi, lorsque les licences expireront, il sera possible d’utiliser le logiciel dans une autre salle.

Exemple : Supposons que ma clé d’activation a une limite de 2 postes. Grâce à cette clé, j’active le premier janvier une licence sur un ordinateur A pour une durée de 6 mois (donc jusqu’au 30 juin). Ensuite, le premier février, j’utilise la même clé pour activer une licence sur un ordinateur B pour une durée de 3 mois (donc jusqu’au 30 avril). Sur la période du premier février au 30 avril, le nombre maximal d’activations est atteint, il m’est donc impossible d’utiliser ma clé d’activation sur un troisième ordinateur. En revanche, à partir du premier mai, la licence de l’ordinateur B a expiré, il m’est alors possible d’activer une licence sur un ordinateur C pour une durée de mon choix. De même, à partir du premier juillet, la licence de l’ordinateur A n’est plus valide, rendant possible l’activation sur un autre ordinateur (ou le renouvellement de la licence sur l’ordinateur A).

Durée

Les clés d’activation vendues par Learning Robots sont perpétuelles.

Limite d’appareils

Selon le produit que vous avez choisi, votre licence est valable sur 2 ou 30 appareils.

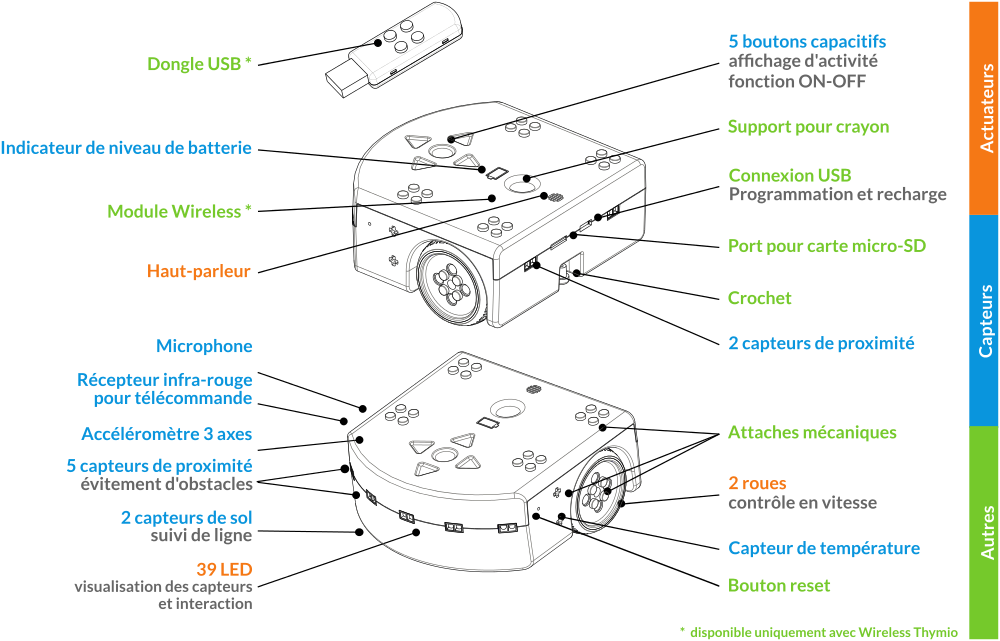

Spécificités Thymio

Les licences pour robots Thymio ont quelques différences avec les autres types de licences. La première différence est que la fenêtre d’activation de licence ne va pas apparaître au lancement du logiciel, mais seulement lors de la première connexion à un robot Thymio.

Si ce robot est une simulation, alors tout se passe comme décrit précédemment.

.png)

Si ce robot est un Thymio réel, alors la licence sera stockée sur le robot lui-même et non pas sur votre ordinateur. Cela vous permettra ensuite de connecter ce robot à tout ordinateur où le logiciel est installé, même si ce dernier ne dispose pas de licence active. Cependant, vous ne pourrez utiliser votre clé d’activation de cette manière que sur un seul robot Thymio. Si vous souhaitez utiliser AlphAI avec plusieurs robots Thymio, il vous faudra acquérir une licence pour chaque robot.

La période de validité pour les robots Thymio réels est à durée illimitée.

Pour connecter votre Thymio à votre ordinateur, vous pouvez vous reporter à la fiche ressource Thymio.

Lancer le logiciel en cliquant sur le raccourci du bureau (PC) ou en lançant la commande “alphai” dans le terminal puis en entrant votre mot de passe d’ordinateur (Mac).

Lors du lancement du logiciel, si vous êtes connecté à internet, il se peut que le logiciel détecte une mise à jour à effectuer. Elle se lance automatiquement, et cela ne prendra que quelques minutes !

Vous allez alors arriver sur l’écran de connexion.

.png)

Choix du robot

En haut à droite de l’écran d’accueil, vous pouvez choisir le modèle de robot avec lequel vous souhaitez réaliser des activités. Selon la licence achetée, vous pouvez avoir le choix entre :

- le robot AlphAI

- le robot Thymio

- le robot mBot

- le robot Buddy

- le robot Spike (LEGO)

- l’ordinateur (activités sans robot)

.png)

Modes de connexion

Selon le robot choisi, vous pouvez avoir le choix entre plusieurs modes de connexion : par WiFi, par bluetooth (avec une clé ou avec le bluetooth de l’ordinateur), ou un robot simulé.

.png)

Pour le robot AlphAI, nous vous recommandons de toujours privilégier la connexion en WiFi si cela est possible. Si vous choisissez une connexion en Bluetooth, vous trouverez en haut à droite de votre écran un bouton qui permet de désactiver le mode “Bluetooth Low Energy” si votre modèle de robot est ancien.

Simulation

Avec les robots AlphAI et Thymio, il est possible de réaliser de nombreuses activités en simulation. Pour comprendre comment utiliser le mode simulation, merci de vous référer aux pages correspondantes :

Ressources - AlphAI - Connexion au robot

Ressources - Thymio - Connexion au robot

Instructions et aide

En fonction du robot choisi, des boutons en bas de l’écran vous fournissent des instructions et informations pour la connexion au robot et en cas de bugs.Si les instructions ne vous ont pas aidé à résoudre votre problème, vous pouvez vous référer à notre page FAQ.

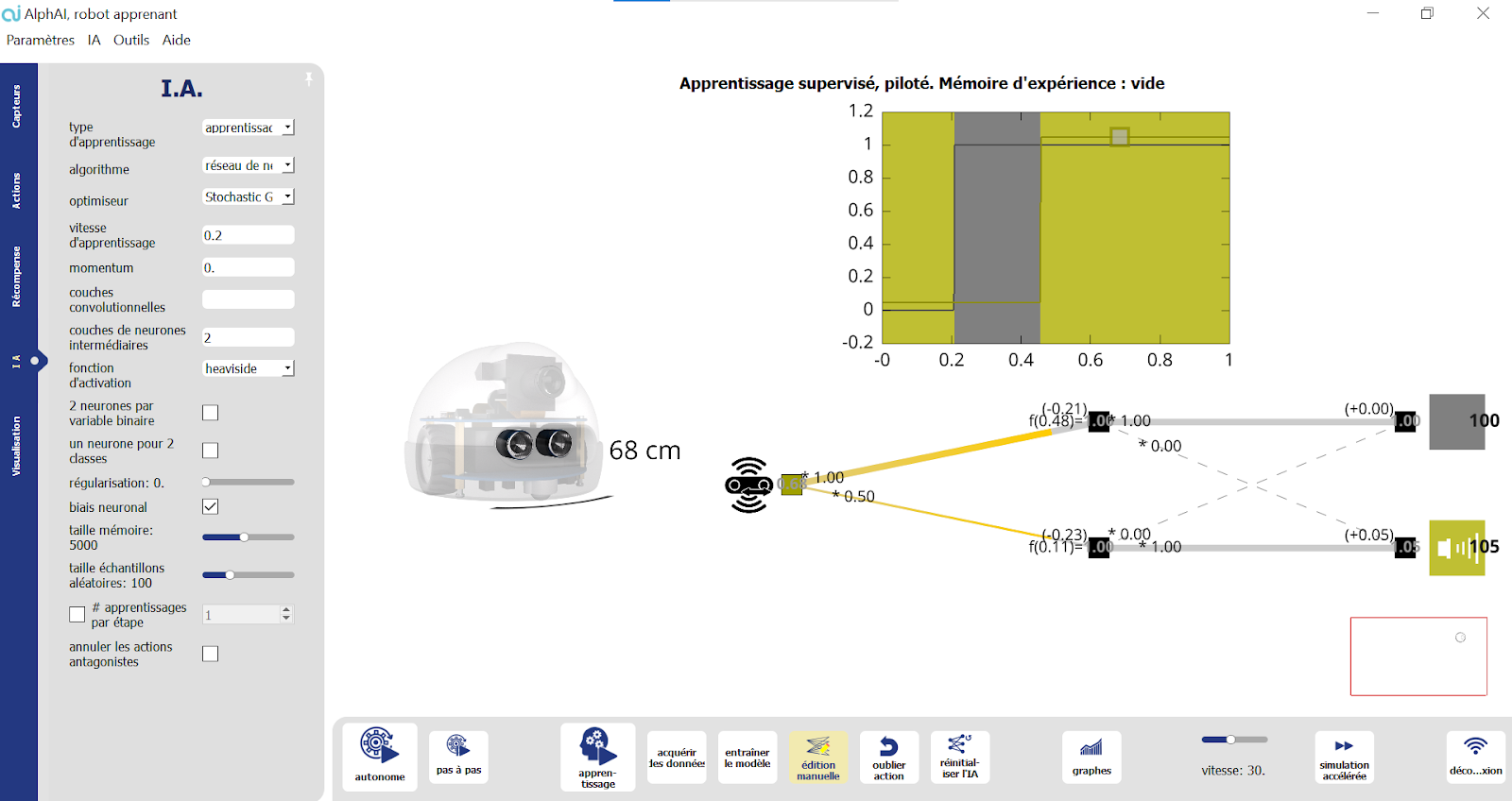

Vous êtes maintenant connecté à votre robot et arrivez sur l’écran principal. Nous vous présentons sur cet page chacun des éléments que vous pouvez voir à l’écran :

.png)

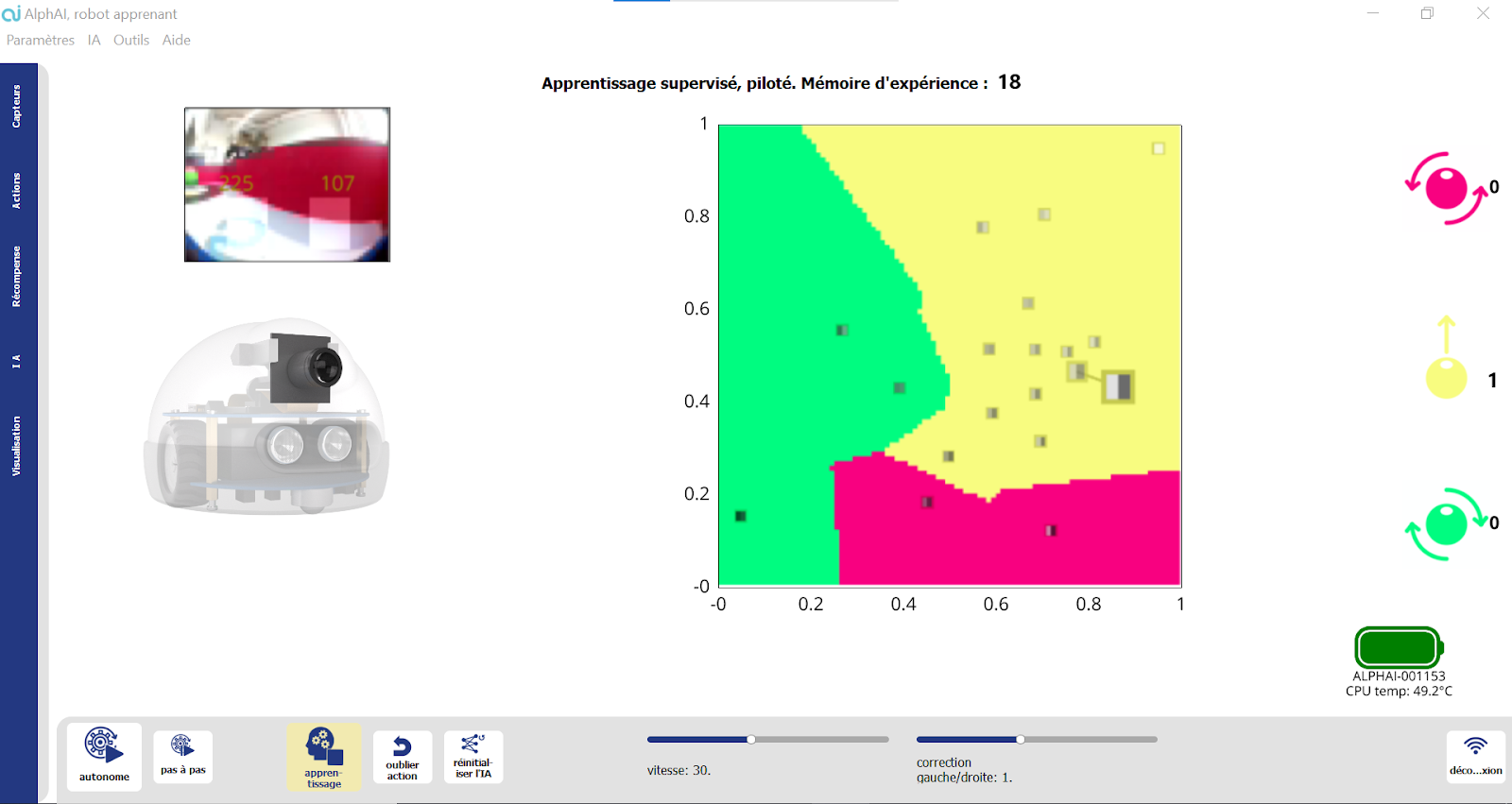

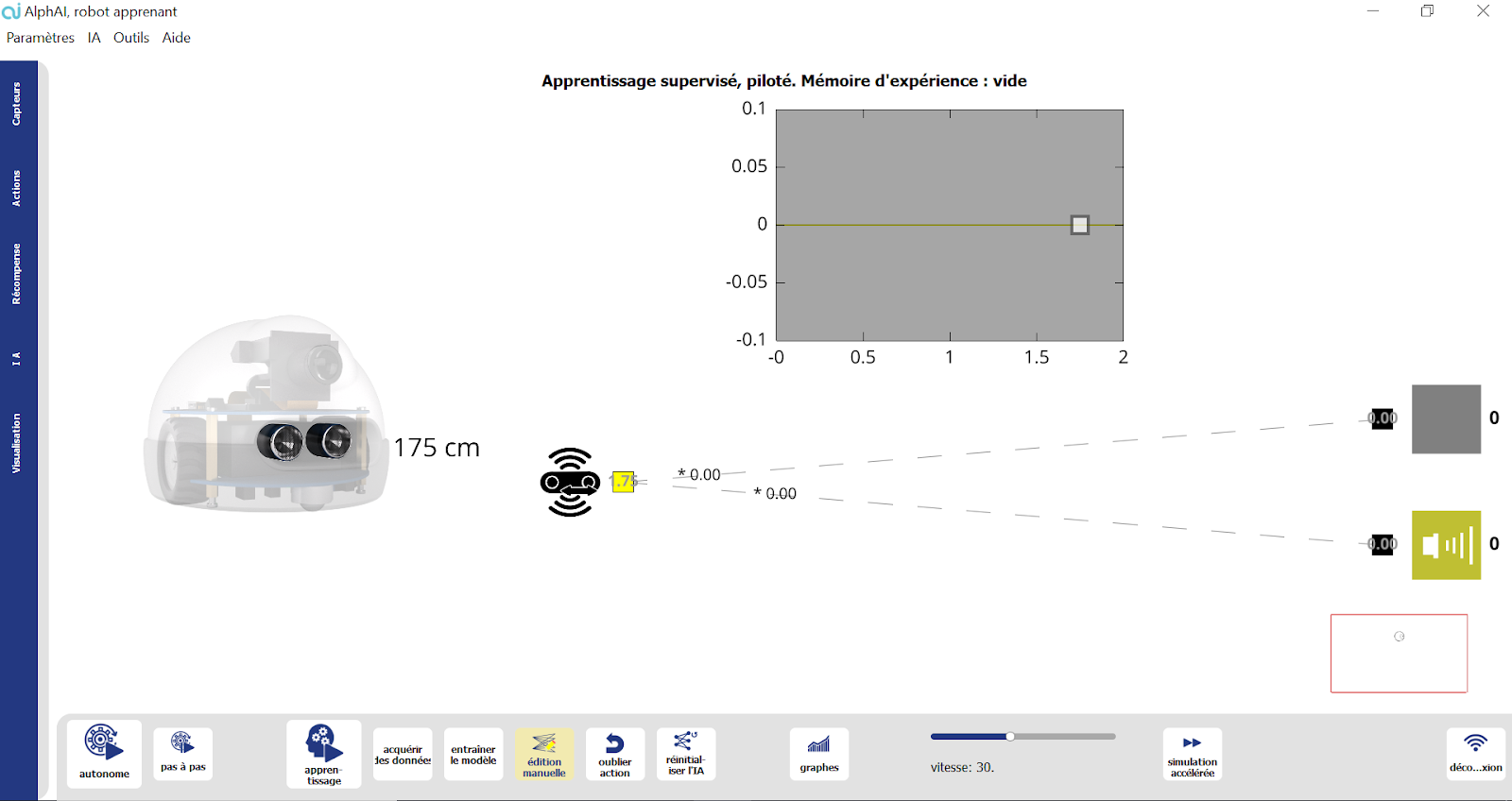

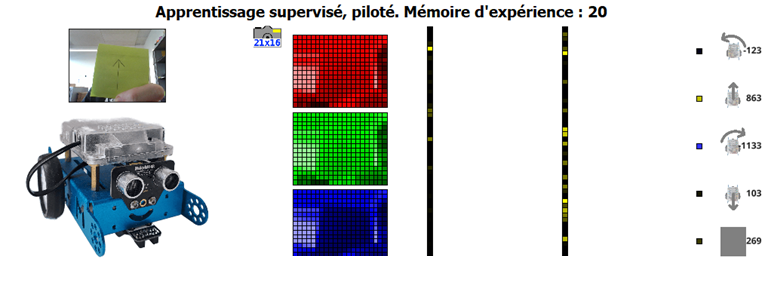

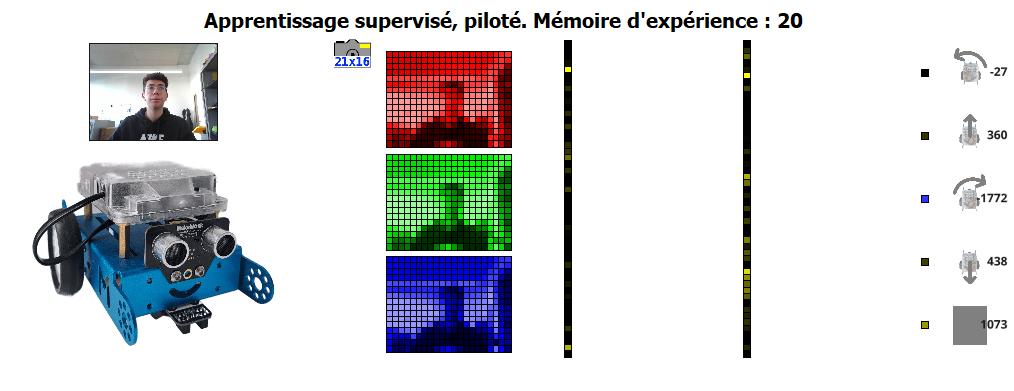

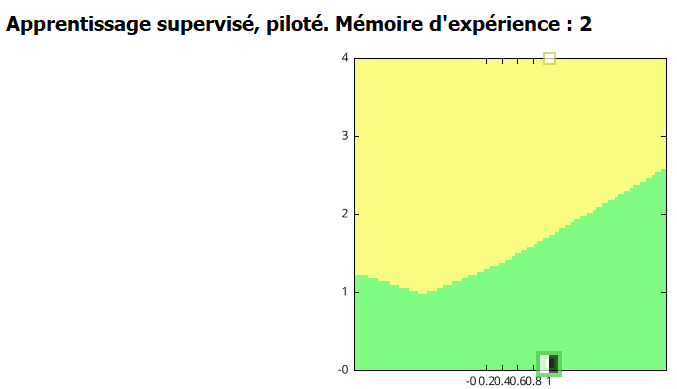

Le titre

En haut de votre écran, un titre vous informe sur les caractéristiques des paramétrages sélectionnés actuellement : le mode d’apprentissage (supervisé, par renforcement, ou aucun apprentissage), le mode de contrôle (piloté/autonome), et le nombre de données enregistrées dans la mémoire d’expérience pendant l’apprentissage.

.png)

Le robot

Vous pouvez voir sur la gauche de votre écran une image du robot que vous êtes en train d’utiliser.

Pour le robot AlphAI, les capteurs utilisés dans l’activité apparaissent en noir.

La couleur des roues vous indique si elles sont bloquées (en rouge) ou non (en vert).

Vous pouvez également voir la couleur de la coque.

.png)

Affichage central

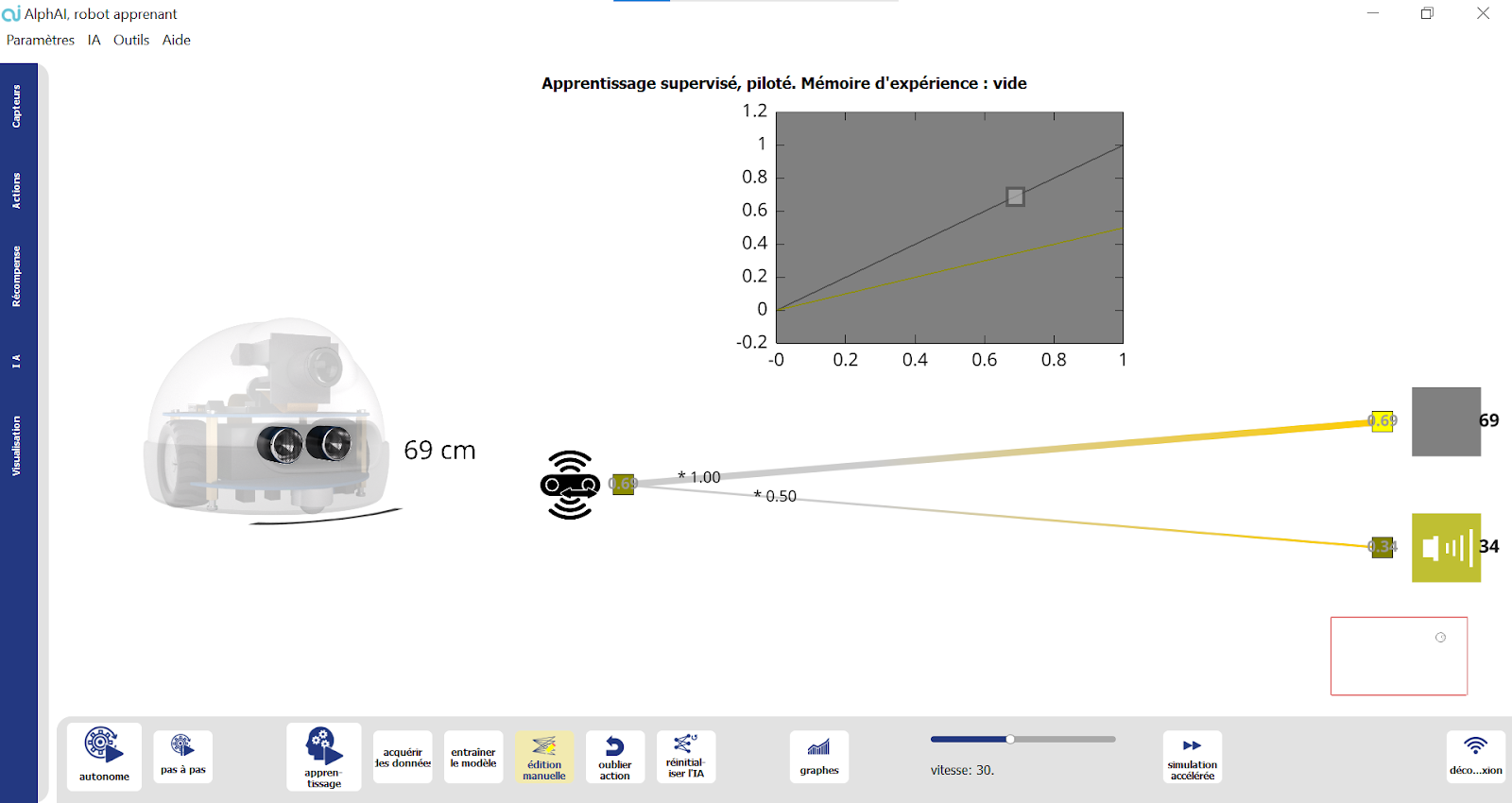

Toute la partie droite de votre écran est occupée par l’affichage central. Il peut contenir :

Un réseau de neurones

Tout à gauche, les neurones d’entrée : ce sont les capteurs du robot utilisés.

Au milieu, les connexions et les couches de neurones intermédiaires.

Tout à droite, les neurones de sorties et les icônes d’action correspondantes : ce sont les actions que peut effectuer le robot.

.png)

Vous pouvez entièrement paramétrer le réseau de neurones (Onglet IA) et modifier sa visualisation (Onglet Visualisation).

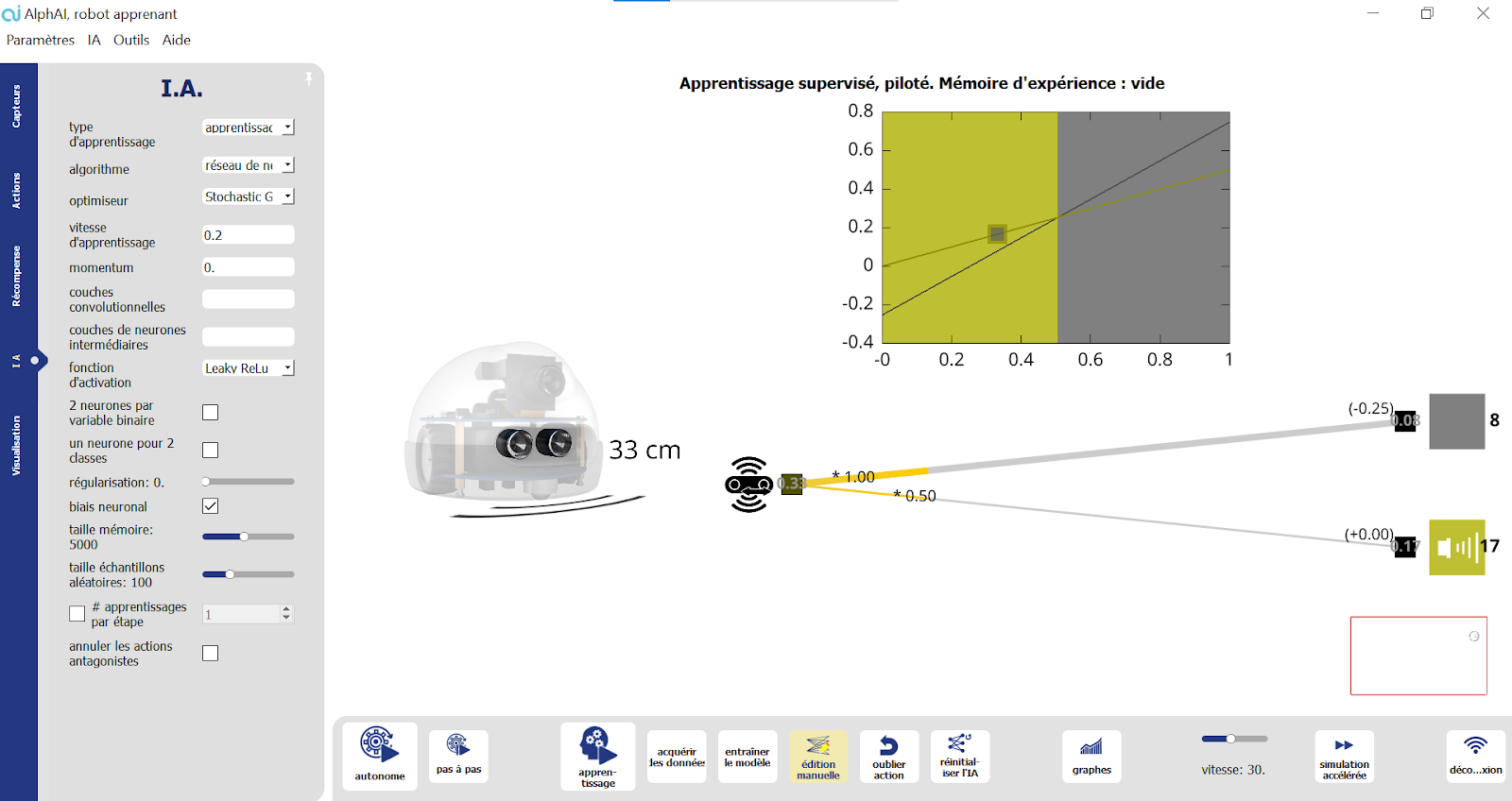

Une visualisation de l’espace d’états

Par exemple, dans le cas où l'algorithme choisi est K plus proches voisins, le réseau de neurones sera remplacé par un graphe. Voir l’activité KNN.

.png)

Une visualisation des données d’apprentissage

Une fois que vous avez fourni des données d’exemple au robot, vous pouvez également faire apparaître à l’écran chaque donnée enregistrée : l’information fournie par les capteurs et l’action qui a été associée. Vous pouvez corriger un biais en supprimant une donnée, modifiant une action, …

Une combinaison de ces éléments

Par exemple dans l’activité Détection d’intrus, on peut voir l’espace d’états et le réseau de neurones

.png)

L’écran vidéo

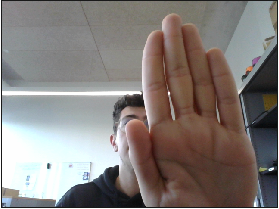

Dans le cas où le capteur caméra est nécessaire pour l’activité choisie, vous pourrez observer en haut à gauche de votre écran un retour de la caméra du robot (même pour un robot simulé !). Si l’activité utilise la webcam de l’ordinateur, c’est ici qu’elle apparaîtra.

.png)

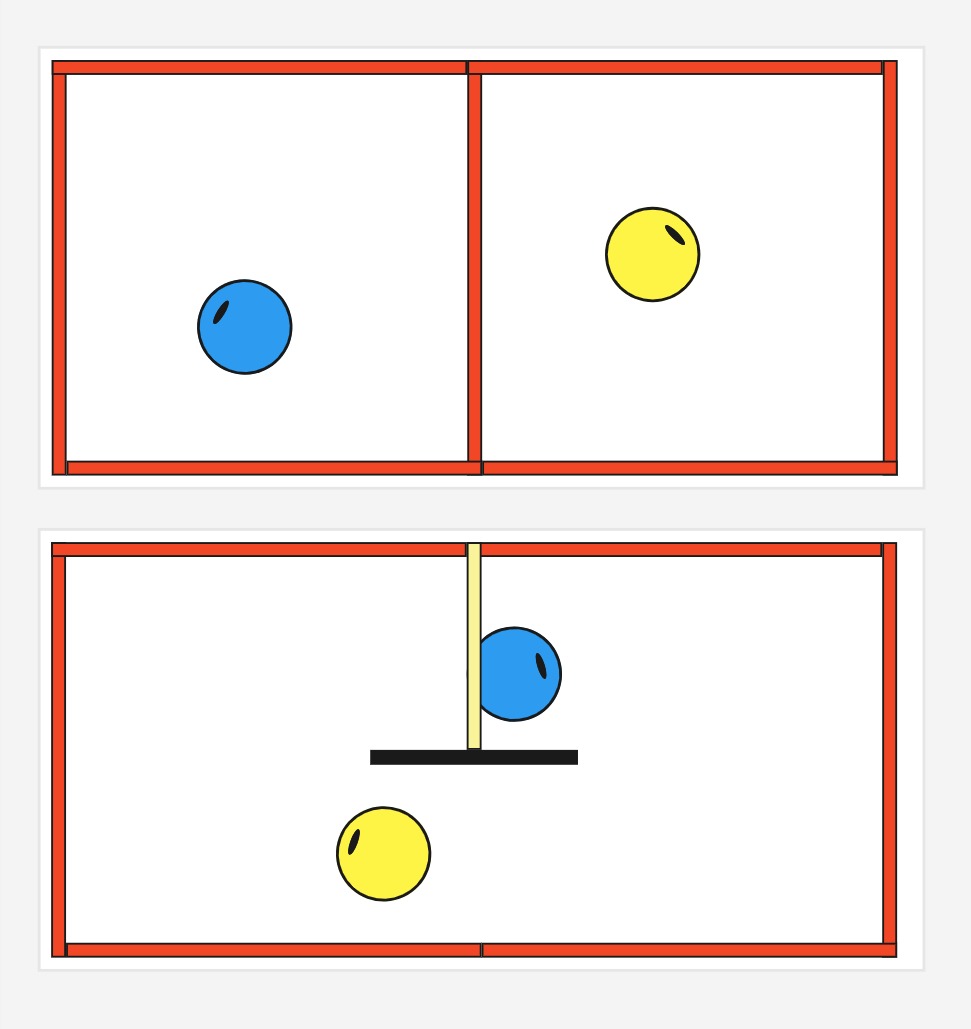

La simulation 2D (pour le robot AlphAI)

Si vous avez choisi le robot AlphAI simulé pour votre activité, en bas à gauche de votre écran apparaîtra une arène en 2D, et le robot simulé qui s’y déplace en direct.

Si vous souhaitez modifier cette arène simulée, ouvrez l’onglet Capteurs et scrollez en bas : vous pourrez alors ajouter/enlever l’îlot central et choisir la couleur des murs intérieurs et extérieurs.

.png)

Le niveau des piles

Si vous êtes connecté à un robot AlphAI, en bas à gauche de votre écran se trouve un indicateur du niveau de batterie du robot. Il y a 2 états :

- soit l'icône pile est verte, dans ce cas rien à signaler

- soit l'icône pile est rouge ou noire, dans ce cas nous vous conseillons de déconnecter le robot du logiciel et de changer ses piles immédiatement

Changer les piles d’un robot AlphAI

Les récompenses et niveau

Si vous avez choisi une activité avec apprentissage par renforcement, en bas de votre écran apparaîtront 2 barres : récompense (les récompenses données au robot en fonction des actions effectuées : en rouge si elles sont négatives et en vert si elles sont positives) et niveau (moyenne des récompenses reçues).

.png)

Une fois entrée sur l'interface principale du logiciel, le menu se situe en haut à gauche de votre écran et se présente comme ci-dessous :

Fichiers

Configurations d’exemple

choisissez une configuration d’exemple parmi toutes celles conçues par Learning Robots ! Vous trouverez le détail du déroulement de chaque activité sur les pages ressources du robot utilisé :

Activités AlphAI

.png)

Activités Thymio

.png)

Activités mBot

.png)

Ouvrir

- Permet de charger des données d’entraînement qui ont été enregistrées sur l’ordinateur (format .zip ou .npz - attention à charger des données qui correspondent à la configuration actuelle)

Sauvegarder

- Enregistrer la configuration : permet d’enregistrer la configuration actuelle sur l’ordinateur (format .json)

- Enregistrer la configuration et les données d'entraînement : permet d’enregistrer la configuration actuelle ainsi que les données issues de l'entrainement que vous venez d'effectuer (format .zip incluant la configuration au format .json)

- Enregistrer le projet complet : permet d'enregistrer la configuration actuelle, les données d'entrainements ainsi que le modèle d'IA utilisé (format .zip)

Language

- Choisissez dans quelle langue vous souhaitez utiliser le logiciel

Affichage des paramètres

Choisissez le niveau d'affichage des paramètres entre les modes standard (plus épuré), avancé et expert (toutes les options).

Nous vous conseillons de choisir le mode standard, à moins d’être familier avec AlphAI et d'avoir de bonnes connaissances en IA.

Raccourcis clavier

Permet d'activer/désactiver tout ou partie des raccourcis clavier du logiciel.

Activer le mode enseignant

- Si vous êtes enseignant, activer ce mode vous permettra d’accéder à de nouvelles fonctionnalités. Vous aurez besoin pour y accéder de votre clé d’activation.

Par exemple, dans le menu aide, vous pouvez cliquer sur “Informations sur les licences” pour connaître la liste d'appareils sur lesquels la licence a été activée.

Autres paramètres du programme...

- Taille des polices : changez la taille des polices sur le logiciel si vous souhaitez avoir une meilleure visibilité, par exemple des poids des connexions du réseau de neurones

- Big Brother : Cette option est utilisée en particulier dans notre activité "Éthique de l'IA". Une fois activée par le professeur en amont de la séance, le programme enregistre à l'insu des élèves les images prises par la caméra dans un sous-dossier du répertoire d'installation du logiciel, nommé "to_upload" expressément pour faire réagir.

Le professeur pourra montrer ce dossier dans un second temps aux élèves pour discuter avec eux des problématiques de collecte de données, avec ou sans consentement.

Les images sauvées sont automatiquement détruites à la fermeture du programme. Le logiciel AlphAI ne collecte ni ne transmet aucune information, et d'ailleurs fonctionne hors-ligne.

Cette option ne peut être utilisée que pour un but éducatif.

Outils

- Changer le dossier de configuration : permet de changer la localisation du dossier de configuration sur votre ordinateur. Ce dossier contient des fichiers de log et les paramètres du programme.

- Modifier l'emplacement des licences

- Télécharger le journal d'événements du robot : permet de télécharger le fichier de log du robot (nécessite une connexion en WiFi).

Utile à nous transmettre en cas de bug ! - Tester le robot : permet de détecter d’éventuelles défaillances matérielles sur le robot

Depuis l’écran de connexion, vous pouvez également trouver : - Mise à jour du robot : forcer la mise à jour du robot si elle n’a pas fonctionné automatiquement

- Diagnostiquer le démarrage du robot : vérifier que le démarrage du robot se passe correctement (Ce test prend environ 20 secondes. Une autre fenêtre s'ouvre lorsque le test est terminé)

Aides

- Documentation logiciel : permet d’accéder à la fiche logiciel des ressources du site Learning Robots. Vous y découvrirez tout ce qu’il y a à savoir sur le logiciel AlphAI.

- Documentation du robot et activités : permet d'accéder aux fiches relatives aux différents robots ainsi qu'aux activités, dans les ressources du site Learning Robots. Vous y découvrirez toutes les instructions et activités à réaliser pour chacun des robots, la FAQ, etc

- Journal des modifications : accédez à la liste des mises à jour

- À propos d’AlphAI : vous renseigne sur la version d’AlphAI que vous utilisez actuellement

- Afficher les raccourcis clavier

- Signaler un bug : Si vous rencontrez un problème que vous n’arrivez pas à résoudre, ce formulaire vous permet de nous transmettre un message qui sera associé au log du logiciel, et ainsi nous aidera à résoudre votre problème (merci de renseigner votre email afin que nous puissions vous recontacter si besoin)

Autonomie

.png)

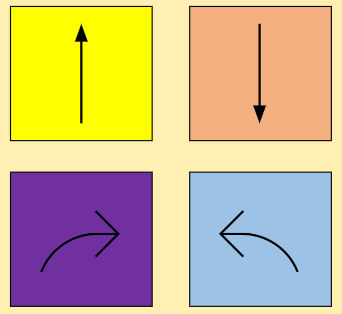

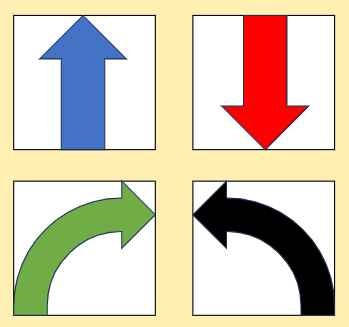

Contrôlez l’autonomie de votre robot grâce à ces différents boutons :

- Autonome : le robot est en autonomie continue

- Pas à pas : cliquez pour observer votre robot prendre une décision, et une seule ! Le robot ne fera qu’une étape à chaque fois que vous appuierez sur le bouton.

- Exploration : en mode apprentissage par renforcement, ce bouton vous permet de forcer votre robot à tenter de temps en temps une action aléatoire (paramétrable dans l’onglet IA).

Apprentissage

.png)

Contrôlez l’apprentissage de votre robot :

- Apprentissage : si ce bouton est sélectionné, le robot enregistre les données fournies dans sa mémoire d’expérience et change les connexions de son réseau de neurones. Il est en train d’apprendre !

En mode d'affichage expert, on a plus de contrôle :- acquérir des données : si ce bouton est activé, le robot mémorise les actions qu’il effectue.

- entraîner le modèle : si ce bouton est activé, l'algorithme d’apprentissage fait évoluer les valeurs des paramètres du modèle.

- Édition manuelle : dans les activités “Édition manuelle”, cliquez sur ce bouton pour modifier les paramètres du réseau de neurones directement depuis l’interface.

- Oublier l’action : si vous cliquez sur ce bouton, le robot oublie la dernière donnée qu’il a apprise : très pratique si vous vous trompez lors de la phase d’apprentissage !

- Réinitialiser l’IA : si vous cliquez sur ce bouton, les données d'entraînement et le modèle seront réinitialisés : recommencez maintenant l’apprentissage du robot !

En mode affichage expert, on a plus de contrôle :- Réinitialiser les données : efface les données d’apprentissage mémorisées

- Réinitialiser le modèle : les paramètres du modèle sont réinitialisés.

Graphes

.png)

Ce bouton vous permet d'ouvrir une fenêtre pop up qui vous donnera des informations sur l’apprentissage de votre robot, et des graphiques qui présentent ces données visuellement.

.png)

Ce graphe permet de suivre la progression du robot en affichant ses récompenses et l’erreur de ses prédictions au cours du temps. Si le robot progresse bien, le graphe des récompenses doit augmenter et celui des erreurs doit diminuer.

Dans le cas où il y a trop de bruit sur les données, vous pouvez lisser les courbes, par exemple sur 2 minutes, en cliquant sur lissage – 2 minutes

Réglages (pour AlphAI)

Réglez les paramètres de votre robot grâce à ce bouton :

- Vitesse (de 15 à 50) : vous pouvez régler la vitesse du robot, en fonction de l’activité et de la taille de l’arène utilisée

.png)

- Correction de trajectoire : il est possible que le robot ait un petit défaut de trajectoire. Utilisez cet outil pour le corriger (faites le test en utilisant l’action aller tout droit)

.png)

- Simulation accélérée : si vous avez choisi un robot simulé, ce bouton vous permet d'accélérer les prises de décision et actions du robot, au lieu d’imiter la vitesse réelle.

.png)

Déconnexion

Déconnectez-vous du robot grâce à ce bouton, pour changer les piles ou lorsque votre session est terminée !

⚠️ Si vous vous déconnectez du robot, vous reviendrez automatiquement à l’écran d’accueil. Cependant si vous reconnectez le robot et relancez l’activité sans quitter le logiciel, ni la configuration ni vos données d'entraînement ne seront perdues.

.png)

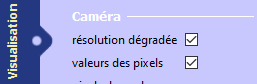

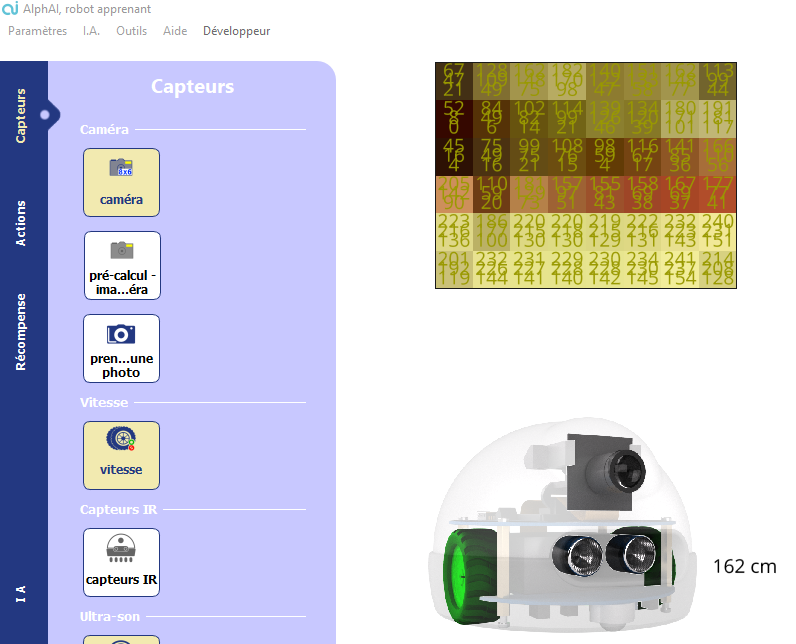

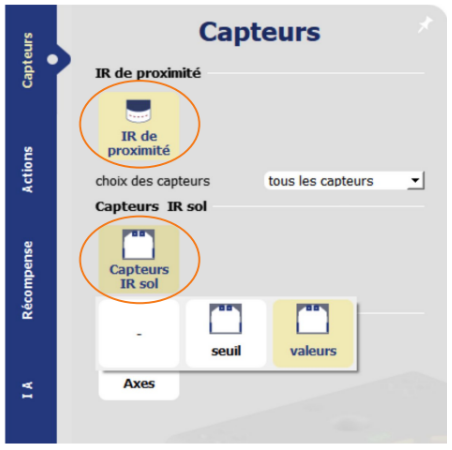

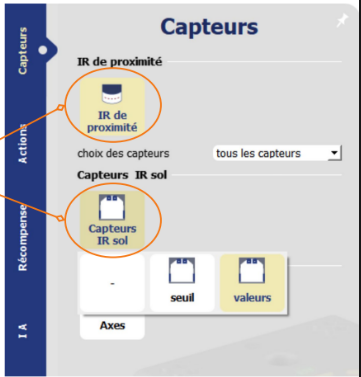

Onglet capteurs

.png)

La fenêtre Capteurs permet de choisir les capteurs du robot qui seront utilisés.

Cliquez sur un capteur pour choisir une des options d’utilisation possible.

Découvrez les différents capteurs utilisés en fonction des robots concernés :

Vous pouvez également choisir le nombre d’instants, et dans le cas d’un robot simulé changer les paramètres de l’arène.

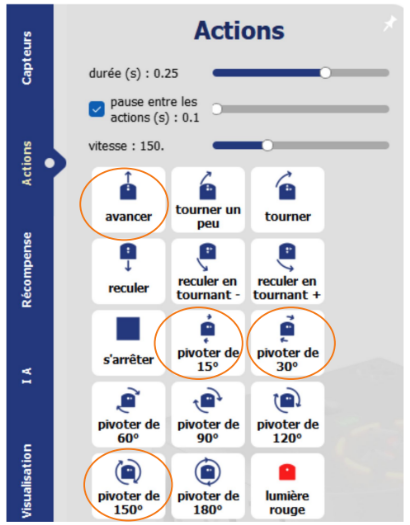

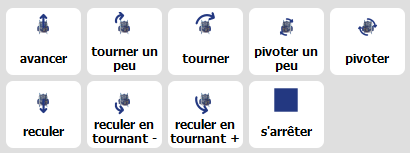

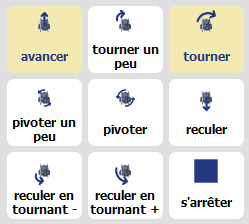

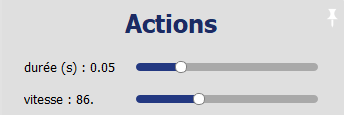

Onglet actions

.png)

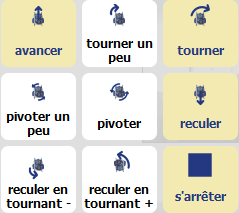

La fenêtre Actions permet de choisir les actions que peut effectuer le robot.

Cliquez sur une action pour l’ajouter au réseau de neurones.

⚠️ Ajouter une nouvelle action supprimera la mémoire d’expérience du robot.

Découvrez les différentes actions utilisées en fonction des robots concernés :

Vous pouvez également choisir la vitesse, la durée (de 0.1s à 2s), et si vous souhaitez que le robot effectue une pause entre les actions ou non, et de quelle durée.

Onglet récompenses

.png)

Si vous avez lancé une activité avec apprentissage par renforcement, vous pouvez utiliser l’onglet Récompenses pour choisir le type de récompense et la configuration de celle-ci.

Vitesse et blocage

Récompensez le robot si il va vite, punir s’il s’arrête. Vous pouvez personnaliser la récompense obtenue par le robot quand il effectue une action de virage, et la valeur de la pénalité quand il se bloque ou recule.

Couleur dans l’image

Récompensez le robot si beaucoup de pixels de la caméra sont d’une certaine couleur.

Vous pouvez personnaliser la teinte, la luminance et la saturation.

Couleur et blocage

Récompensez le robot si beaucoup de pixels de la caméra sont d’une certaine couleur, et le punir s'il s’arrête.

Vous pouvez personnaliser la teinte, la luminance et la saturation.

Suivi de ligne

Récompensez le robot s'il détecte du noir juste en dessous de lui. Vous pouvez personnaliser le seuil de détection de blocage.

Code Python

Paramétrez vos propres récompenses en utilisant un fichier de code Python.

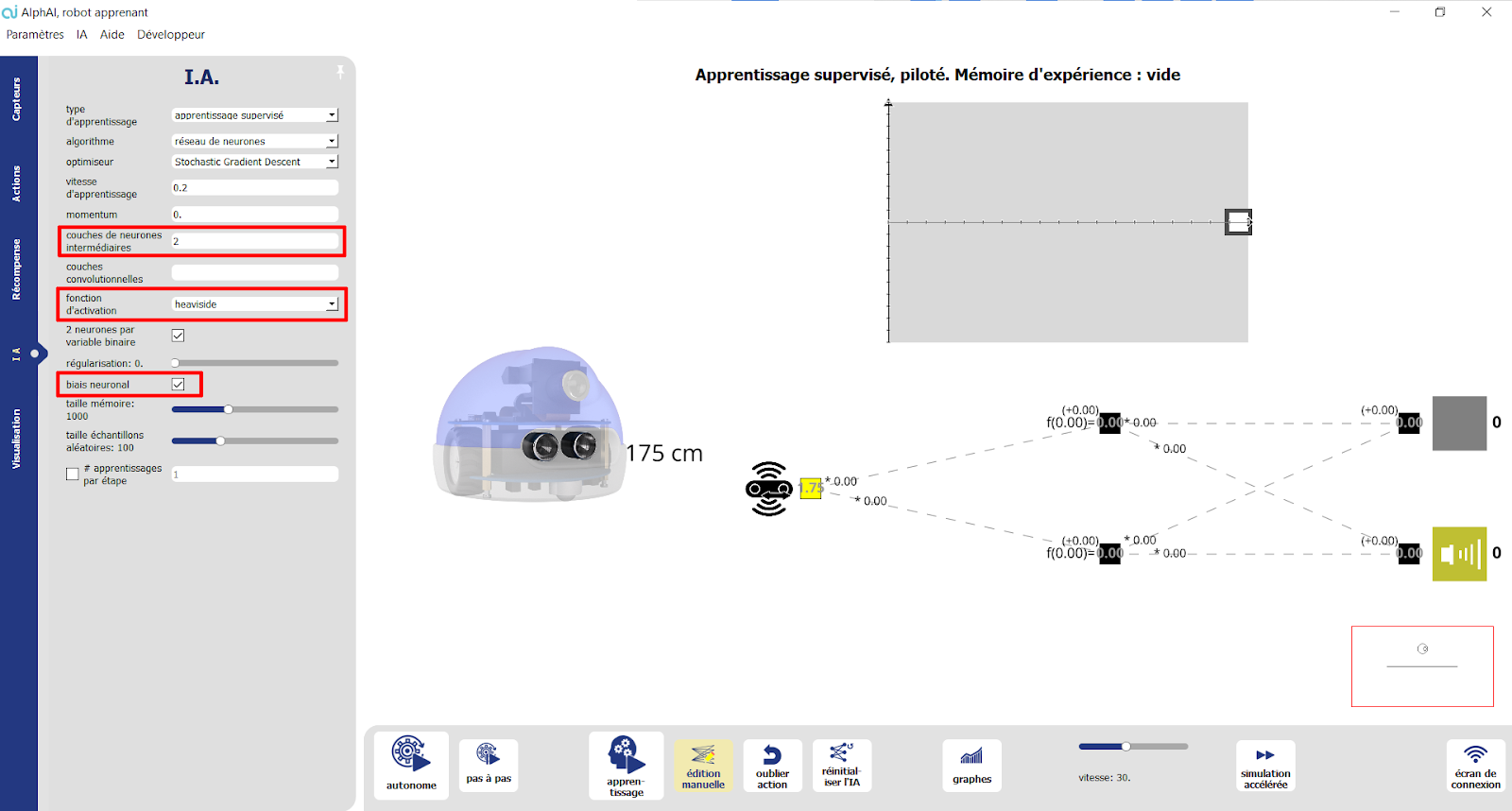

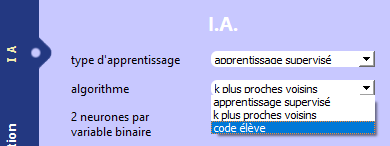

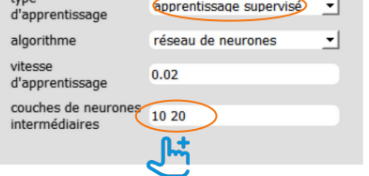

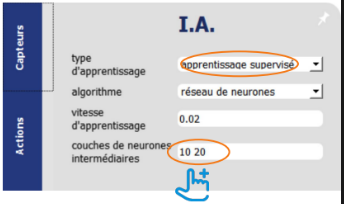

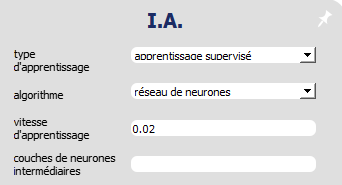

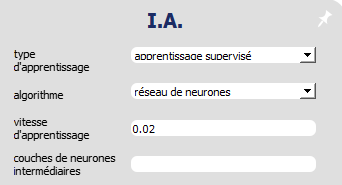

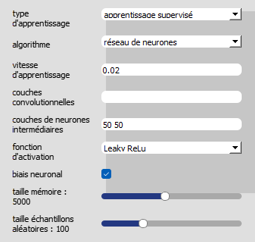

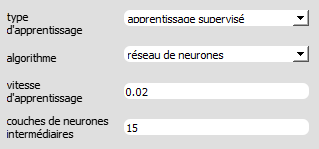

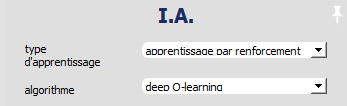

Onglet IA

.png)

L’onglet IA permet de choisir de quelle façon le robot est entraîné, notamment pour choisir entre apprentissage supervisé ou apprentissage par renforcement (Deep Q Learning). Elle permet aussi de régler les paramètres des différents algorithmes.

Les paramètres peuvent être différents d'une activité à une autre, d'un type d'apprentissage à un autre et d'un algorithme à un autre. Mais les principaux paramètres sont les suivants :

- Type d’apprentissage

- Apprentissage supervisé

- Apprentissage par renforcement

- Aucun

- Algorithme : Sélectionner l’algorithme d’IA utilisé

- Réseau de neurones

- K plus proches voisins

- Code python

- Vitesse d’apprentissage : Augmenter pour des apprentissages plus rapides... mais diminuer si des erreurs de divergence apparaissent.

- Gamma : Ajuste l’importance donnée aux récompenses immédiates (valeur proche de 0) par rapport aux récompenses plus éloignées dans le temps (valeur proche de 1)

- Exploration : Fréquence des explorations (valeur entre 0 et 1).

- Couches de neurones intermédiaires : Nombre de neurones de chaque couche intermédiaire par exemple : ne rien mettre pour connecter directement les entrées aux sorties, mettre «100 50» pour deux couches intermédiaires de respectivement 100 et 50 neurones.

- Fonction d’activation : choix de la fonction d’activation des couches intermédiaires.

- 2 neurones par variable binaire : Cocher pour que les entrées binaires soient représentées par 2 neurones (dont toujours un et un seul sera activé) ; Décocher pour utiliser seulement 1 neurone.

- Biais neuronal : Cocher pour permettre aux neurones d’ajuster leur seuil d’activation (cela revient à considérer que tous les neurones reçoivent une entrée constante qu’ils peuvent ajuster, non représentée dans l’interface graphique).

- Mémoire d’expérience : Cocher pour que l’IA continue d’apprendre à partir des actions effectuées et récompenses reçues par le passé.

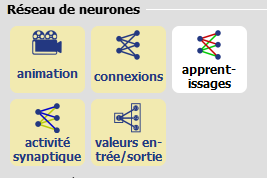

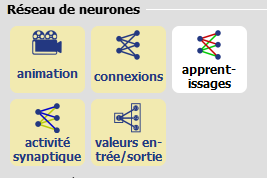

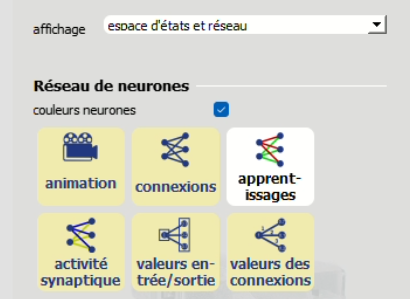

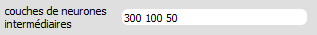

Onglet Visualisation

.png)

L’onglet Visualisation permet de choisir ce qui est affiché ou non sur l’écran principal.

- Type d’affichage : réseau de neurones, espace d’états, ou les deux

- Animation : Animer l’activité dans le réseau (mouvement des entrées vers les sorties)

- Connexions : Afficher les connexions du réseau

- Apprentissages : Afficher les apprentissages

- vert : les connexions s’intensifient

- rouge : les connexions diminuent

- Activité synaptique : Afficher l’activité dans le réseau

- jaune : activités d’excitation

- bleu : activités d’inhibition

- Valeur des entrées/sorties : Afficher les valeurs des neurones d’entrée et de sortie

- Valeur des connexions : Afficher les poids des connexions. Cette option active automatiquement l'affichage des entrées/sorties.

- Espace entre les neurones : fait passer les neurones d’entrée du mode vertical au mode horizontal

Pour le robot AlphAI uniquement : vous pouvez changer la couleur de la coque. Attention : le robot va mémoriser sa nouvelle couleur et apparaîtra ainsi sur l’écran de connexion.

La solution AlphAI dispose de deux méthodes permettant de programmer les robots avec le langage python :

- Avec l'API python, vous avez accès à une interface de bas niveau. Vous disposez d'un accès direct aux valeurs brutes des capteurs du robot, et vous pouvez contrôler directement et séparément les deux moteurs. En revanche, ce mode ne dispose d'aucune option de visualisation. Il est donc plutôt adapté aux activités centrées sur la programmation en elle-même.

- Avec le mode code python accessible depuis le logiciel, vous avez accès à une interface de plus haut niveau. Les capteurs et les actions du robots sont paramétrables depuis la fenêtre graphique. Ce mode dispose de plusieurs options qui permettent de visualiser le programme dans la fenêtre graphique. Il est adapté à la pratique de la programmation, en particulier dans le cas d'utilisation d'algorithmes de machine learning.

Ci-dessous, vous trouverez plus de détails sur ces deux méthodes.

Documentation API AlphAI (robots AlphAI uniquement)

Dans ce document, vous trouverez toutes les informations nécessaires à l'utilisation de l’API AlphAI :

https://drive.google.com/file/d/1C4ovPW_eH5KFz5Y9JvSrzLhtmdOpcp6-/view

Le mode "code python"

Dans l’onglet IA

.png)

Vous pouvez choisir pour le paramètre algorithme “code python”.

Un pop up apparaît, il faut choisir entre créer un nouveau fichier ou ouvrir un fichier existant.

Ce fichier permettra d’écrire du code python qui sera exécuté par le logiciel.

Dans l’onglet Récompense (robots AlphAI uniquement)

.png)

Programmez votre propre fonction de récompense en cliquant sur le bouton “code python”.

Learning Robots travaille continuellement à développer les fonctionnalités du logiciel et à améliorer l’expérience utilisateur.

C’est la raison pour laquelle nous procédons régulièrement à des mises à jour, qui démarrent après approbation au lancement du logiciel si vous êtes connectés en WiFi. Elles ne prennent que quelques minutes !

Nous vous conseillons de mettre à jour tous les postes en même temps, pour être sûr d’avoir la même version du logiciel sur chaque poste.

Si vous avez des questions supplémentaires, vous pouvez rechercher celles-ci dans notre FAQ ou bien nous écrire via notre formulaire de contact.

Pour consulter la liste des modifications réalisées lors de chacune des mises à jour depuis la création du logiciel, veuillez vous reporter sur la page suivante :

Liste des modifications AlphAI

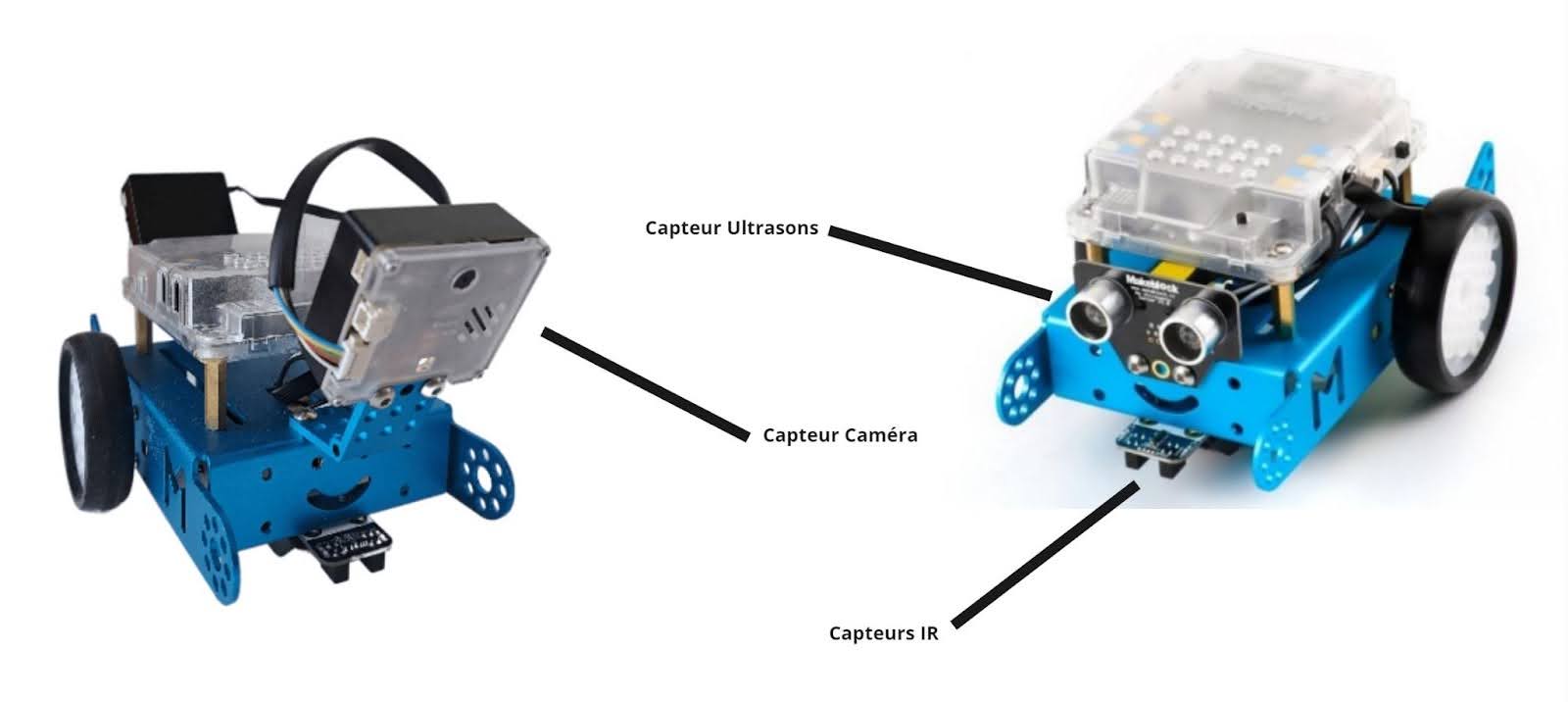

Introduction

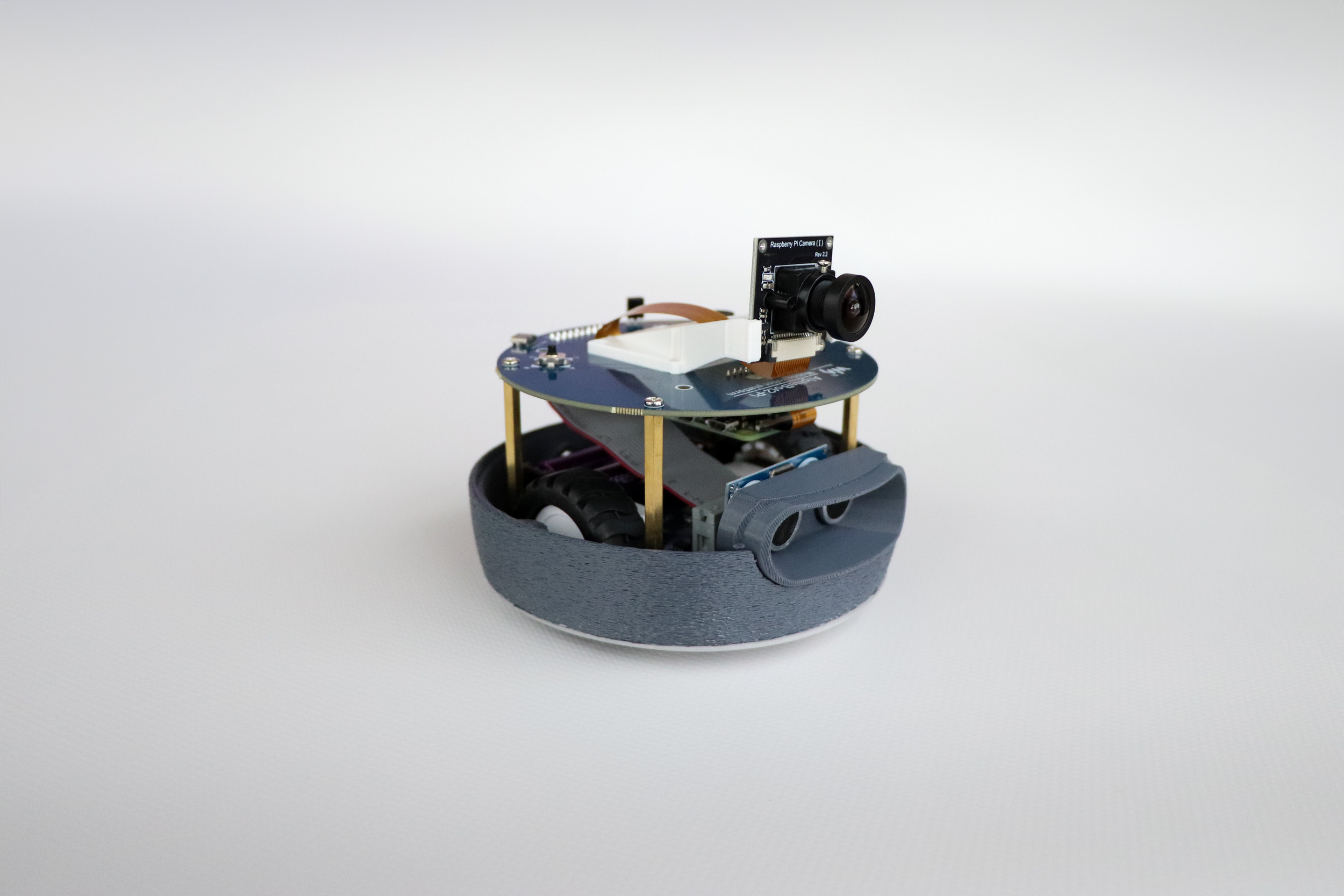

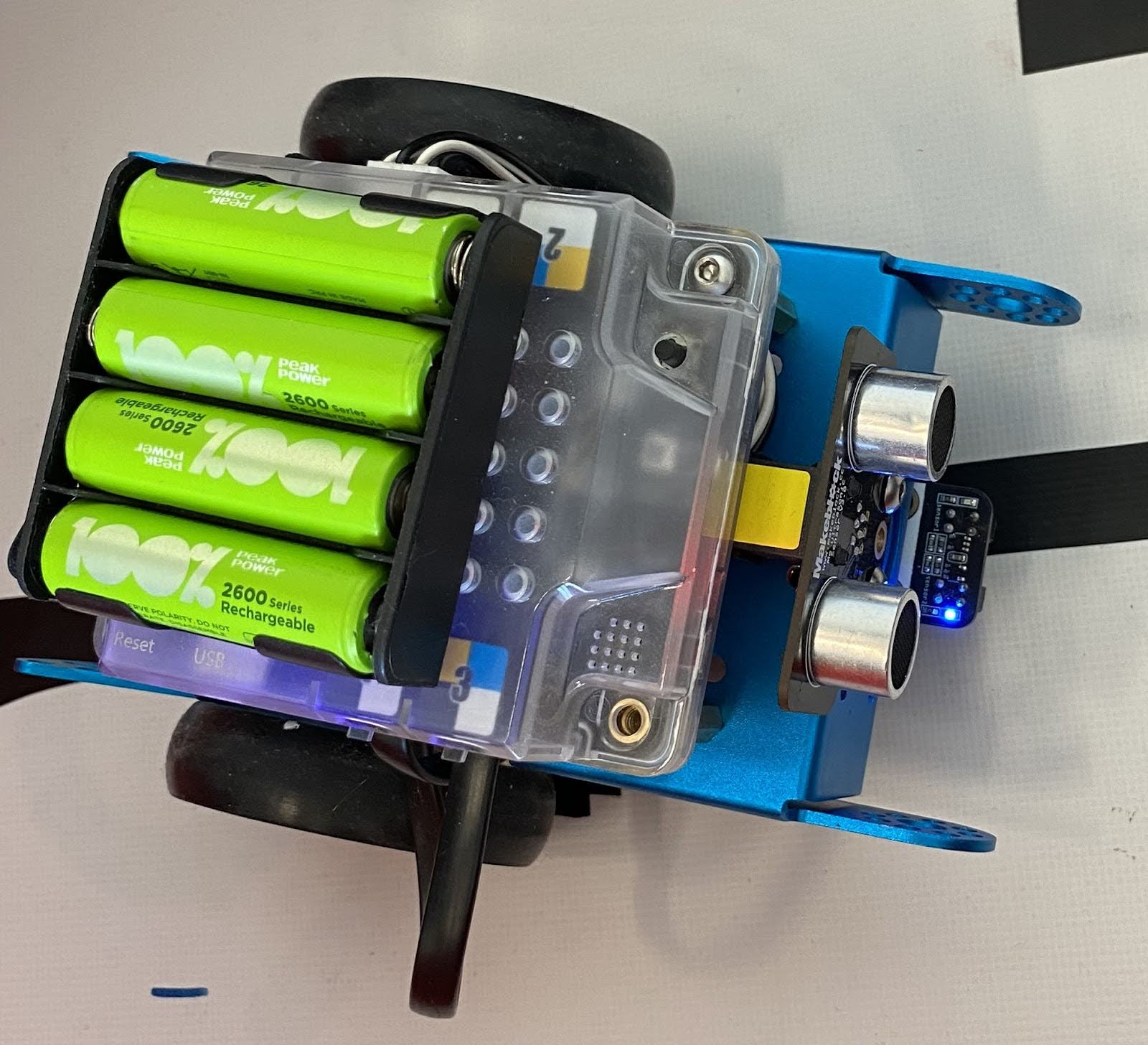

Learning Robots a conçu un petit robot à l’allure sympathique, mais qui en a sous le capot !

Ce robot a été élaboré spécifiquement pour l’utilisation de la solution AlphAI : son grand nombre de capteurs (notamment la caméra grand angle), sa polyvalence et son format compact permettent de réaliser l’intégralité des activités disponibles sur le logiciel.

Ce robot a été pensé pour être à la fois robuste et démontable à n’importe quel moment.

Les coques et pare-chocs sont imprimés chez nous ce qui nous laisse une grande marge de liberté quant au design du robot. N'hésitez pas à nous demander les fichiers 3D via notre formulaire de contact si vous souhaitez les customiser !

Composition

Capteurs

- Caméra grand angle

- Ultra-son

- 5 capteurs infra-rouge de suivi de ligne

Effectuateurs

- 2 roues motrices

- 4 LEDS multi-couleurs

- Buzzer

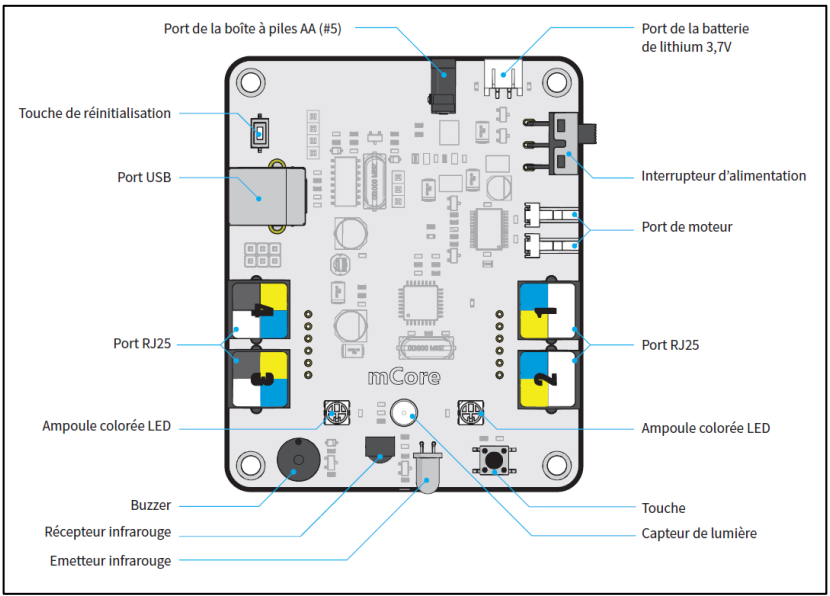

Ordinateur de bord

- Raspberry Pi Zero (linux, Python)

- Connection WiFi & Bluetooth au PC

Coque

Sympathique, amortissante, démontable, disponible en 8 coloris

Les capteurs

Les capteurs que vous pouvez utiliser sur le logiciel sont :

- La détection d’obstacles (blocage des roues) : permet d’ajouter une entrée binaire (1 si le robot a essayé de bouger mais n’a pas réussi, 0 dans le cas contraire).

En mode expert, vous avez accès à deux paramètres supplémentaires :- seuil de détection de mouvement de la caméra : permet de paramétrer la sensibilité du détecteur d’obstacles. Il faut augmenter la valeur si on a trop de faux positifs (capteur qui détecte un obstacle inexistant), et inversement diminuer la valeur si on a trop de faux négatifs (capteur qui ne détecte pas un obstacle réel).

- hauteur de blocage de la caméra : permet d’ignorer la partie haute de l’image lors de la détection des blocages. Avec une valeur de 1, l’image entière est analysée, avec une valeur de 0.5, seule la moitié inférieure est analysée.

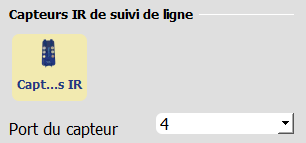

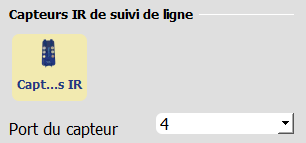

.png)

- Capteurs IR : permet d’utiliser les 5 capteurs infrarouges situés sous le robot. Ils communiquent chacun une valeur entre 0 et 1 en fonction de la luminosité de la surface. Il y a deux modes principaux :

- Détection du noir : la valeur 0 correspond au blanc et la valeur 1 correspond au noir. Recommandé pour suivre une ligne noire sur fond blanc.

- Détection de la réflexion : la valeur 0 correspond au noir et la valeur 1 correspond au blanc.

L'option mode binaire permet d'obtenir uniquement des valeurs entières 0 et 1 au lieu de valeurs décimales entre 0 et 1.

Lorsque le mode binaire est actif, le paramètre seuil IR permet de fixer le seuil de bascule entre les valeurs binaires 0 et 1. Par exemple, lorsque le seuil vaut 0.5 (valeur par défaut), toutes les valeurs entre 0.5 et 1 sont arrondies à 1, et toutes les valeurs entre 0 et 0.5 sont arrondies à 0.

Il y a aussi plusieurs boutons (5 capteurs, capteur central, capteurs intérieurs, capteurs extérieurs) qui permettent de sélectionner quel sous-ensemble des capteurs IR on souhaite activer.

.png)

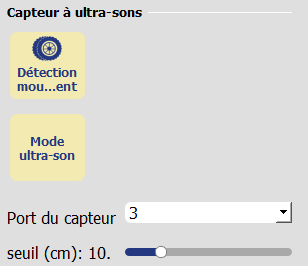

- Ultra-Sons : permet d’utiliser le capteur à ultra-sons situé à l’avant du robot. Il communique une valeur en fonction de la distance captée. Il y a 3 modes d'utilisation:

- distance obstacle : la valeur renvoyée est la distance de l'obstacle mesurée en mètres.

- proximité obstacle : la valeur renvoyée est inversement proportionnelle à la distance mesurée.

- Absence / présence obstacle : le capteur renvoie 1 si un obstacle est détecté et 0 sinon. La distance de détection des obstacles peut être ajustée grâce au curseur en-dessous.

.png)

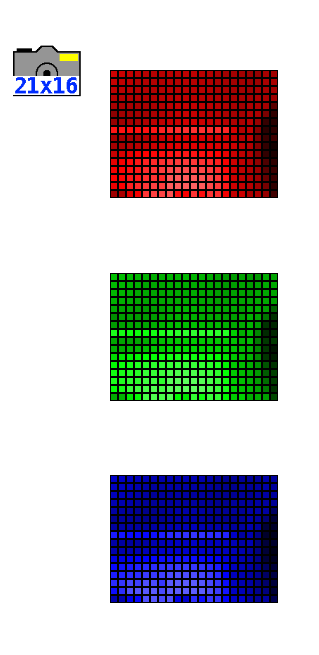

- Caméra : permet d’activer la caméra à l’avant du robot. Plusieurs options sont proposées, qui déterminent la résolution de la caméra et l'utilisation ou non du zoom.

Le bouton pré-calcul image caméra permet de modifier les valeurs traitées :

- lorsque le pré-calcul est désactivé, l'image est par défaut en couleurs (système RGB).

- le mode niveaux de gris capture la luminosité de chaque pixel.

- le mode couleur dans l'image détecte les couleurs. Tous les pixels blanc/gris/noirs vont obtenir la valeur 0 et les pixels de couleur la valeur 1.

- le mode canal vert détecte uniquement la présence de vert (valeurs proches de 1) ou son absence (valeurs proches de 0).

- le mode rouge vs vert renvoie pour chaque pixel une valeur entre -1 et 1 qui correspond à la quantité de rouge moins la quantité de vert.

Le bouton prendre une photo permet de prendre une photo avec la caméra du robot et de l'enregistrer sur votre ordinateur.

.png)

.png)

- Le bouton dernières actions permet d'activer la mémoire de la dernière action lorsque le robot doit prendre une décision. Cela peut être utile par exemple pour éviter les situations où le robot effectue une action qui annule l'action précédente (il recule après avoir avancé, ou il pivote à droite après avoir pivoté à gauche).

- En mode robot simulé, le capteur état du robot simulé renvoie des informations sur la position, l'orientation et la vitesse du robot simulé.

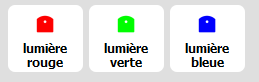

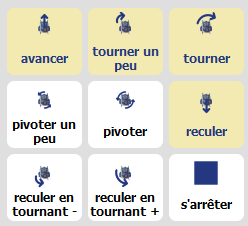

Les actions

Les actions que vous pouvez utiliser sur le logiciel sont :

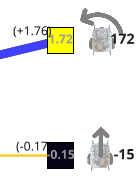

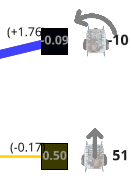

.png)

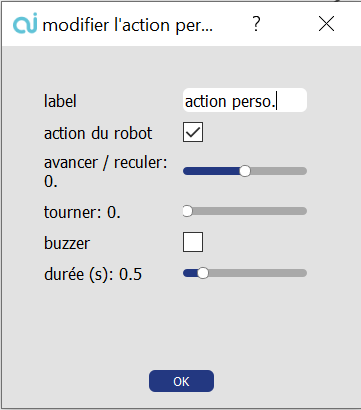

Vous pouvez également créer une action personnalisée en cliquant sur le bouton :

La fenêtre suivante va alors apparaître :

.png)

Nommez votre action et cochez “action du robot” pour modifier les paramètres : la nouvelle action est désormais disponible.

Pour l'enregistrer et pouvoir la réutiliser dans le futur, cliquez sur Fichier > Sauvegarder > Enregistrer la configuration.

Environnement d’utilisation

Nous vous recommandons d’utiliser le robot dans une arène AlphAI que vous retrouverez dans notre Boutique en ligne.

Pour réaliser l’intégralité des activités sur le logiciel, le robot aura besoin de :

- Une surface très plane et propre, de couleur unie

- Des murs extérieurs et intérieurs de couleurs différentes (et différente du sol), d’une hauteur supérieure au robot

- D’une ou plusieurs lignes au sol d’une couleur très contrastée avec la bâche (utilisez par exemple un scotch noir ; il est fourni avec les arènes.)

Si vous ne disposez pas d’arène ou même de robot, sachez également que de nombreuses activités sont réalisables avec le robot AlphAI simulé en 2D dans le logiciel.

En Wifi (recommandé)

Nous vous conseillons de toujours privilégier une connexion en WiFi si cela est possible, car elle permet de communiquer avec le robot avec un meilleur débit. De plus, elle est obligatoire pour la mise à jour des robots.

- Regardez le numéro inscrit au marqueur sous votre robot, en prenant garde à le tenir par sa base et non sa coque, puis allumez le robot en actionnant l'interrupteur PWR SWITCH sur ON

- Posez le robot dans l’arène et patientez quelques instants, jusqu’à ce que le robot vibre et clignote.

- Ouvrez le panneau de connexion WiFi de votre ordinateur : le robot apparaîtra alors sous le nom “ALPHAI-00XXXX” (XXXX étant le nombre que vous avez relevé sous le robot). Connectez-vous au robot : le mot de passe est la copie exacte du nom du réseau WiFi (ALPHAI-00XXXX).

- Lancez le logiciel AlphAI. Vérifiez en haut à droite de l’écran d’accueil que vous avez choisi le modèle de robot AlphAI

- Le robot avec son numéro et une icône Wifi apparaît alors sur l’écran de connexion : cliquez dessus

- Le robot vibre, ses lumières s’allument en continu et l’interface du logiciel s’ouvre. C’est parti !

⚠️ Avant d’éteindre votre robot ou de changer ses piles, nous vous conseillons d’appuyer sur le bouton “déconnexion” en bas à droite de l’écran dans l’interface.

En Bluetooth

Si vous préférez connecter le robot à votre ordinateur en bluetooth, sachez que le débit de transmission est plus faible qu’avec le WiFi. De plus, quand le robot aura besoin d’être mis à jour, il faudra utiliser la connexion en WiFi.

- Regardez le numéro inscrit au marqueur sous votre robot, en prenant garde à le tenir par sa base et non sa coque, puis allumez le robot en actionnant l'interrupteur PWR SWITCH sur ON

- Posez le robot dans l’arène et patientez quelques instants, jusqu’à ce que le robot vibre et clignote.

- Dans les paramètres de votre ordinateur, vérifiez que le bluetooth est bien activé

- Lancez le logiciel AlphAI. Vérifiez en haut à droite de l’écran d’accueil que vous avez choisi le modèle de robot AlphAI

- Veillez à ce que le bouton “Bluetooth Low Energy” en haut à droite de votre écran soit bien activé (avec un fond jaune).

- Le robot avec son numéro et une icône Bluetooth apparaît alors sur l’écran de connexion : cliquez dessus

- Le robot vibre, ses lumières s’allument en continu et l’interface du logiciel s’ouvre

⚠️ Avant d’éteindre votre robot ou de changer ses piles, nous vous conseillons d’appuyer sur le bouton “déconnexion” en bas à droite de l’écran dans l’interface.

Votre robot n’apparaît pas ? → désactivation BLE

En simulation

Si vous n’avez pas de robot AlphAI, vous pouvez tout de même utiliser notre logiciel grâce au simulateur 2D :

- Lancez le logiciel AlphAI

- Vérifiez en haut de l’écran que vous avez choisi le modèle de robot AlphAI dans le logiciel.

- Cliquez sur “Simulateur 2D”

- Le logiciel s’ouvre : observez en bas à gauche de l’écran un petit robot simulé dans une arène en 2D !

- L’arène virtuelle peut être customisée en changeant les couleurs des murs extérieurs et intérieurs ainsi qu’en supprimant ce mur. Pour y accéder, vous devez activer le mode expert en procédant comme suit : Fichier → Affichage des paramètres → Expert puis en allant dans l'onglet Capteurs (sur la gauche de votre écran), vous trouverez tout en bas l'ensemble des paramètres de l'arène virtuelle.

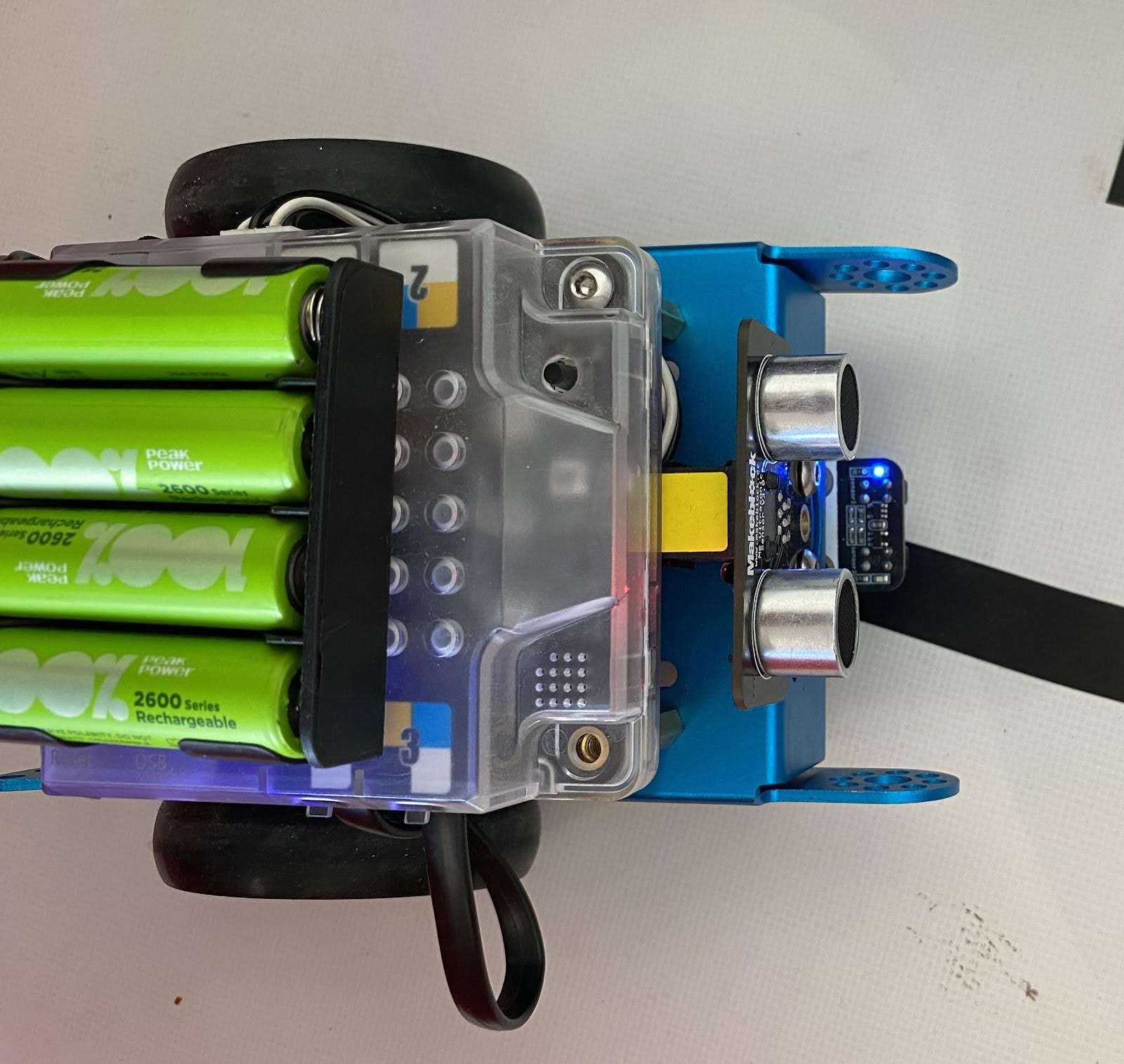

Remplacement des piles

Le robot utilise des piles rechargeables en lithium-ion qui sont donc très puissantes mais se déchargent rapidement. C’est pourquoi nous vous conseillons de toujours garder les piles de rechange fournies chargées à proximité.

Si les piles du robot sont sur le point d’être à plat, une icône de batterie rouge apparaîtra sur votre écran en bas à gauche. Changez les piles en moins d’une minute :

- Appuyez sur le bouton “déconnexion” en bas à droite de l’écran. Vous allez atterrir sur l’écran d’accueil

- Soulevez le robot en prenant garde à le tenir par sa base et non sa coque, puis éteignez le en mettant l'interrupteur PWR SWITCH sur OFF

- Retirez la coque du robot en exerçant une pression délicate sur sa base, puis en la faisant pivoter vers l’avant pour dégager la caméra

- Les piles se trouvent à l’arrière : glissez le doigt pour les remplacer avec des piles chargées en veillant à bien respecter les signes + et -

- Nous vous conseillons de mettre immédiatement les piles vides à recharger sur le chargeur AC fourni

- Remettre la coque sur le robot en commençant par l’avant ; veillez à bien positionner la caméra dans son emplacement, puis vérifiez que toute la base de la coque est insérée dans le châssis du robot. Appuyer délicatement sur l'arrière de la coque : vous devriez entendre un petit “clic”

- Rallumez le robot, reconnectez-le et reprenez votre activité !

Nous vous conseillons de toujours mettre à charger les piles utilisées pendant les activités en fin de session.

Mises à jour du robot

Learning Robots travaille continuellement à développer le logiciel, le robot AlphAI ainsi qu'à améliorer l’expérience utilisateur. C’est la raison pour laquelle nous procédons régulièrement à des mises à jour, qui seront transmises automatiquement à la Rapsberry Pi du robot lors de la prochaine connexion en WiFi.

Voir FAQ.

Problèmes récurrents

Votre robot ne s’allume plus ? Impossible de vous connecter au logiciel ? Les roues de votre robot sont bloquées ?…

Trouvez la réponse à votre problème sur cette page :

Voir FAQ.

Support & garantie

Les robots AlphAI sont garantis jusqu’à 2 ans après la date d’achat pour tout malfonctionnement.

En cas d'utilisation intensive, il est normal que les moteurs puissent présenter de l'usure : nous proposons des kits de remplacement de moteur, que vous pouvez retrouver dans notre boutique en ligne. N'hésitez pas à nous contacter si vous souhaitez que nous nous chargions du remplacement.

L’équipe de Learning Robots reste à votre disposition. Si vous ne trouvez pas comment résoudre votre problème sur notre page FAQ, n’hésitez pas à nous contacter via notre formulaire de contact.

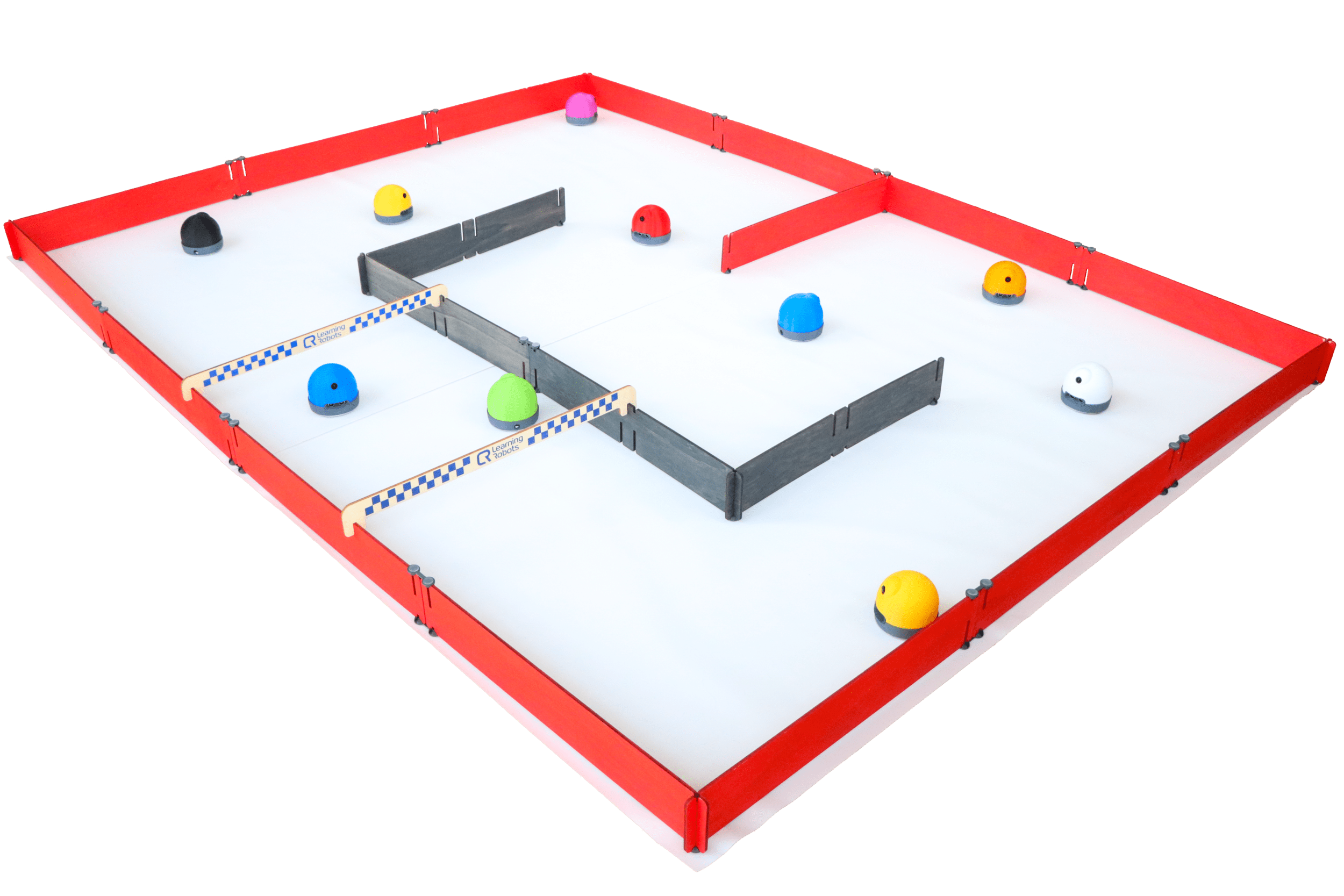

Afin de faire évoluer le robot dans un environnement parfaitement adapté, Learning Robots a conçu un système d’arènes modulaires très facile à assembler et à transporter.

Les arènes sont disponibles dans 4 tailles différentes qui sont combinables selon vos besoins et le nombre de robots.

Elles sont constituées de planches en bois peintes, de bâches et de supports.

Elles sont fabriquées en pin du Jura par Olivier Sauge (https://www.saugeartisansdubois.com) en France.

Composition

- bâche(s) à poser sur le sol, avec design imprimé ou non, sur une surface parfaitement plane. Assemblez les bâches grâce au scotch de peintre (inclus) pour augmenter la surface de l’arène !

- planches rouges, qui constituent les murs extérieurs de l’arène, à assembler grâce à leurs encoches et aux supports

- planches noires, qui constituent les murs intérieurs de l’arène, à assembler grâce à leurs encoches et aux supports. Maintenez les planches noires aux planches rouges grâce aux bannières de course

- bannière(s) de course, qui permettent de joindre les murs intérieurs et extérieurs, tout en créant un départ de course pour vos robots ! Elles sont fournies avec des réhausseurs

- Supports :

- Pieds : à utiliser dans les angles sous les encoches (planches qui s'emboîtent) ou aux extrémités. Il n'est pas nécessaire d'en mettre sur le dessus.

- Connecteurs : à utiliser pour assembler des planches en ligne droite. Il est conseillé d'en mettre à la fois en-dessous et au-dessus des connexions. Ils peuvent être utilisés parallèlement mais aussi perpendiculairement aux planches, en fonction de la disposition souhaitée.

Le montage

- Commencez par poser les bâches au sol, sur une surface très plane, et maintenez-les ensemble grâce au scotch de peintre pour plus de stabilité

- Assemblez les murs extérieurs grâce aux encoches et aux supports (seulement en dessous pour les pieds)

- Positionner le(s) mur(s) intérieur(s) au centre de l’arène avec leurs supports pieds

- Reliez les murs intérieurs et extérieurs grâce à la ou les bannière(s) de course, en veillant à bien surélever celle(s)-ci avec les réhausseurs fournis

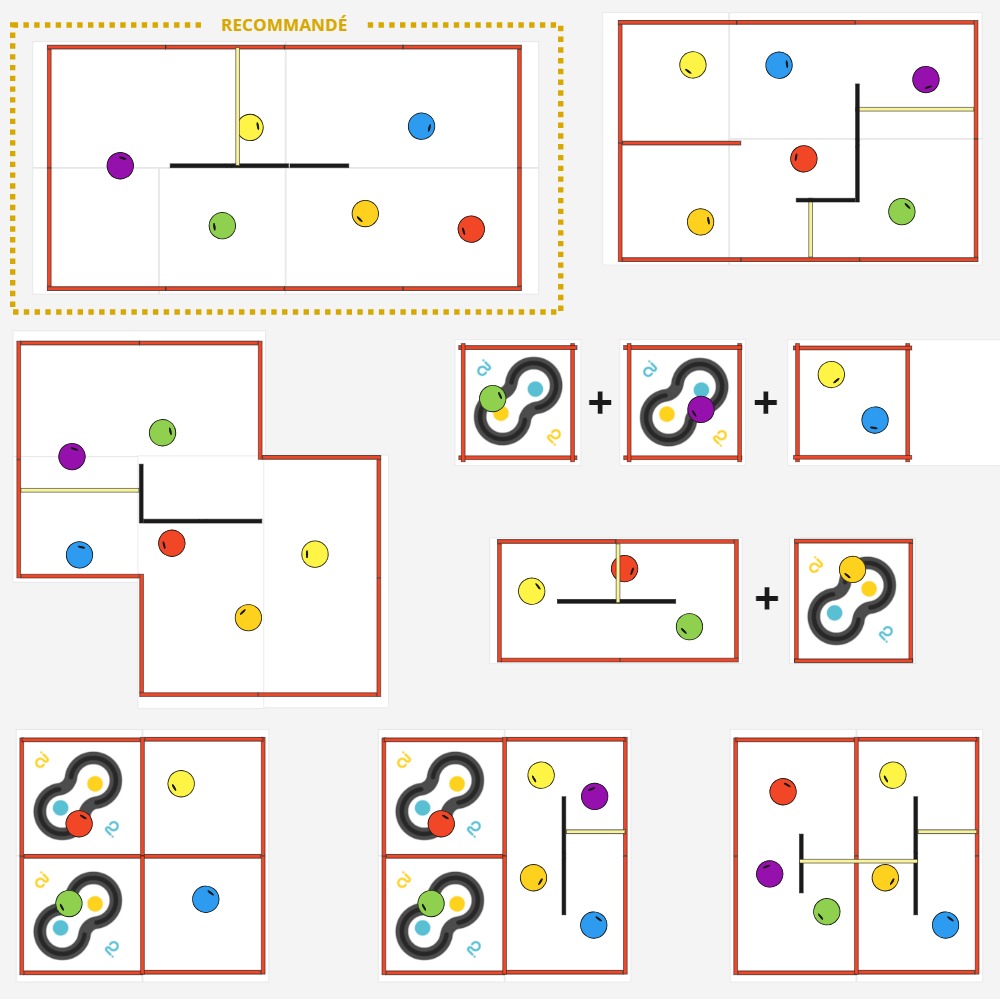

Les arènes sont modulables à votre guise ! Voici quelques exemples de dispositions :

⚠️ Si vous avez une planche noire simple au centre de l'arène (et qui ne peut pas être maintenue aux planches rouges extérieures grâce à la bannière de course), nous vous conseillons de doubler cette planche en utilisant des connecteurs afin d'avoir plus de stabilité.

Utilisation scotch

Grâce au scotch noir fourni avec votre arène, vous pouvez tracer au sol des lignes à suivre par votre robot ! Elles sont très facilement décollables de la bâche à la fin de l’activité. Voir Activité AlphAI Suivi de Ligne

Le tracé le plus courant est une forme de 8, mais n’hésitez pas à faire parler votre imagination ! Préconisez des courbes douces afin de ne pas perturber le robot.

Matériel nécessaire :

- 2 robots minimum

- 1 ordinateur/robot

- Arène de course

Les + de cette activité :

- Ludique

- Appréciée de tous les âges

- Parfaite pour introduire le principe de l’apprentissage supervisé

Durée :

40 à 60 minutes

Age :

+ 8 ans

Configuration logiciel :

Mode "course de robot"

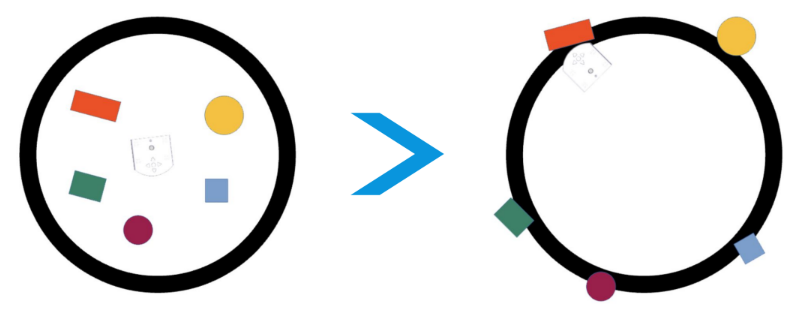

Activité ludique pour une arène avec plusieurs robots : les élèves entraînent les robots à rouler dans un circuit puis une course est organisée. Les élèves apprennent par la manipulation le principe de l'apprentissage supervisé et l'importance de la qualité des données d'entraînement.

La course de robots est l’activité recommandée pour débuter la solution AlphAI.

Introduction

Construisez votre arène de manière à former un circuit. Nous vous recommandons d’utiliser une arène de course conçue par Learning Robots, mais vous pouvez également construire votre propre circuit : veillez dans ce cas à ce qu’il y ait un bon contraste visuel entre le sol et les bords du circuit, que l'éclairage soit uniforme et que le sol soit propre.

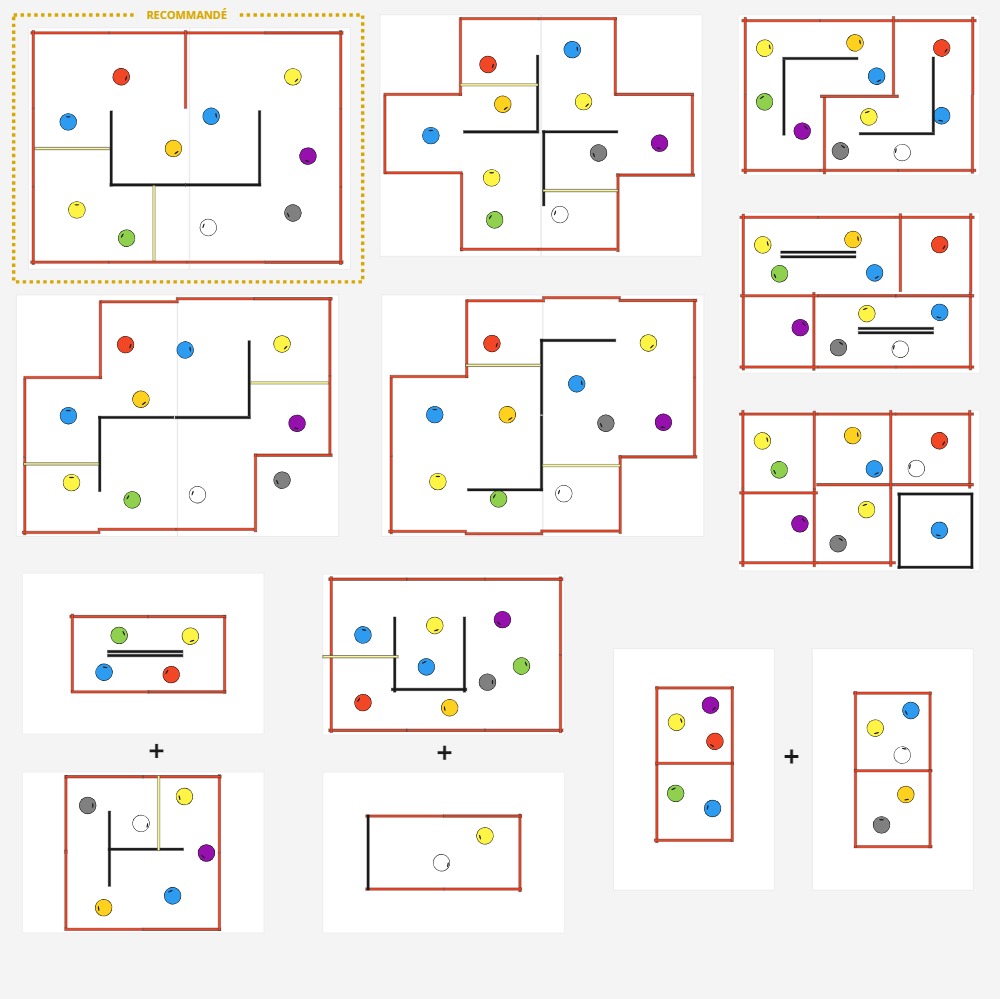

Paramétrage

Connectez chaque robot à un ordinateur, puis choisissez le configuration d'exemple “course de robots” ou créez vos propres paramètres.

Veillez à vérifier que tous les robots ont les mêmes paramètres et surtout la même vitesse.

Entraînement

Vérifiez que le bouton « autonome » est bien désactivé, et que le bouton “apprentissage” est bien activé.

C’est à vous de jouer ! Chacun entraîne son robot à se déplacer en cliquant sur les actions à droite de l’écran ou en le contrôlant avec les flèches directionnelles ou AZEQSD du clavier.

Nous vous conseillons de faire des tours d’arène dans le sens des aiguilles d’une montre.

Pendant cette phase d’apprentissage, ce n’est pas la peine de chercher à aller vite : le but est surtout d’apprendre au robot à faire des tours dans le bon sens et sans se cogner aux murs. Prenez le temps de bien choisir l’action adéquate à chaque fois (si vous vous trompez, cliquez sur “Oublier action” à côté du bouton apprentissage). Faites attention à ne pas confondre la gauche et la droite quand le robot est en sens inverse !

Apprenez au robot à rester loin de l’obstacle central pour éviter qu’il s’y coince lorsqu’il sera autonome.

Vous pouvez également déplacer le robot à la main pour le mettre intentionnellement face à des obstacles et lui apprendre quoi faire dans ces situations.

Dans le panneau de contrôle en bas de l’écran, vous pouvez fixer la vitesse de pointe du robot. Nous vous conseillons une vitesse maximale de 30 pour une arène petite course, 35 pour une arène grande course, et 40 pour une arène très grande course.

Plus vous augmentez la vitesse, plus le robot sera rapide, mais plus il sera difficile à contrôler. Choisir une vitesse très élevée n’est pas toujours un avantage !

Test de l’apprentissage et améliorations

Après avoir fait quelques tours de l’arène, vous pouvez activer l’autonomie. Si votre robot est bien entraîné, il se mettra alors à faire des tours par lui-même !

Mais l’apprentissage n’est pas terminé ; même lorsque le robot se pilote lui-même, vous pouvez continuer de le commander en appuyant sur les flèches pendant qu’il se déplace. Par exemple, si le robot se coince contre un mur et ne sait plus quoi faire, vous pouvez le débloquer en lui demandant de faire marche arrière (à condition que l'action "reculer" ait été activée dans l'onglet "actions" sur la gauche de l'interface du logiciel.

La course de robots

Une fois vos robots entraînés, organisez une compétition : placez les robots concurrents sur la ligne de départ. Donnez le top départ et les équipes cliquent alors en même temps sur le bouton « Autonome » (ou appuient sur la barre d’espace du clavier) pour démarrer la course.

Pendant la course, seul le mode autonome est autorisé : les participants ne doivent pas donner d’instruction à leur robot. Un arbitre pourra déplacer les robots qui sont bloqués pendant plus de 5 secondes, pour leur permettre de continuer la course.

Le premier robot qui a effectué 3 tours complets a gagné !

Retours d'expérience et conclusion

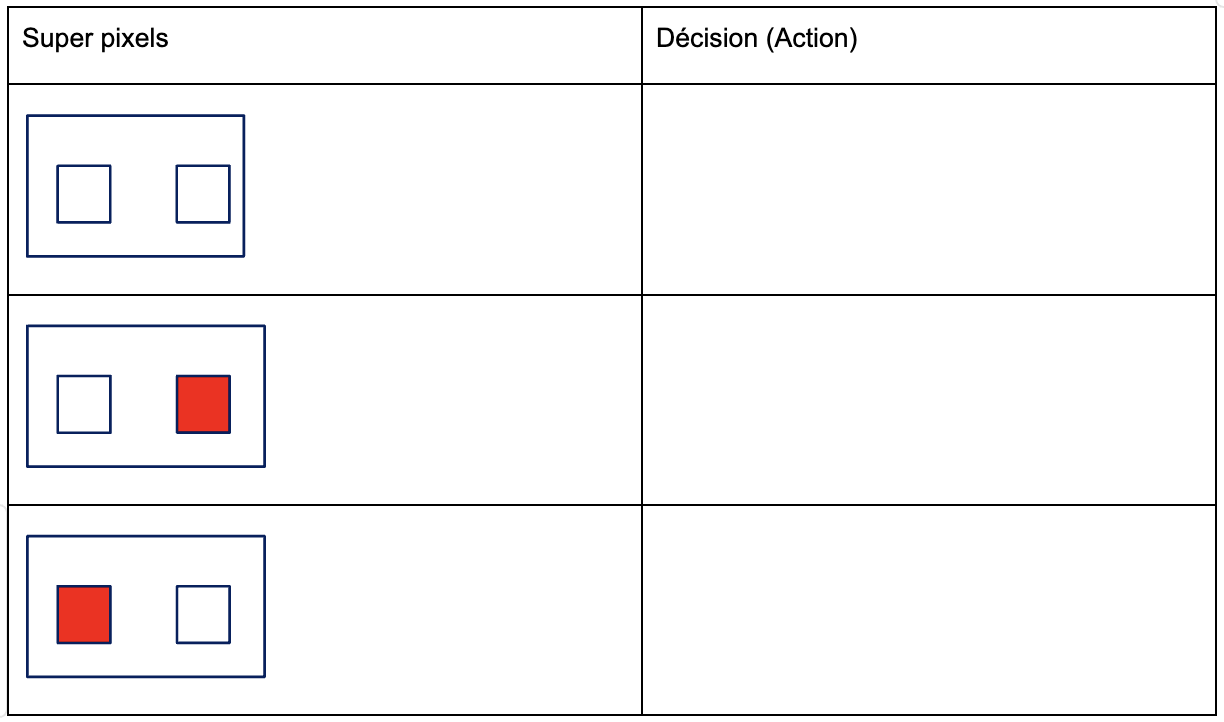

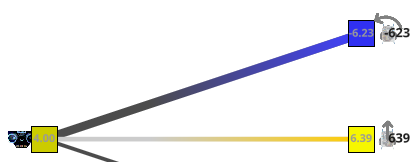

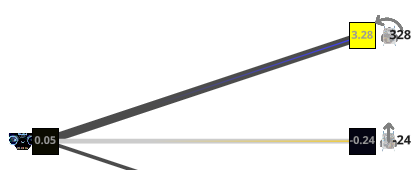

Nous avons utilisé ici un algorithme d’apprentissage supervisé. Cet algorithme est basé sur le réseau de neurones artificiels qui est affiché à l’écran (mais il existe d’autres types d’algorithmes qui ne sont pas basés sur des réseaux de neurones, par exemple l’algorithme des K plus proches voisins). Tous les algorithmes d’apprentissage supervisé fonctionnent de la manière suivante :

Dans une première phase appelée entraînement, nous avons fourni des exemples de décisions à l’algorithme, c’est-à-dire à la fois des images de ce que voit la caméra du robot et les actions qu’il faut choisir lorsque la caméra voit ces images. Pendant l’entraînement, le réseau de neurones artificiels a été modifié par l’algorithme d’apprentissage (plus spécifiquement, certaines connexions ont été renforcées, d’autres diminuées, de sorte que le réseau de neurones devienne capable d’imiter les mêmes prises de décision).

Dans un second temps appelé utilisation, l’algorithme est capable de prendre de bonnes décisions sur de nouvelles images.

Nous avons vu que tous les robots n’ont pas appris la même chose, certains se sont mieux comportés pendant la course, d’autres moins bien. Comme tous les participants ont utilisé le même algorithme, nous voyons bien que la qualité des prises de décisions en autonomie dépend de la qualité des données d’entraînement.

Nous pouvons discuter ensemble de ce qui fait la qualité des données d’entraînement :

• Qualité des données d’entraînement = absence d’erreurs dans les prises de décisions

• Quantité des données pas toujours gage de qualité d’autonomie

• Exhaustivité des situations : le robot a plus de risques de faire un mauvais choix lorsqu’il est confronté à une situation inconnue

Pour aller plus loin

Maintenant que les élèves ont compris que pour gagner la course, le plus important est la qualité des données d'entraînement, recommencer l'activité depuis le début !

Vous pouvez également recommencer la course en ajoutant de nouvelles règles :

- Limiter les données d’entraînement (par exemple : 25 points de données maximum), mais en laissant la possibilité aux participants de déplacer leur robot à la main pendant la phase d'entrainement

- Complexifier l’arène

- Avoir une arène différente pour l’entraînement et pour la course

Matériel nécessaire :

- 2 robots minimum

- 1 ordinateur/robot

- Arène de course

Durée :

40 à 60 minutes

Age :

+ 8 ans

Les + de cette activité :

- Ludique

- Appréciée de tous les âges

- Parfaite pour introduire le principe de l’apprentissage supervisé

Configuration logiciel :

Mode "course de robot"

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Surface plane de couleur claire

- Ruban adhésif noir

Paramètrage logiciel :

“Suivi de ligne” en édition manuelle (créez les connexions directement sur le logiciel) ou en apprentissage supervisé (entraînez le robot sur la piste)

Durée :

20 à 30 minutes

Age :

10 ans et +

Les + de cette activité :

- Peu de matériel nécessaire

- Très simple et rapide à réaliser

- Réseau de neurones très facile à comprendre

Cette activité est réalisée avec chaque robot individuellement. Nous allons apprendre au robot à suivre un tracé au sol, sans qu’il ne se trompe !

Les élèves apprennent que le succès de l'apprentissage supervisé dépend plus de la qualité et de l’exhaustivité des données d’entraînement du robot que de leur quantité. Ils pourront comprendre très facilement le principe du réseau de neurones artificiels, car celui utilisé dans cette activité est très simple et lisible (5 entrées, 5 ou 6 sorties).

[Contenu vidéo à venir]

Introduction

Sur une surface plane de couleur unie et claire, tracez un parcours grâce à un scotch de couleur noire (fourni avec les arènes).

Si vous souhaitez utiliser votre propre matériel, veillez à ce que le robot perçoive bien le contraste entre le sol et la ligne.

La forme classique est un “8”, mais n’hésitez pas à faire parler votre imagination !

Veillez cependant à toujours créer des courbes douces pour ne pas perturber le robot.

Paramétrage (connexion)

Connectez le robot à un ordinateur (voir section connexion au robot si besoin), puis choisissez la configuration d'exemple “suivi de ligne” en édition manuelle ou en apprentissage supervisé, ou bien créez vos propres paramètres.

Veillez à vérifier que le robot a une vitesse inférieure ou égale à 20 à l’aide du curseur au bas de vôtre écran.

Entraînement

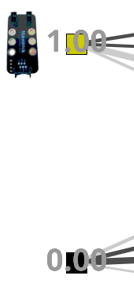

Si vous êtes en édition manuelle :

Vérifiez que les boutons « autonome » et “apprentissage” sont désactivés, et que le bouton “édition manuelle” est bien activé.

Cliquez sur les liens entre les neurones d’entrée (capteurs infrarouges) et de sortie (action du robot) pour créer une connexion. Nous vous conseillons de créer les connexions suivantes :

- Capteur IR gauche : pivoter à gauche

- Capteur IR centre gauche : tourner légèrement à gauche

- Capteur IR central : aller tout droit

- Capteur IR centre droit : tourner légèrement à droite

- Capteur IR droite : pivoter à droite

Voici alors à quoi devrait ressembler votre réseau de neurones :

Si vous êtes en apprentissage supervisé :

Vérifiez que le bouton « autonome » est bien décoché, et que le bouton “apprentissage” est bien coché.

Placez le robot sur la ligne tracée sur le sol pour activer les capteurs. A chaque fois qu’un des capteurs est activé, déclenchez l’action correspondante :

- Capteur IR gauche : pivoter à gauche

- Capteur IR centre gauche : tourner légèrement à gauche

- Capteur IR central : aller tout droit

- Capteur IR centre droit : tourner légèrement à droite

- Capteur IR droite : pivoter à droite

- Aucun capteur ne s'active : reculer

Nous vous conseillons de donner plusieurs exemples pour chaque situation.

Test de l’apprentissage

Une fois que le réseau de neurones est configuré, observons si le robot réussit à suivre la ligne !

Placez-le en début de parcours, activez l’autonomie et regardez comme il se débrouille.

Vous pouvez ensuite complexifier la piste en y ajoutant des intersections afin de créer de nouvelles difficultés pour les robots !

Bilan et retours d'expérience

Grâce à un réseau de neurones très simple et très peu de données d’entraînement, le robot a réussi à suivre la ligne.

On peut observer sur le logiciel le poids accordé à chaque connexion, et comprendre la manière dont le robot prend ses décisions : en fonction du capteur qui est activé (ou non), l’algorithme attribue des préférences à chacune des actions à choisir : le robot sélectionne l’action avec la préférence la plus forte.

Votre robot est sorti de piste ou a choisi la mauvaise action ? Essayez de comprendre pourquoi ! Quelques suggestions :

- il y a un biais : vous avez fait une erreur dans l’entraînement du robot

- plusieurs capteurs se sont activés en même temps, par exemple à un croisement : le robot a-t-il été entraîné à réagir à cette situation ?

- l’angle d’une courbe de la ligne au sol est trop abrupt

- la vitesse du robot est trop forte

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Surface plane de couleur claire

- Ruban adhésif noir

Durée :

20 à 30 minutes

Age :

10 ans et +

Paramètrage logiciel :

“Suivi de ligne” en édition manuelle (créez les connexions directement sur le logiciel) ou en apprentissage supervisé (entraînez le robot sur la piste)

Les + de cette activité :

- Peu de matériel nécessaire

- Très simple et rapide à réaliser

- Réseau de neurones très facile à comprendre

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène facultative

(recommandé si surface en hauteur)

Configuration logiciel :

- configuration d'exemple :

“navigation avec caméra”

Durée :

1 heure

Age :

8 ans et +

Les + de cette activité :

- Ludique et visuelle

- Rapide à mettre en place

- Très adaptée aux enfants les plus jeunes

Les élèves pourront apprendre au robot à suivre leur main ou un objet bien identifiable.

On pourra aller plus loin en laissant place à l'imagination des élèves : réalisation de parcours ou chorégraphies, où le robot réagit à divers signes visuels, comme par exemple des signes de la main.

[Contenu vidéo à venir]

Introduction

Placez le robot sur une table avec assez d’espace pour se déplacer. Vous pouvez utiliser une arène si vous voulez éviter que le robot tombe de la table. Dans ce cas, une petite arène sans obstacle sera suffisante.

Paramétrage

Connectez le robot à l’ordinateur, puis choisissez la configuration d'exemple “navigation avec caméra”.

Nous utiliserons le capteur caméra, et les actions suivantes : avancer, pivoter à droite, pivoter à gauche, et s’arrêter.

Veillez à adapter la vitesse à la taille de la table.

Entraînement et mise en oeuvre (phase d’apprentissage)

L'entraînement se fera à 2, en faisant attention à être bien coordonné.

Un des élèves s’occupera de faire les signes de la main au robot, pendant que l’autre va gérer le logiciel.

L’objectif est d’apprendre au robot à suivre la main de l’élève (ou un objet bien identifiable).

Dans une première phase, un des élèves place sa main dans le champ de vision caméra du robot, pendant que l’autre choisit l’action qui rapprochera le robot au plus près de la main. Donnez plusieurs exemples au robot pour chaque position de la main dans l’image.

Dans une deuxième phase, il faudra apprendre au robot à s’arrêter lorsqu’il ne voit pas de main. De nouveau, le robot a besoin de plusieurs exemples avec des points de vue différents : l’élève en charge du logiciel clique sur l’action “s’arrêter”, pendant que l’autre élève place le robot à différents endroits (en faisant attention à ne rien mettre devant la caméra évidemment !)

Test de l’apprentissage et améliorations

Activez maintenant le mode Autonome.

Vérifiez que le robot a bien appris en observant s'il suit correctement votre main.

Si ce n'est pas le cas, désactivez à nouveau le mode autonome et ré-entraînez le robot.

Des pistes pour aller plus loin

- On inverse les rôles, le robot parvient-il à suivre la main de l’autre élève ou un objet différent ? Si non : poursuivre l’entraînement jusqu’à ce que le robot soit capable de suivre les mains des deux élèves.

- Placez le robot sur un parcours (tracez par exemple 2 lignes parallèles sur le sol), le mettre en mode autonome et le guider à la main sur le parcours. Permet d’évaluer à la fois l’entraînement du robot et le guidage effectué par l’élève.

- Entraînez un robot à en suivre un autre ! Le robot de devant sera piloté, et l’autre devra le suivre en mode autonome. Astuce : pensez à choisir une vitesse un peu plus faible pour le robot suiveur.

- Visualiser les données d’apprentissage et corriger les erreurs qui s’y trouvent. Le comportement du robot s'en trouvera amélioré.

Bilan et retours d'expérience

La mission des élèves était de réaliser l’entraînement (apprentissage supervisé) d’une IA.

Après apprentissage, le robot est capable d'interagir avec un utilisateur en réagissant aux signes de sa main.

En montrant des exemples au robot, il parvient à associer correctement les bonnes actions aux signes de main correspondants ce qui permet de « communiquer » avec lui.

Notions à retenir :

- Ce sont les données d’entraînement qui déterminent le comportement du robot.

- La qualité des données (absence d’erreurs) est très importante.

- Il faut aussi fournir au robot des exemples suffisamment divers si l’on souhaite qu’il soit capable de généraliser le comportement suivi (par exemple suivre un autre objet ou une main différente).

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène facultative

(recommandé si surface en hauteur)

Durée :

1 heure

Age :

8 ans et +

Configuration logiciel :

- configuration d'exemple :

“navigation avec caméra”

Les + de cette activité :

- Ludique et visuelle

- Rapide à mettre en place

- Très adaptée aux enfants les plus jeunes

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène individuelle minimum (sans obstacle)

Configuration logiciel :

- configuration d'exemple : “KNN caméra”

Durée :

30 minutes

Age :

+ 14 ans

Les + de cette activité :

- Algorithme intuitif

- Peut être réalisée avec le simulateur

- Excellente visualisation de la prise de décision du robot

Visualisation et application de l'algorithme des K plus proches voisins (au programme de première NSI) pour apprendre au robot à éviter les obstacles.

Niveau expert : dans l’activité “Algorithme KNN avancé”, les élèves pourront reprogrammer l'algorithme par eux-mêmes et le mettre en œuvre sur le robot.

Introduction

Placez le robot dans une arène sans mur intérieur. Veillez à ce que l’arène soit bien éclairée, afin d’avoir un fort contraste entre le sol et les murs.

Paramétrage

Connectez le robot à l’ordinateur puis choisissez la configuration d'exemple “KNN caméra”.

Veillez à ce que la vitesse du robot soit inférieure ou égale à 30.

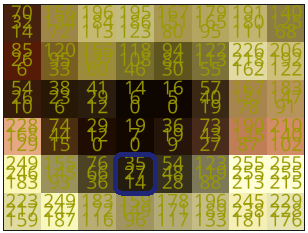

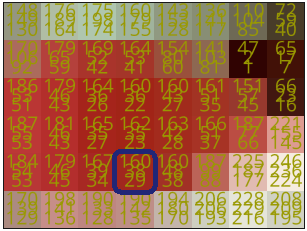

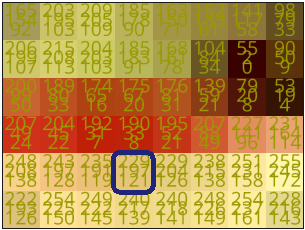

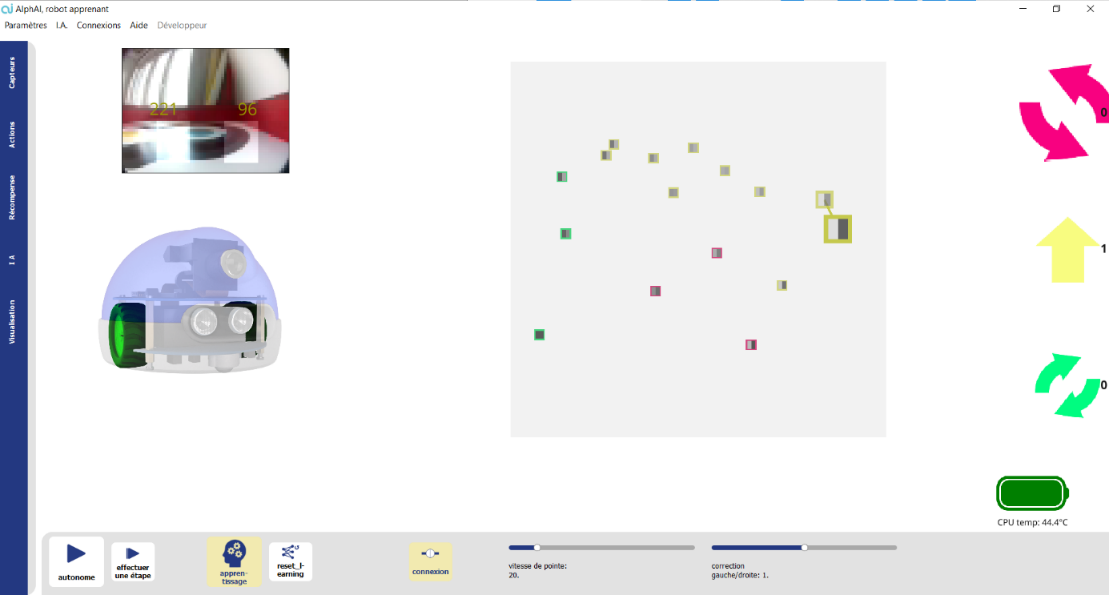

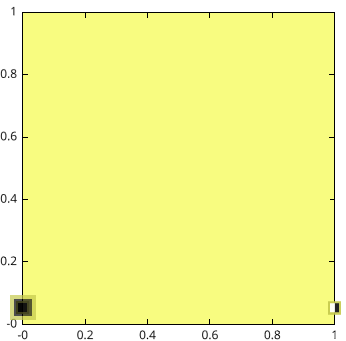

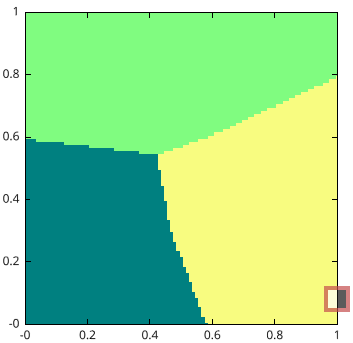

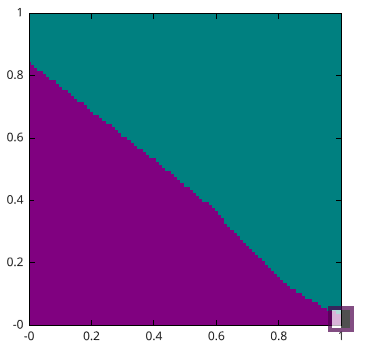

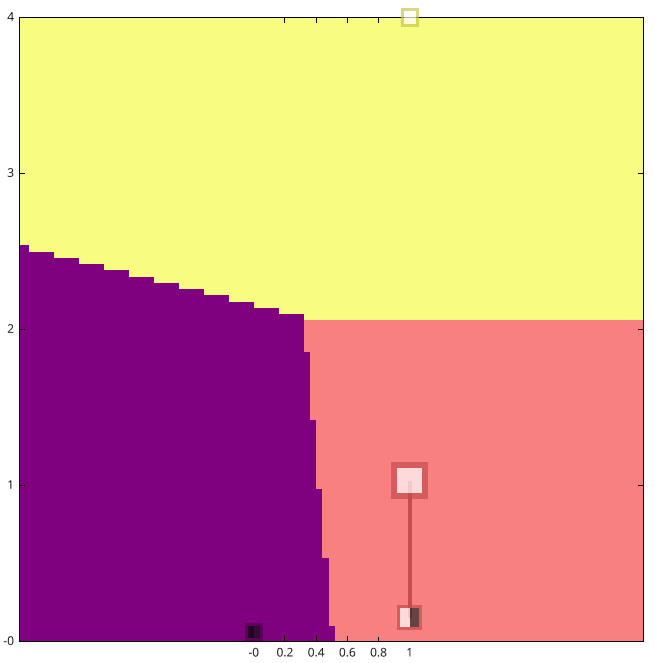

Pour cette activité, le robot analyse des images caméra dont la résolution a été réduite à 2 pixels seulement, et sans couleur. On obtient donc un pixel gauche et un pixel droit, qui mesurent des niveaux de gris. L'abscisse (pixel de gauche) et l’ordonnée (pixel de droite) du graphe montrent ces valeurs de niveaux de gris, 0 correspondant au noir et 1 correspondant au blanc.

.png)

Les actions par défaut sont : avancer (en jaune), pivoter à gauche (en rose) et pivoter à droite (en vert).

Il est possible d’ajouter davantage d’actions pour ce scénario, mais veillez à le faire dès le début, car modifier les actions provoque l’effacement de la mémoire d'expérience.

Phase d'entraînement

Vérifiez que le bouton « autonome » est bien décoché, et que le bouton “apprentissage” est bien coché.

Dirigez le robot en cliquant sur les flèches à droite de l’écran, où grâce aux touches « flèches » du clavier.

Tournez quand le robot est proche des murs et allez tout droit sinon. Vous pouvez aussi déplacer le robot à la main pour le mettre dans chaque situation.

Après chaque mouvement, un nouveau point apparaît. La position de chaque point est déterminée par ses coordonnées (x ; y), l’abscisse "x" représentant la luminosité dans la zone de gauche et l’ordonnée "y" représentant la luminosité dans la zone de droite. La couleur autour de chaque point est la couleur associée à l’action choisie (vert pour pivoter à droite, jaune pour en avant et rouge pour pivoter à gauche).

.png)

Ces points sont les données d’entraînement. Cette phase est primordiale pour que l’IA fonctionne correctement. Si les données d’entraînement contiennent trop d’erreurs ou approximations, l’IA ne permettra pas d’avoir un résultat satisfaisant.

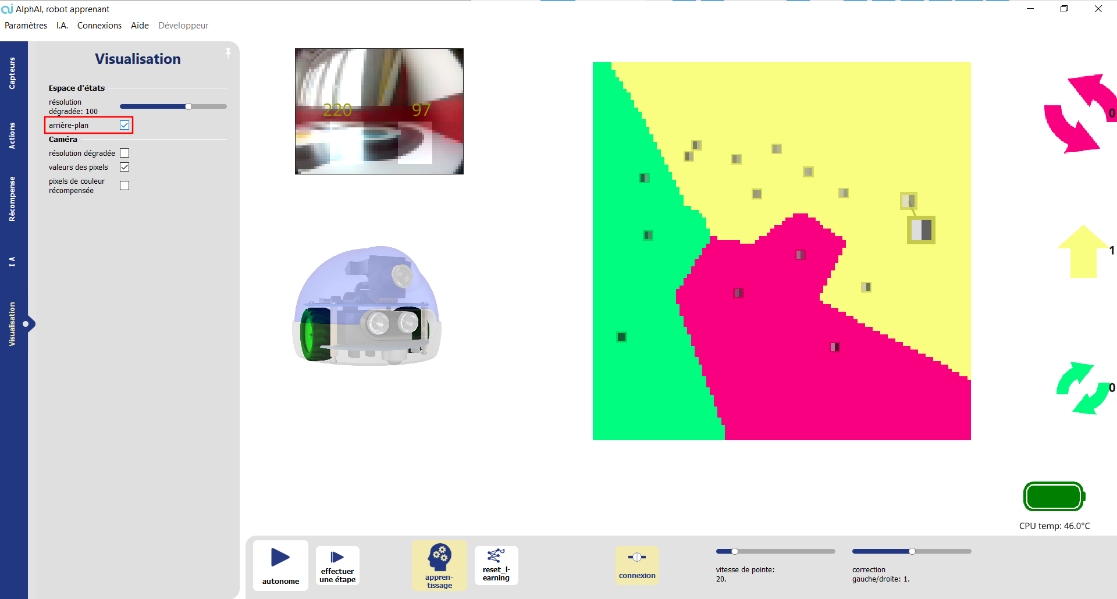

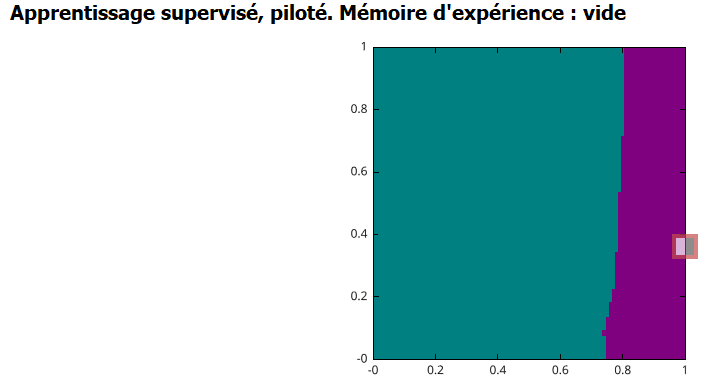

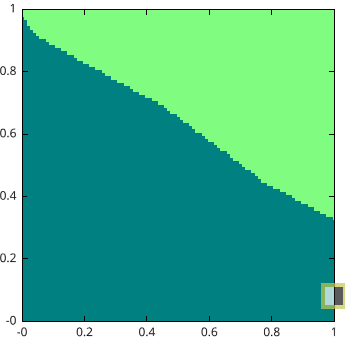

Une fois l’entraînement terminé, ouvrez le panneau Visualisation et cochez la case “arrière-plan” la section “Espace d’états”.

.png)

Vous verrez alors apparaître à l’écran les 3 différentes zones de couleurs qui correspondent à l’action que choisira le robot en fonction de la luminosité captée par sa caméra.

Si votre robot a été bien entraîné, le graphe devrait ressembler à :

.png)

La luminosité diminue lorsque le robot s’approche des murs. Normalement, si la zone de gauche est la plus sombre, il faut tourner à droite, et inversement.

Lorsque vous aurez trois régions bien claires sur le graphique, arrêtez la phase d’entraînement et activez l’autonomie pour passer à la phase de test.

Test de l’apprentissage et améliorations

Activez l’autonomie en cliquant sur le bouton correspondant à l’écran ou en appuyant sur la barre d’espace.

Comment se comporte le robot ? Évite-t-il les obstacles comme prévu ?

Si le robot est bien entraîné, il saura éviter les bords par lui-même. Si au contraire il est mal entraîné ou la luminosité dans l’arène n’est pas homogène, les zones de couleur sur le graphique auront des contours plus irréguliers et le robot fera plus d’actions inappropriées.

Comprendre la prise de décision de l’algorithme : le point le plus gros est celui capté à cet instant par la caméra : il se lie au point le plus proche dans le graphe, qui a été enregistré lors de la phase d'entraînement : c’est l’action correspondante à son plus proche voisin qu’il va choisir d’effectuer !

Pistes pour aller plus loin

- Dans l’onglet IA, faire varier la valeur de k (le nombre de voisins). Observer l’effet sur la prise de décision et sur la coloration d’arrière-plan du graphe. Quelle valeur de k donne le meilleur comportement ? Pourquoi ?

- Après avoir bien compris le principe de l’apprentissage, refaire un apprentissage avec un plus petit nombre de points (par exemple: défi 5 points d’entraînement seulement).

Bilan et retours d'expérience

Points abordés / Notions à retenir :

- Le principe de l’algorithme des k plus proches voisins : comprendre et savoir expliquer comment sont prises les décisions du robot.

- Quel est l’impact des données d'entraînement sur le résultat ? Comment bien choisir les données d’entraînement ?

- Quel est l’impact du paramètre k ? Comment choisir la meilleure valeur pour ce paramètre ?

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène individuelle minimum (sans obstacle)

Durée :

30 minutes

Age :

+ 14 ans

Configuration logiciel :

- configuration d'exemple : “KNN caméra”

Les + de cette activité :

- Algorithme intuitif

- Peut être réalisée avec le simulateur

- Excellente visualisation de la prise de décision du robot

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- un objet plat (boîte, planche, smartphone…)

Configuration logiciel :

- configuration d'exemple : “détection d’intrus”

Durée :

2 heures

Age :

15 ans et +

Les + de cette activité :

- Idéal à faire en classe

- Peu de matériel nécessaire

- Pluridisciplinaire (maths / informatique)

Compréhension mathématique des réseaux de neurones à travers une activité basée sur le capteur à ultrasons du robot. On y découvre notamment pourquoi on a besoin de couches de neurones intermédiaires.

[Contenu vidéo à venir]

Mise en place

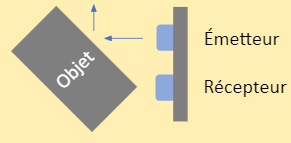

Placez le robot à côté de l’ordinateur, face à un mur (ou une planche d’arène) à environ 50 cm, et munissez-vous d’un objet à côté plat (une boîte, une planche, un smartphone) qui jouera le rôle de l’intrus.

Chargez la configuration "Détection d’intrus" dans la catégorie "Apprentissage supervisé". Ce scénario utilise uniquement le capteur à ultrasons.

Toute l’activité est réalisée en mode "édition manuelle", c'est-à-dire que l’on va choisir soi-même les paramètres du réseau de neurones sans faire appel à un algorithme d’apprentissage.

Présentation de l’interface

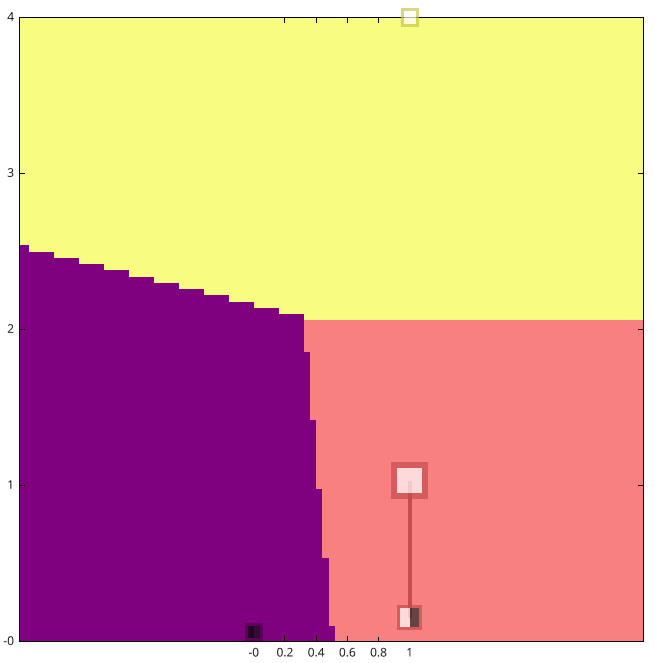

Dans cette activité, votre écran principal comporte deux visualisations :

- En bas, le réseau de neurones étudié. Au début de l'activité, le mode édition manuelle (dans les boutons en bas de votre interface du logiciel) doit être activé, ce qui permet de modifier soi-même les paramètres du réseau de neurones. Pour modifier la valeur d'une connexion, placez votre souris sur cette connexion (elle devient rouge), puis utilisez votre clavier pour entrer la valeur souhaitée ou la molette de votre souris pour modifier la valeur actuelle. Pour modifier la valeur du biais d'un neurone, placez votre souris sur le neurone lui-même (pas l'affichage de la valeur), puis procédez comme pour les connexions.

- En haut, un graphique représentant l'espace d'états. En abscisse, la distance mesurée par le capteur à ultrasons. En ordonnée, les niveaux d'activation des neurones de sortie. Il y a deux courbes représentées car il y a deux neurones de sortie. La correspondance courbe/neurone est indiquée par un code couleur. La valeur des neurones de sortie est une fonction de la valeur d'entrée (la distance). La couleur de fond du graphique indique quelle courbe est au-dessus de l'autre pour chaque valeur d'entrée, et donc quelle action sera choisie par le robot pour cette valeur d'entrée.

Objectif et problématique

Le robot est face à un mur et doit biper lorsque quelqu’un (un intrus) passe entre lui et le mur.

Il faut configurer le réseau de neurones pour accomplir cette tâche. Puisque le seul capteur utilisé est le capteur à ultrasons, l’objectif est d’obtenir un bip lorsque la distance est faible, et l’action "ne rien faire", lorsque la distance est normale.

Intégration de biais neuronaux

Les simples paramètres "poids des connexions" sont insuffisants pour accomplir cette tâche. Il faut activer l’option "biais neuronal" (dans l’onglet IA), cela débloque de nouveaux paramètres qui vont nous permettre d’atteindre cet objectif.

Tentative de triche

Problématique

Un intrus tente de tricher en exploitant les caractéristiques du capteur à ultrasons : si le côté plat est placé en diagonale par rapport au capteur, les ondes rebondissent et la distance captée est alors bien supérieure à celle du mur ! Il faut adapter notre réseau de neurones pour détecter également cette tentative de triche.

Couches de neurones intermédiaires

Pour cela, nous aurons besoin d’ajouter une couche intermédiaire à notre réseau de neurones (dans l'onglet IA), afin d’obtenir un modèle non-linéaire grâce aux fonctions d’activation.

Bilan et retours d'expérience

Je retiens :

- Un réseau de neurones est un ensemble de neurones organisé par couches. Chaque couche peut comporter un ou plusieurs neurones.

- Les neurones sont des objets abstraits contenant une simple valeur numérique.

- Les neurones sont reliés entre eux par des connexions dont les valeurs sont appelées poids.

- Chaque neurone possède également un biais qui est ajouté à la valeur du neurone.

- Les valeurs de neurones de la couche d’entrée sont déterminées par les valeurs des capteurs.

- Les neurones de la couche de sortie correspondent aux actions du robot. En mode autonome, c’est toujours l’action avec la valeur la plus élevée qui est sélectionnée.

- Les couches intermédiaires permettent au réseau d’accomplir des tâches plus complexes. On voit sur le graphique que les droites des neurones de sortie sont remplacées par des courbes de plus en plus complexes lorsqu’on augmente le nombre de couches intermédiaires.

- Entraîner un réseau de neurones consiste simplement à choisir une valeur pour chacun de ses paramètres : poids des connexions et biais des neurones. Lorsque le nombre de neurones et de connexions devient important, cette tâche complexe est réalisée par un algorithme d’apprentissage !

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- un objet plat (boîte, planche, smartphone…)

Durée :

2 heures

Age :

15 ans et +

Configuration logiciel :

- configuration d'exemple : “détection d’intrus”

Les + de cette activité :

- Idéal à faire en classe

- Peu de matériel nécessaire

- Pluridisciplinaire (maths / informatique)

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène individuelle minimum

Configuration logiciel :

- configuration d'exemple : “Apprentissage par renforcement - évitement d’obstacles”

Durée :

30 minutes

Age :

8 ans et +

Les + de cette activité :

- Introduire l’apprentissage par renforcement

- Comprendre le principe du “Try and learn” = bénéfices pédagogiques

- Peut être réalisée avec le simulateur

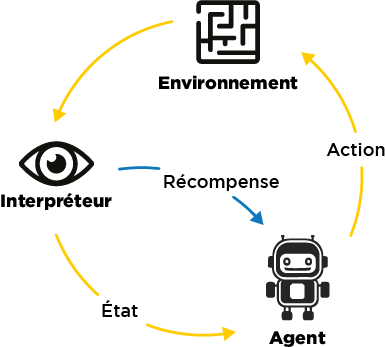

Cette activité consiste à observer un robot qui apprend de manière autonome selon le principe de l’apprentissage par renforcement. On peut en tirer des conclusions assez générales sur les conditions nécessaires pour un apprentissage efficace.

[Contenu vidéo à venir]

Introduction

Dans cette activité, on n’entraîne pas le robot : c’est le robot lui-même qui va créer les exemples sur lesquels se baser afin de prendre les bonnes décisions d’actions à effectuer.

Pour que le robot soit capable de distinguer les bonnes des mauvaises décisions, l’algorithme comporte un système de récompenses.

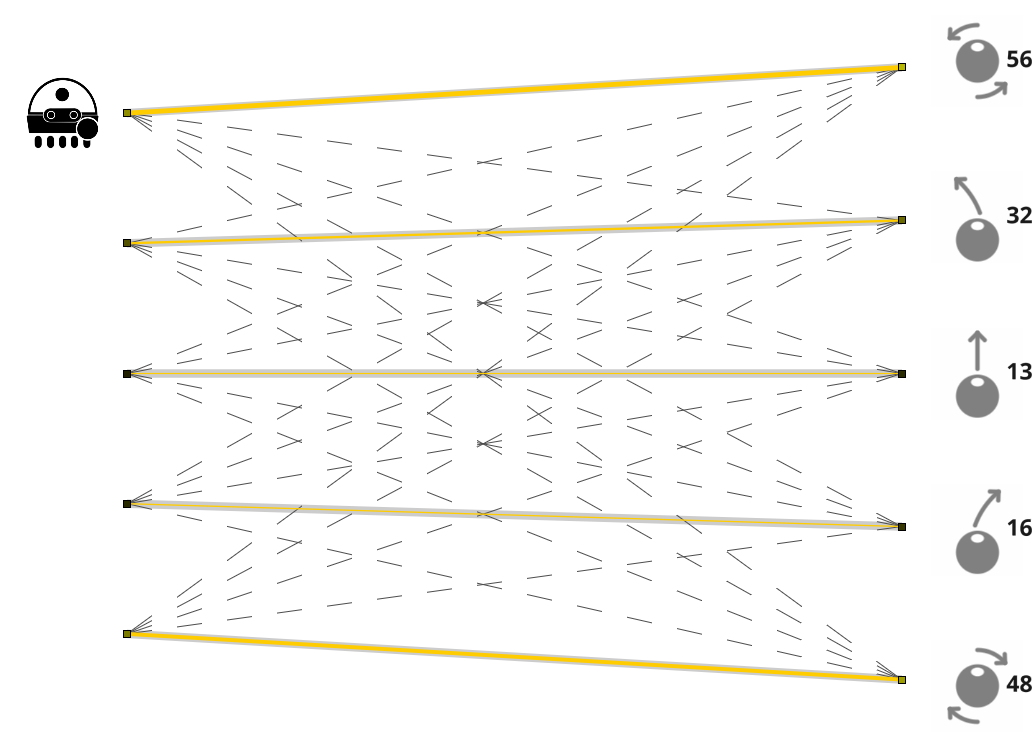

Ici, le robot reçoit en fonction des actions effectuées les récompenses suivantes :

- avancer : 100 points

- tourner : 82 points

- reculer : -50 points

- Le robot reçoit également une pénalité de -50 points lorsqu’il se bloque

Dans la barre “Niveau”, vous pourrez observer la note moyenne de récompenses obtenues par le robot. Son but est de maximiser ce score ; il va donc peu à peu apprendre à choisir les actions qui lui apporteront les récompenses optimales, en prenant en compte ce que ses capteurs lui indiquent

Nous allons donc pouvoir observer les progrès du robot au cours de son apprentissage. Commencez par monter une arène sans obstacle, et placez-y le robot.

Apprentissage du robot en autonomie

Dans le logiciel AlphAI, choisissez la configuration d'exemple : “Apprentissage par renforcement - évitement d’obstacles”.

Dans cette activité, c’est le robot qui apprend tout seul !

Lancez le mode autonome, et observez votre robot. Comment se comporte-t-il ?

Quand le robot a identifié une action qui lui rapporte une récompense (par exemple tourner), il se peut qu’il décide dorénavant d’effectuer uniquement cette action.

Nous allons maintenant activer le bouton “exploration” : de temps en temps, le robot va alors décider d’effectuer une action aléatoire. Il pourra ainsi découvrir que l’action qu’il aurait choisie n’est peut-être pas celle qui correspond à la récompense optimale possible, et ainsi enrichir son apprentissage avec de nouvelles données.

Normalement il apprend successivement à aller tout droit, à se retourner quand il se cogne à un obstacle, puis à reconnaître ces obstacles à l’avance et donc à tourner avant de se cogner dedans ! Cet apprentissage prend à peu près 10 minutes.

N’hésitez pas à désactiver le mode “exploration” lorsque le robot commence à majoritairement choisir les bonnes actions à effectuer.

Bilan et retours d'expérience

Une fois l’apprentissage terminé, arrêtez votre robot et cliquez sur “graphes” dans la barre inférieure (si le bouton n’apparaît pas, changez l’affichage des paramètres en “avancé” ou “expert”). Vous pourrez alors observer dans le graphe du bas l’évolution des erreurs effectuées par le robot : normalement, les valeurs devraient être très hautes en début d’activité, puis peu à peu tendre vers zéro : le robot s’est entraîné tout seul à ne plus faire d’erreurs !

Le fonctionnement de l’apprentissage par renforcement peut être résumé de cette manière :

Ce qui est nécessaire à l’apprentissage du robot :

- La répétition d’une même tâche : le robot ne parvient pas tout de suite à trouver la bonne solution, ce n’est qu’à force de répétitions qu’il s’améliore.

- L’exploration : le robot doit parfois tester de nouvelles idées, pour ne pas rester enfermé dans une solution non optimale.

- Les récompenses ou pénalités : le robot a besoin d’une aide extérieure pour évaluer si ses décisions sont optimales ou non.

- La place de l’erreur : le robot apprend de ses erreurs sans se décourager ! Les erreurs lui permettent d’apprendre quelles actions ne pas répéter !

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène individuelle minimum

Durée :

30 minutes

Age :

8 ans et +

Configuration logiciel :

- configuration d'exemple : “Apprentissage par renforcement - évitement d’obstacles”

Les + de cette activité :

- Introduire l’apprentissage par renforcement

- Comprendre le principe du “Try and learn” = bénéfices pédagogiques

- Peut être réalisée avec le simulateur

Matériel nécessaire :

- 1 robot minimum

- 1 ordinateur/robot

- Arène individuelle

Configuration logiciel :

- configuration d'exemple : “Bloqué VS Mouvement” en mode édition manuelle, puis en mode “apprentissage par renforcement”

Durée :

90 minutes

Age :

15 ans et +

Les + de cette activité :

- Comprendre l’algorithme Q-learning

- Pluridisciplinaire (maths/informatique)

- Peut être réalisée avec le simulateur

L’objectif de cette activité est de comprendre le fonctionnement de l’algorithme du Q-learning.