Discover our

resources

Here you will find all the pedagogical content developed by our Artificial Intelligence experts to guide you in your learning of artificial intelligence concepts using the AlphAI solution.

- If you have not yet downloaded the AlphAI software, please go to the following page download to take advantage of our 60-day free trial.

- If you're just discovering our solution, we invite you to learn a little more about it by visiting the page AlphAI Solution.

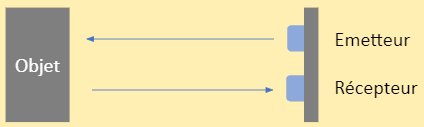

The software is designed to operate without an Internet connection (except for license activation and updates).

It does, however, require a wifi connection (recommended) or Bluetooth to communicate with the robot.

If you haven't purchased a license yet, you can take advantage of a 60-day trial version!

Windows installation

Please note: the video was made on our old website, but the principle remains the same.

- Download the software

- Launch the installation program

- Follow the instructions, then launch the software!

This screen appears once the software has been downloaded:

.png)

System requirements:

- Windows 8.1 minimum

- 4 GB RAM

- 2 GB hard disk space

- OpenGL version ≥ 2.1

- Internet access (during installation only for license retrieval)

* Windows 7 is not supported by Python 3.9, so our software cannot be installed on it. Please contact us for installation assistance.

Mac installation

Go to the download and follow the instructions.

System requirements:

- Mac OS

- 4 GB RAM

- 2 GB hard disk space

- OpenGL version ≥ 2.1

- Internet access (during installation only for license retrieval)

In case of difficulty, please refer to the FAQ page.

Linux installation

- AlphAI is compiled to work with python 3.9 (ideally python 3.9.13). If you have a python 3.9 environment, you can use this one. If not, you can download python 3.9.13 from

https://www.python.org/downloads/release/python-3913/.

In the following instructions, the python3 command refers to this python 3.9 environment. - Download a version of AlphAI software: Download the installation script.

- Unzip the downloaded folder to the location where you want to install AlphAI.

- Open a terminal and navigate to the newly created folder, for example using the command: cd AlphAI-1.8.10.11.

- In the terminal, run the command: python3 -m pip install -r requirements-mac.txt. This should install all the python libraries needed to run the software.

- Finally, to launch the software, enter the command: sudo python3 Start_Alphai.pyc, then enter your user password. Please note that python3 must be replaced by an explicit path to the python interpreter, e.g. ./python3 or ~/Documents/AlphAI/alphaienv/bin/python3, otherwise the default interpreter will be launched.

System requirements:

- Ubuntu 18

- 4 GB RAM

- 2 GB hard disk space

- OpenGL version ≥ 2.1

- Internet access (during installation only for license retrieval)

In case of difficulty, please refer to the FAQ page.

When you launch the software for the first time, the license activation window will appear.

.png)

Make sure you have an Internet connection, and choose one of the following options:

Check the Trial version box

Inthis case, you can use the software free of charge on this computer for a period of 60 days. Please note: this option can only be activated once per computer!

.png)

Use an activation key

This will allow you to use the software for an unlimited period of time. To do this, enter your activation key in the field provided and select a validity period. At the end of the validity period, you'll need to reactivate your license. To make sure you don't lose it, you can save your activation key on your computer.

⚠️ Warning: this makes it possible to reactivate the license on this computer with a single click, so don't save your activation key on a computer that doesn't belong to you!

.png)

Reactivate your license with a registered key, by checking the Use registered key box. You will also need to select the duration of the new validity period.

.png)

The following window asks you to provide us with some information:

.png)

This step is not compulsory, but we kindly ask you to fill in the various fields. This information will enable us to provide you with assistance if necessary, and to inform you of any software updates.

About the validity period :

- The validity period is the time during which you can use our software without an Internet connection.

- When this period expires, you will be asked to reactivate your license, a step that requires an Internet connection.

- Each activation key is issued with a limit on the number of simultaneous activations allowed (usually 2 computers or 30 computers).

- If the software is to be used in a classroom, it is advisable to choose an activation period that corresponds to the period of intended use, e.g. until the end of the school year. This way, when the licenses expire, it will be possible to use the software in another room.

Example: Suppose my activation key has a limit of 2 computers. On January 1, I use this key to activate a license on computer A for 6 months (i.e. until June 30). Then, on February 1, I use the same key to activate a license on computer B for 3 months (i.e. until April 30). From February 1 to April 30, the maximum number of activations has been reached, so I can't use my activation key on a third computer. On the other hand, from May 1st, the license on computer B has expired, so I can activate a license on computer C for a period of my choice. Similarly, from July 1, the license on computer A is no longer valid, making it possible to activate on another computer (or renew the license on computer A).

Duration

Activation keys sold by Learning Robots are perpetual.

Device limits

Depending on the product you choose, your license is valid for 2 or 30 devices.

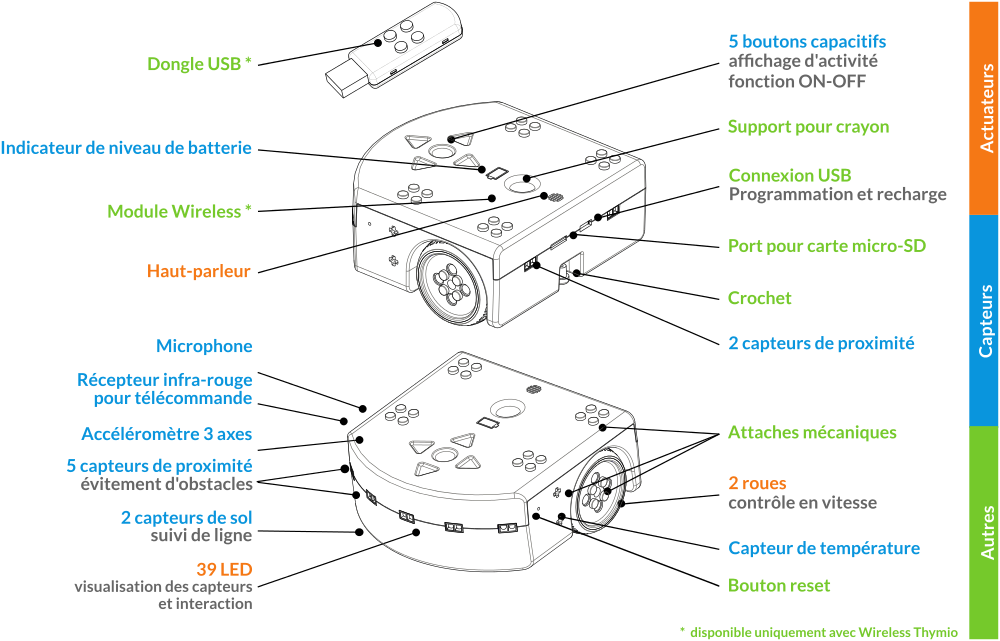

Thymio features

Licenses for Thymio robots have a few differences from other types of license. The first difference is that the license activation window will not appear when the software is launched, but only when you first connect to a Thymio robot.

If this robot is a simulation, then everything happens as described above.

.png)

If this robot is a real Thymio, then the license will be stored on the robot itself and not on your computer. This will then allow you to connect this robot to any computer where the software is installed, even if it doesn't have an active license. However, you will only be able to use your activation key in this way on a single Thymio robot. If you want to use AlphAI with several Thymio robots, you'll need to purchase a license for each robot.

The validity period for real Thymio robots is unlimited.

To connect your Thymio to your computer, please refer to the resource sheet Thymio.

Launch the software by clicking on the desktop shortcut (PC) or by running the "alphai" command in the terminal and entering your computer password (Mac).

When you launch the software, if you're connected to the Internet, it may detect that an update is required. It launches automatically, and takes just a few minutes!

You will then be taken to the login screen.

.png)

Robot selection

In the top right-hand corner of the home screen, you can choose the robot model you'd like to work with. Depending on the license you've purchased, you can choose between :

- the AlphAI robot

- the Thymio robot

- the mBot robot

- the Buddy robot

- Spike robot (LEGO)

- computer (robot-free activities)

.png)

Connection modes

Depending on the robot you choose, you can choose between several connection modes: WiFi, Bluetooth (with a dongle or the computer's Bluetooth), or a simulated robot.

.png)

For the AlphAI robot, we recommend that you always choose a WiFi connection if possible. If you choose a Bluetooth connection, you'll find a button in the top right-hand corner of your screen that allows you to deactivate the "Bluetooth Low Energy" mode if your robot is an older model.

Simulation

AlphAI and Thymio robots can be used for a wide range of simulation activities. To understand how to use the simulation mode, please refer to the corresponding pages:

Resources - AlphAI - Robot connection

Resources - Thymio - Connecting to the robot

Instructions and help

Depending on the robot you've chosen, buttons at the bottom of the screen provide you with instructions and information for connecting to the robot and in case of bugs. our FAQ page.

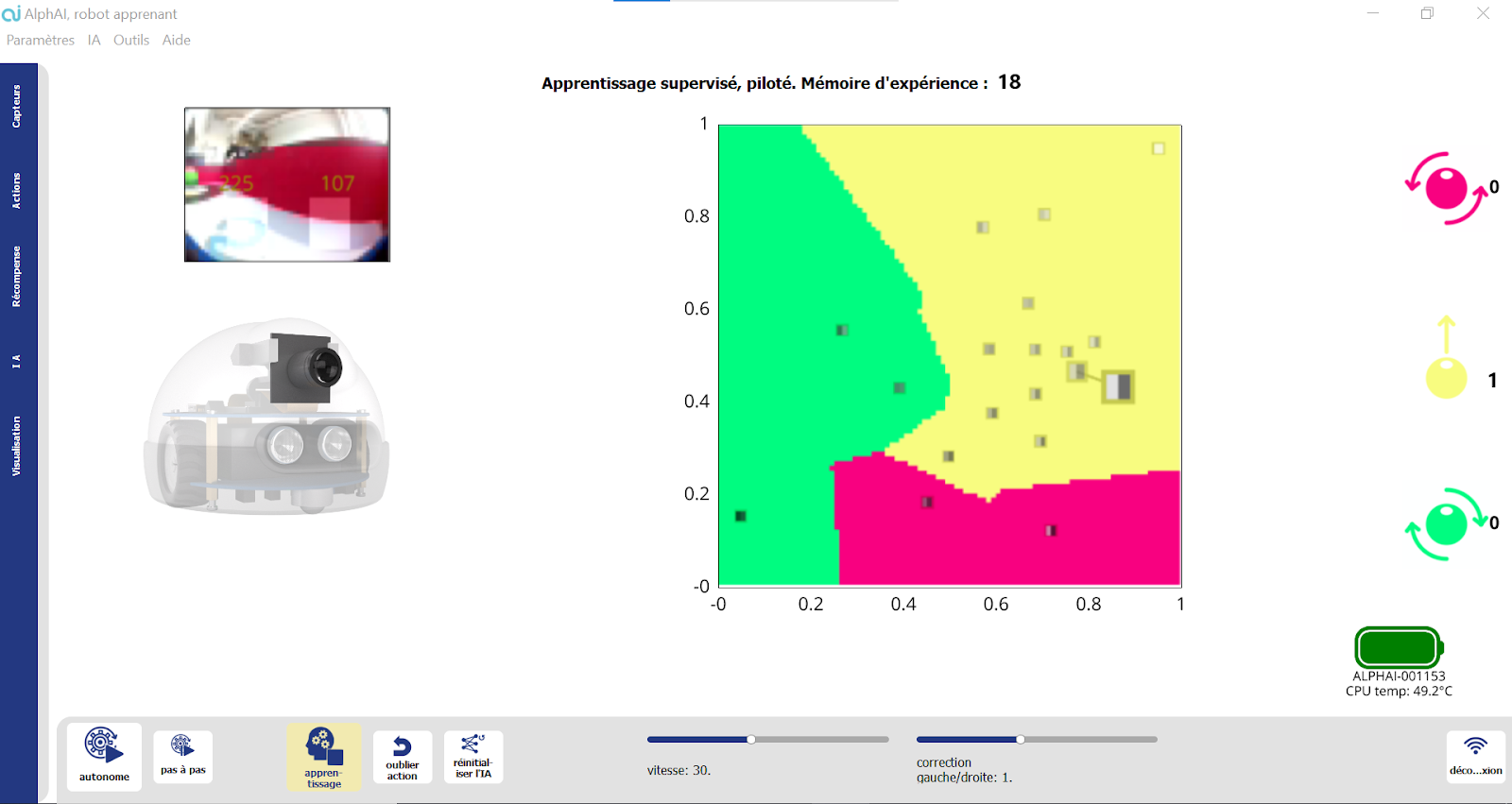

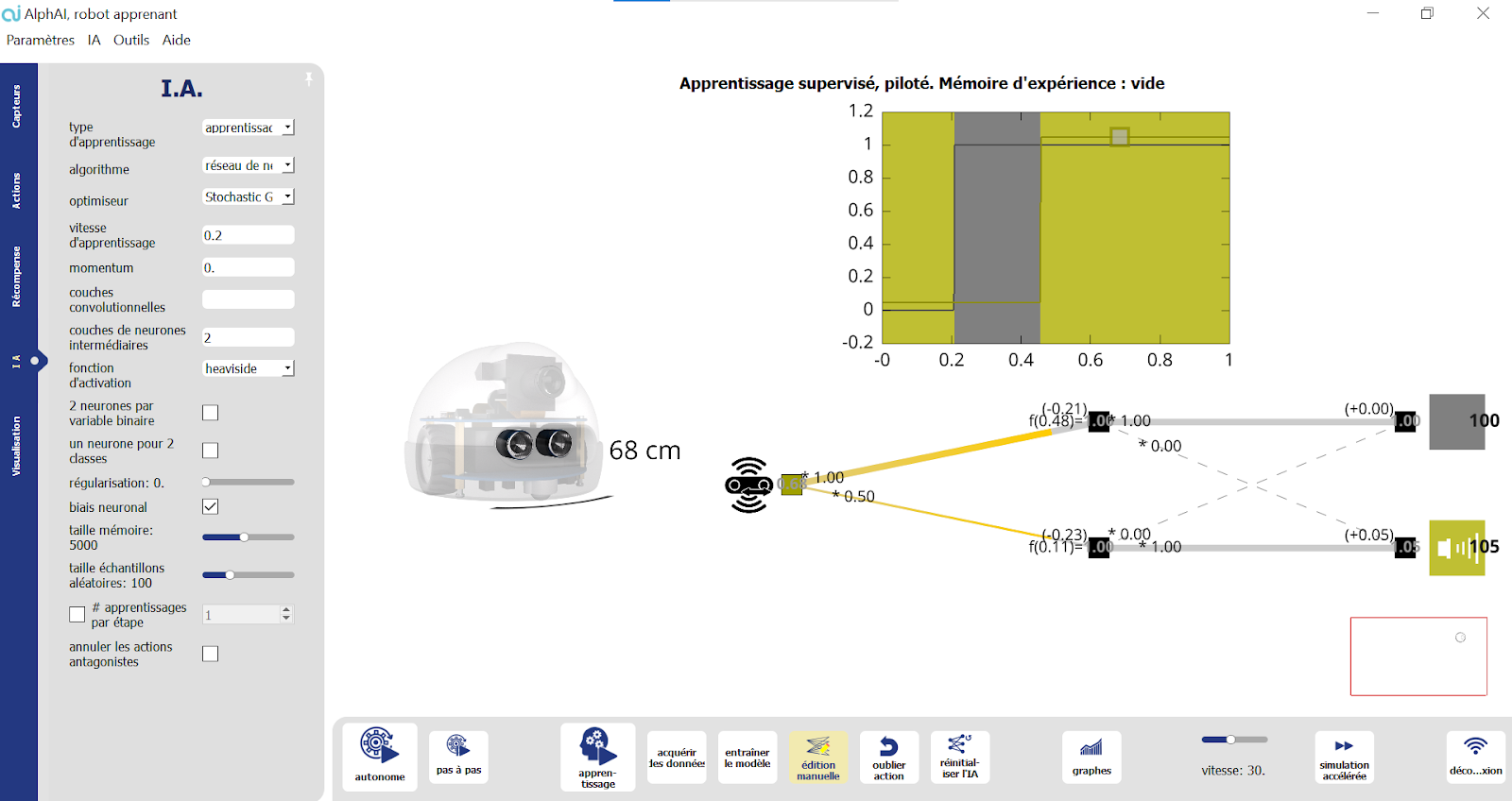

You are now connected to your robot and have reached the main screen. On this page, we present each of the elements you can see on the screen:

.png)

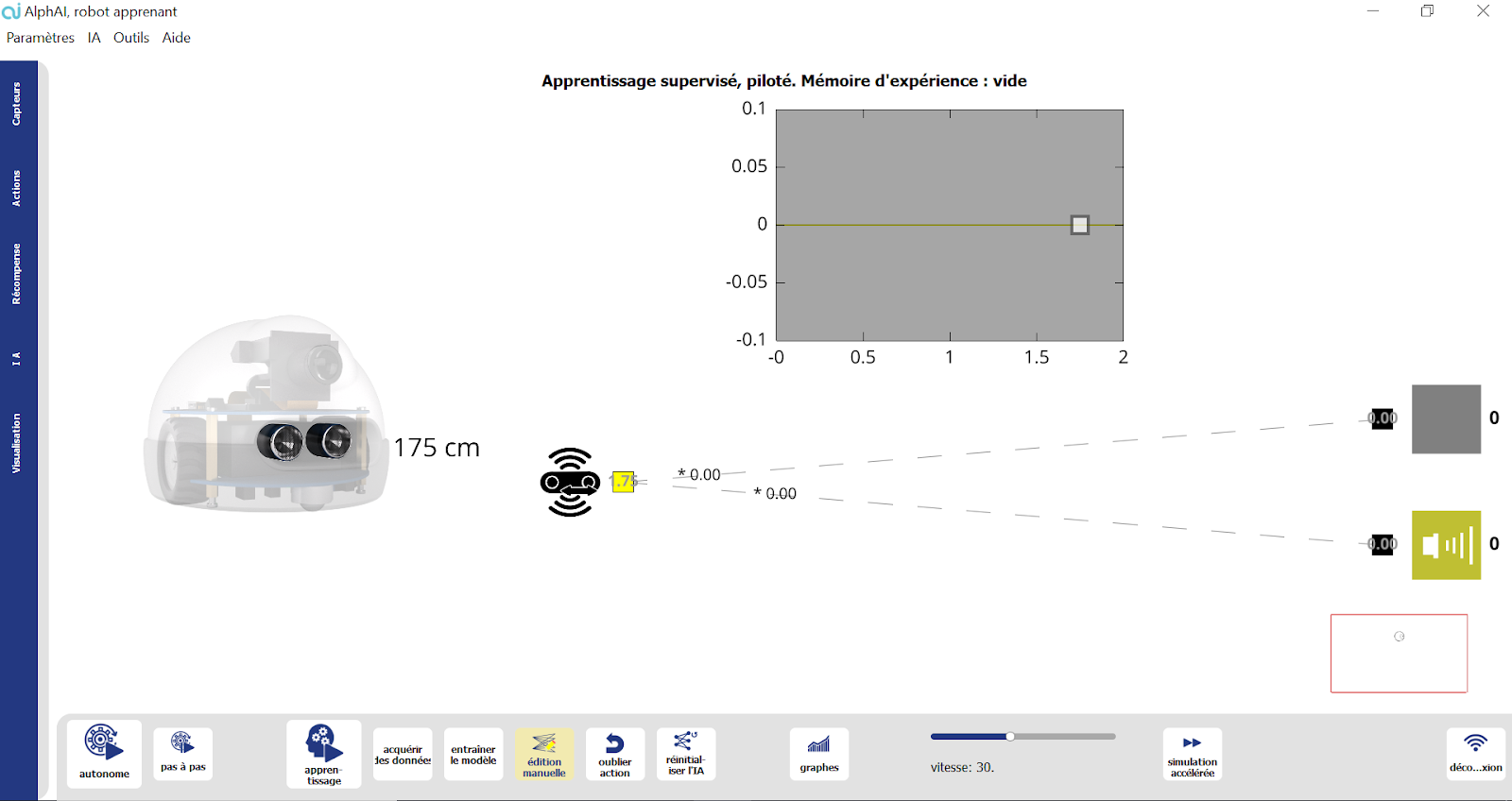

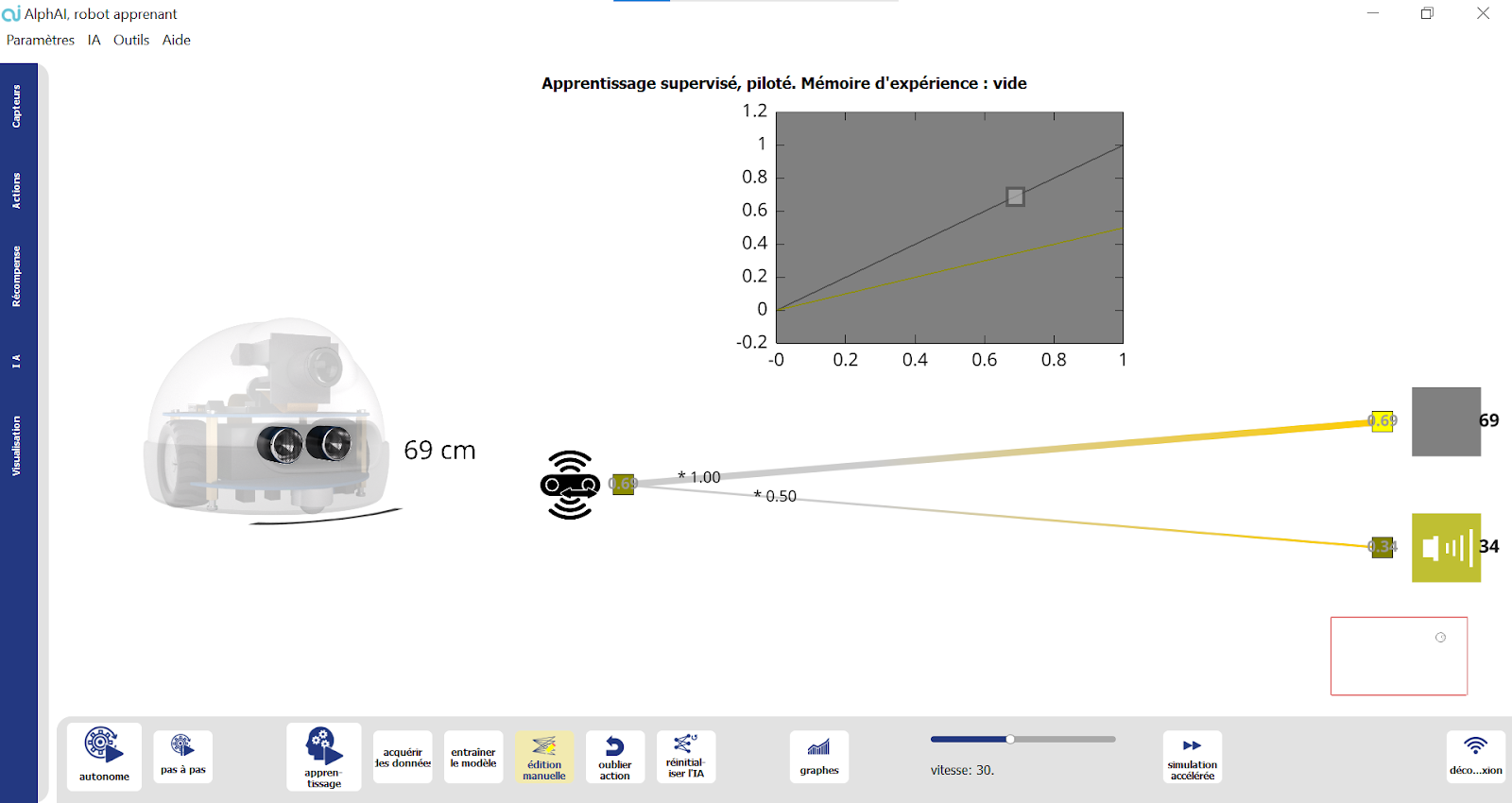

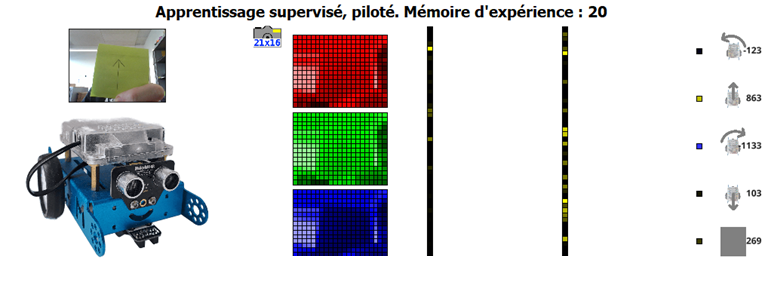

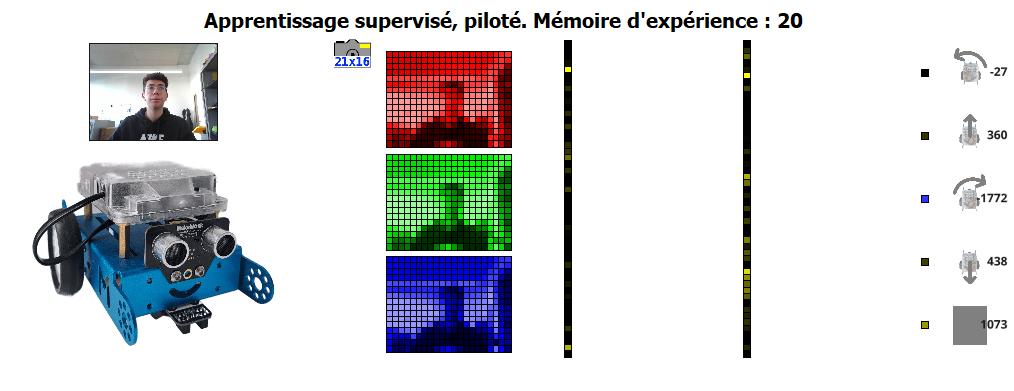

The title

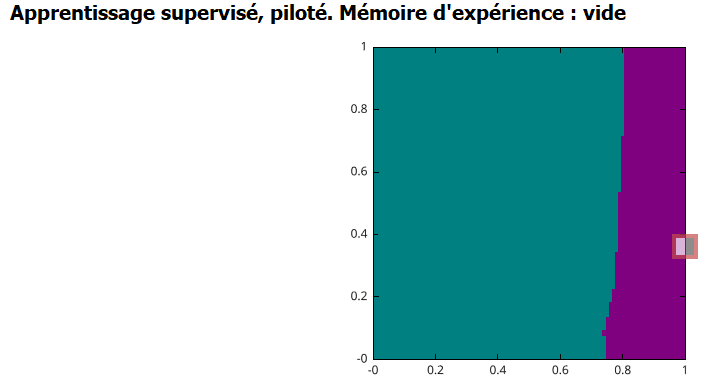

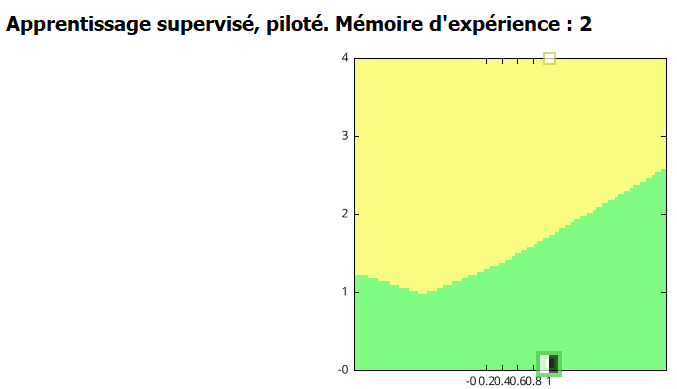

At the top of your screen, a title informs you about the characteristics of the currently selected settings: the learning mode (supervised, reinforcement, or no learning), the control mode (piloted/autonomous), and the number of data recorded in the experience memory during learning.

.png)

The robot

On the left of your screen, you can see an image of the robot you are currently using.

For the AlphAI robot, the sensors used in the activity appear in black.

The color of the wheels indicates whether they are blocked (red) or not (green).

You can also see the color of the shell.

.png)

Central display

The entire right-hand side of your screen is taken up by the central display. It can contain :

A neural network

On the far left, the input neurons: these are the robot sensors used.

In the middle, the connections and intermediate layers of neurons.

On the far right, output neurons and corresponding action icons: these are the actions the robot can perform.

.png)

You can fully parameterize the neural network (AI tab) and modify its visualization (Visualization tab).

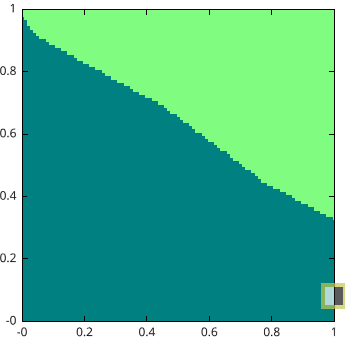

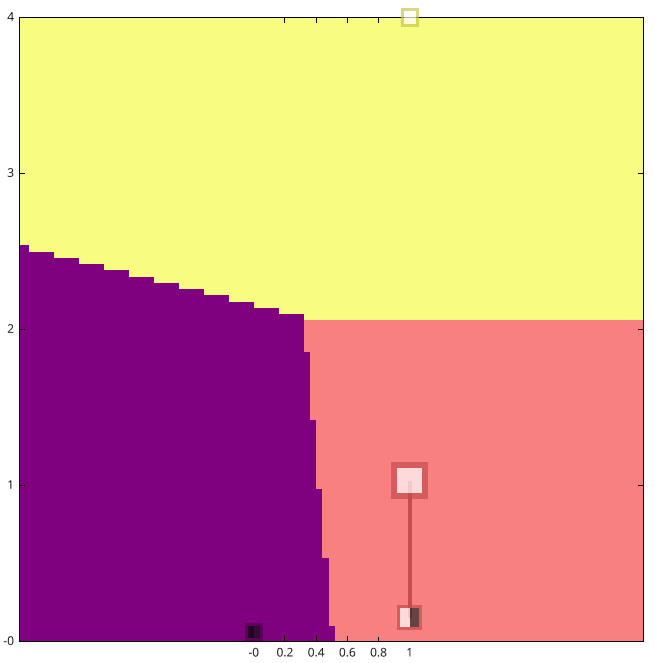

A visualization of the state space

For example, if the chosen algorithm is K-nearest neighbors, the neural network will be replaced by a graph. See the KNN ACTIVITY.

.png)

Visualization of learning data

Once you have provided the robot with example data, you can also display each piece of recorded data on screen: the information provided by the sensors and the associated action. You can correct a bias by deleting a piece of data, modifying an action, etc.

A combination of these elements

For example, in the Intruder detection activity, you can see the state space and the neural network

.png)

Video screen

If the camera sensor is required for the chosen activity, you'll see a return of the robot's camera in the top left-hand corner of your screen (even for a simulated robot!). If the activity uses the computer's webcam, this is where it will appear.

.png)

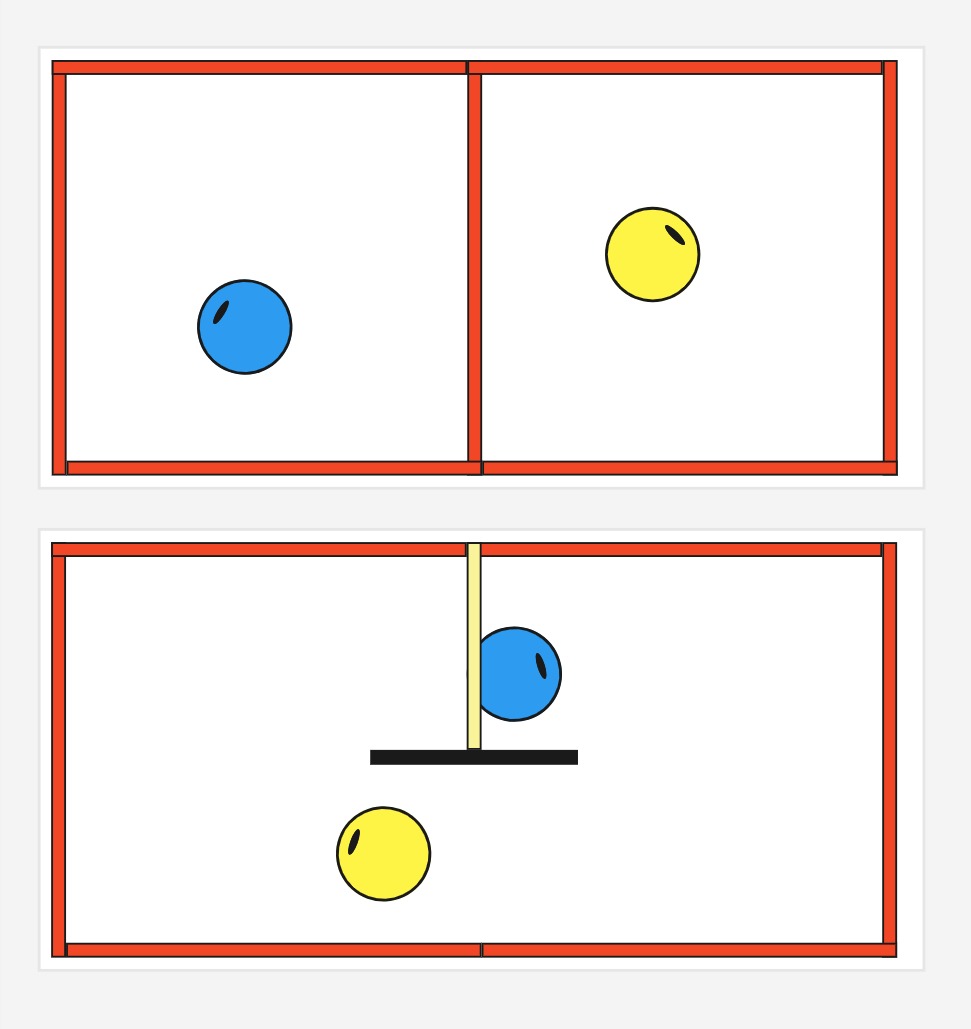

2D simulation (for the AlphAI robot)

If you have chosen the AlphAI simulated robot for your activity, a 2D arena will appear at the bottom left of your screen, with the simulated robot moving around it live.

If you wish to modify this simulated arena, open the Sensors tab and scroll down: you can then add/remove the central island and choose the color of the interior and exterior walls.

.png)

Battery level

If you're connected to an AlphAI robot, at the bottom left of your screen you'll see a battery level indicator. There are 2 states:

- either the battery icon is green, in which case there's nothing to report

- either the battery icon is red or black, in which case we advise you to disconnect the robot from the software and change the batteries immediately

Changing batteries on an AlphAI robot

Awards and levels

If you've chosen an activity with reinforcement learning, 2 bars will appear at the bottom of your screen: reward (the rewards given to the robot according to the actions performed: red if negative, green if positive) and level (average of rewards received).

.png)

Once you've entered the software's main interface, the menu is located at the top left of your screen, as shown below:

Files

Example configurations

choosean example configuration from all those designed by Learning Robots! You'll find detailed instructions for each activity on the resource pages for the robot you're using:

AlphAI activities

.png)

Thymio activities

.png)

mBot activities

.png)

Open

- Allows you to load training data that has been saved on the computer (.zip or .npz format - take care to load data that corresponds to the current configuration)

Save

- Save configuration: saves the current configuration on the computer (.json format)

- Save configuration and training data: allows you to save the current configuration as well as the data from the training session you've just completed (.zip format, including configuration in .json format).

- Save complete project: saves current configuration, training data and AI model (.zip format)

Language

- Choosethe language in which you wish to use the software

Parameter display

Choosethe parameter display level between standard (more streamlined), advanced and expert (all options) modes.

We advise you to choose standard mode, unless you are familiar with AlphAI and have a good knowledge of AI.

Keyboard shortcuts

Enables/disables all or some of the software's keyboard shortcuts.

Activate teacher mode

- Ifyou're a teacher, activating this mode will give you access to new features. To access it, you'll need your activation key.

For example, in the help menu, you can click on "License information" to see the list of devices on which the license has been activated.

Other program parameters...

- Font size: change the font size on the software if you wish to have a better view, for example, of neural network connection weights.

- Big Brother: This option is used in particular in our "Ethics of AI" activity. Once activated by the teacher prior to the session, the program saves the images taken by the camera, without the students' knowledge, in a sub-folder of the software installation directory, named "to_upload" expressly to provoke reactions.

The teacher can show this folder to the students at a later stage to discuss with them the issues surrounding data collection, with or without consent.

The saved images are automatically destroyed when the program is closed. AlphAI software does not collect or transmit any information, and in fact works offline.

This option can only be used for educational purposes.

Tools

- Change configuration folder: allows you to change the location of the configuration folder on your computer. This folder contains log files and program settings.

- Change license location

- Download robot event log: allows you to download the robot's log file (requires WiFi connection).

Useful to pass on to us in the event of a bug! - Robot test: to detect any hardware faults on the robot

From the login screen, you can also find : - Robot update: force robot update if it didn't work automatically

- Diagnose robot start-up: check that the robot starts up correctly (this test takes about 20 seconds. Another window opens when the test is complete)

Aids

- Software documentation: takes you to the Learning Robots software resources page. Here you'll find everything you need to know about AlphAI software.

- Robot documentation and activities: access the robot documentation and activities in the Learning Robots resources section. You'll find instructions and activities for each robot, FAQs, etc.

- Change log: access the list of updates

- About AlphAI: tells you which version of AlphAI you are currently using

- Show keyboard shortcuts

- Report a bug: If you encounter a problem you can't solve, this form lets you send us a message that will be associated with the software log, and thus help us solve your problem (please enter your email address so we can contact you if necessary).

Autonomy

.png)

Control your robot's autonomy with these buttons:

- Autonomous: the robot is continuously autonomous

- Step by step: click to watch your robot make one decision, and one decision only! The robot will take just one step each time you press the button.

- Exploration: in reinforcement learning mode, this button lets you force your robot to occasionally attempt a random action (configurable in the AI tab).

Learning

.png)

Control your robot's learning curve:

- Learning: if this button is selected, the robot stores the data supplied in its experience memory and changes the connections in its neural network. It's learning!

In expert display mode, you have more control:- acquire data: if this button is activated, the robot memorizes the actions it performs.

- Train the model: if this button is activated, the learning algorithm evolves the values of the model parameters.

- Manual editing: in "Manual editing" activities, click this button to modify neural network parameters directly from the interface.

- Forget action: if you click on this button, the robot forgets the last piece of data it learned: very useful if you make a mistake during the learning phase!

- Reset AI: Clicking this button resets the training data and the model, so you can start learning the robot all over again!

In expert display mode, you have more control:- Reset data: deletes stored training data

- Reset model: model parameters are reset.

Graphs

.png)

This button opens a pop-up window giving you information about your robot's training, and graphs that present this data visually.

.png)

This graph tracks the robot's progress by displaying its rewards and the error of its predictions over time. If the robot is progressing well, the reward graph should increase and the error graph should decrease.

If there is too much noise in the data, you can smooth the curves, for example over 2 minutes, by clicking on Smoothing - 2 minutes.

Settings (for AlphAI)

Use this button to set your robot's parameters:

- Speed (from 15 to 50): you can set the robot's speed, depending on the activity and the size of the arena used.

.png)

- Trajectory correction: the robot may have a small trajectory error. Use this tool to correct it (test using the go straight action).

.png)

- Accelerated simulation: if you have chosen a simulated robot, this button lets you accelerate the robot's decision-making and actions, instead of imitating real speed.

.png)

Log off

Use this button to disconnect from the robot, to change the batteries or when your session is over!

⚠️ If you disconnect from the robot, you will automatically return to the home screen. However, if you reconnect the robot and restart the activity without quitting the software, neither the configuration nor your training data will be lost.

.png)

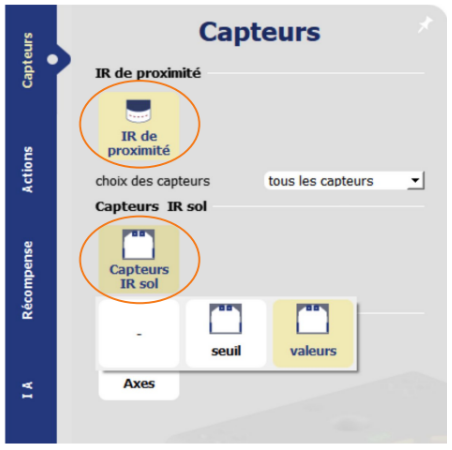

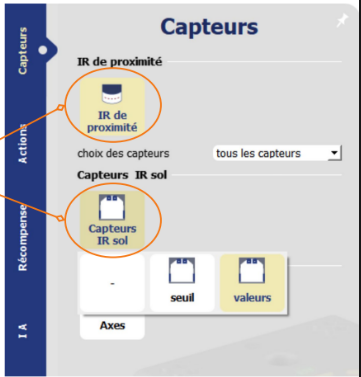

Sensors tab

.png)

The Sensors window lets you select the robot sensors to be used.

Click on a sensor to choose one of the possible usage options.

Find out more about the different sensors used in different robots:

You can also choose the number of instants, and in the case of a simulated robot, change the arena parameters.

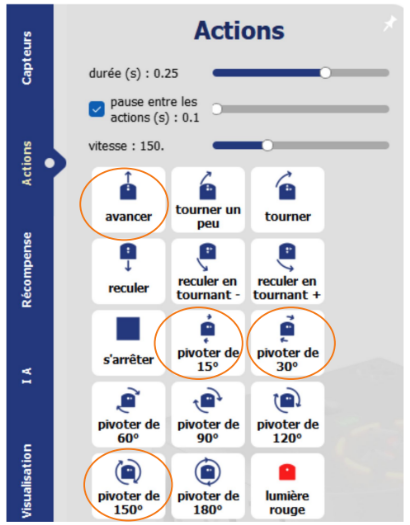

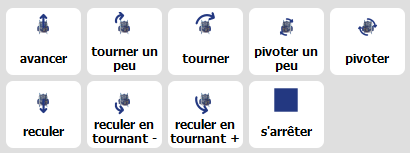

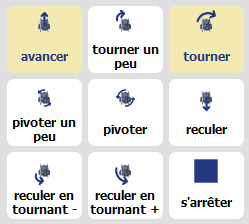

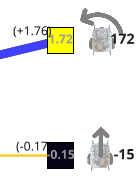

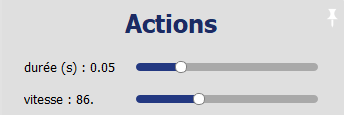

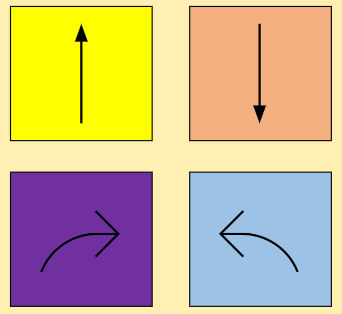

Actions tab

.png)

The Actions window lets you choose which actions the robot can perform.

Click on an action to add it to the neural network.

⚠️ Adding a new action will delete the robot's experience memory.

Discover the different actions used depending on the robots involved:

You can also choose speed, duration (from 0.1s to 2s), and whether or not you want the robot to pause between actions, and for how long.

Awards tab

.png)

If you have launched an activity with reinforcement learning, you can use the Rewards tab to choose the type of reward and its configuration.

Speed and blocking

Rewardthe robot if it goes fast, punish if it stops. You can customize the reward the robot gets when it performs a turning action, and the penalty value when it blocks or backs up.

Color in image

Reward the robot if many of the camera pixels are of a certain color.

You can customize hue, luminance and saturation.

Color and blocking

Reward the robot if many of the camera pixels are of a certain color, and punish it if it stops.

You can customize hue, luminance and saturation.

Line tracking

Recompensethe robot if it detects black just below it. You can customize the blocking detection threshold.

Python code

Set up your own rewards using a Python code file.

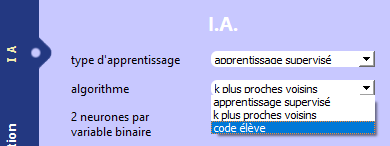

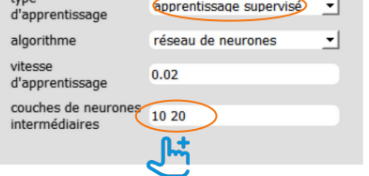

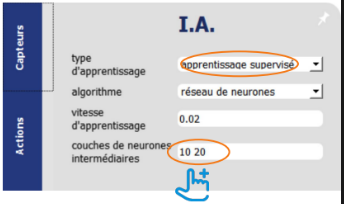

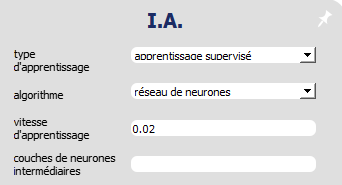

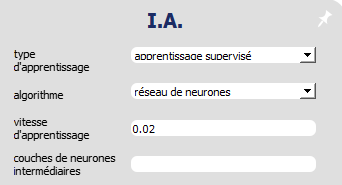

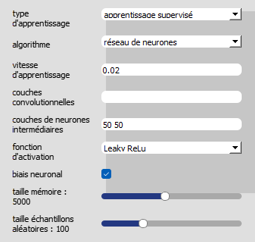

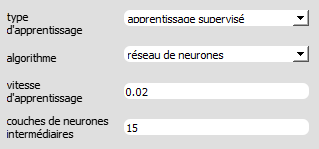

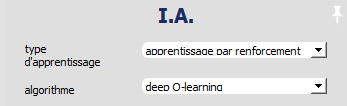

AI tab

.png)

The AI tab lets you choose how the robot is trained, in particular whether to choose supervised learning or reinforcement learning (Deep Q Learning). It also lets you adjust the parameters of the various algorithms.

The parameters may differ from one activity to another, from one type of learning to another and from one algorithm to another. But the main parameters are as follows:

- Type of learning

- Supervised learning

- Reinforcement learning

- No

- Algorithm: Select the AI algorithm used

- Neural network

- K nearest neighbors

- Python code

- Learning speed: Increase for faster learning... but decrease if divergence errors appear.

- Gamma: Adjusts the importance given to immediate rewards (value close to 0) in relation to more distant rewards (value close to 1).

- Exploration: Frequency of explorations (value between 0 and 1).

- Layers of intermediate neurons: Number of neurons in each intermediate layer e.g. leave blank to connect inputs directly to outputs, put "100 50" for two intermediate layers of 100 and 50 neurons respectively.

- Activation function: choice of activation function for intermediate layers.

- 2 neurons per binary variable: Check to have binary inputs represented by 2 neurons (of which one and only one will always be activated); Uncheck to use only 1 neuron.

- Neuronal bias: Check to allow neurons to adjust their activation threshold (this is equivalent to considering that all neurons receive a constant input that they can adjust, not represented in the graphical interface).

- Experience memory: Check to ensure that the AI continues to learn from past actions and rewards.

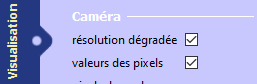

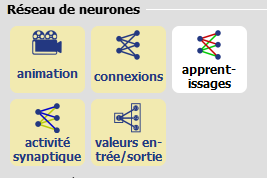

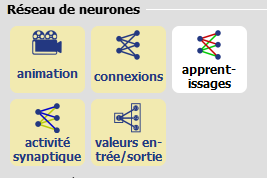

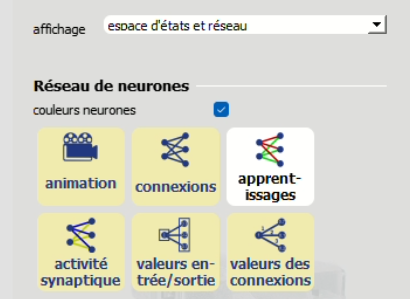

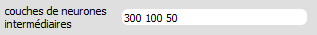

Visualization tab

.png)

The View tab lets you choose what is displayed or not on the main screen.

- Display type: neural network, state space, or both

- Animation: animating activity in the network (movement from inputs to outputs)

- Connections : Show network connections

- Apprenticeships: Show apprenticeships

- green: connections intensify

- red: connections decreasing

- Synaptic activity: Display network activity

- yellow: exciting activities

- blue: inhibition activities

- Input/output values : Display values of input and output neurons

- Connection values : Display connection weights. This option automatically activates the I/O display.

- Spacing between neurons: switches input neurons from vertical to horizontal mode

For AlphAI robot only: you can change the color of the shell. Note: the robot will memorize its new color, which will then appear on the connection screen.

The AlphAI solution offers two methods for programming robots using the Python language:

- With thepython API, you have access to a low-level interface. You have direct access to the robot's raw sensor values, and can control both motors directly and separately. However, this mode has no visualization options. It is therefore best suited to activities focused on programming itself.

- With the Python code mode accessible from within the software, you have access to a higher-level interface. Sensors and robot actions can be parameterized from the graphics window. This mode offers several options for viewing the program in the graphics window. It is ideal for practical programming, particularly when using machine learning algorithms.

You'll find more details on these two methods below.

AlphAI API documentation (AlphAI robots only)

This document contains all the information you need to use the AlphAI API:

https://drive.google.com/file/d/1C4ovPW_eH5KFz5Y9JvSrzLhtmdOpcp6-/view

Python code mode

In the AI tab

.png)

You can choose "Python code" for the algorithm parameter.

A pop-up window appears, prompting you to choose between creating a new file or opening an existing one.

This file is used to write python code that will be executed by the software.

In the Reward tab (AlphAI robots only)

.png)

Program your own reward function by clicking on the "python code" button.

Learning Robots works continuously to develop the software's functionality and improve the user experience.

That's why we carry out regular updates, which start after approval when the software is launched if you're connected by WiFi. They only take a few minutes!

We advise you to update all workstations at the same time, to ensure you have the same version of the software on each workstation.

If you have any further questions, you can search for them in our FAQ or write to us via our contact form.

To consult the list of changes made during each update since the creation of the software, please refer to the following page:

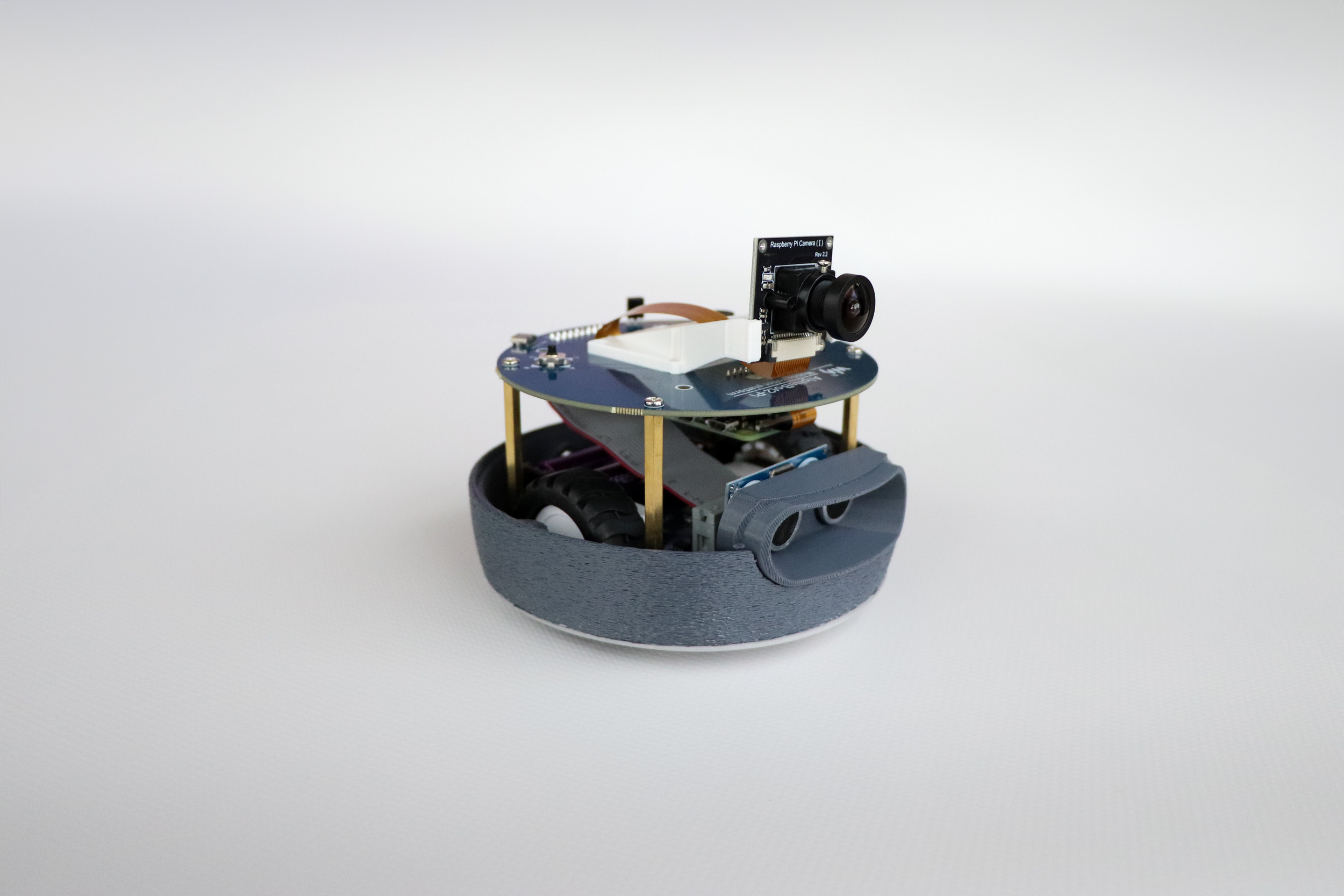

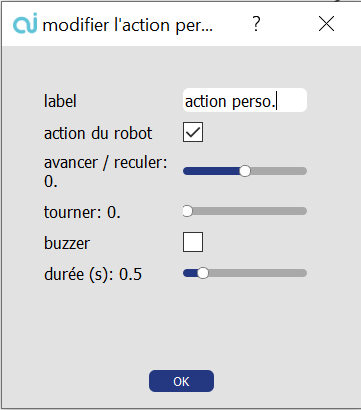

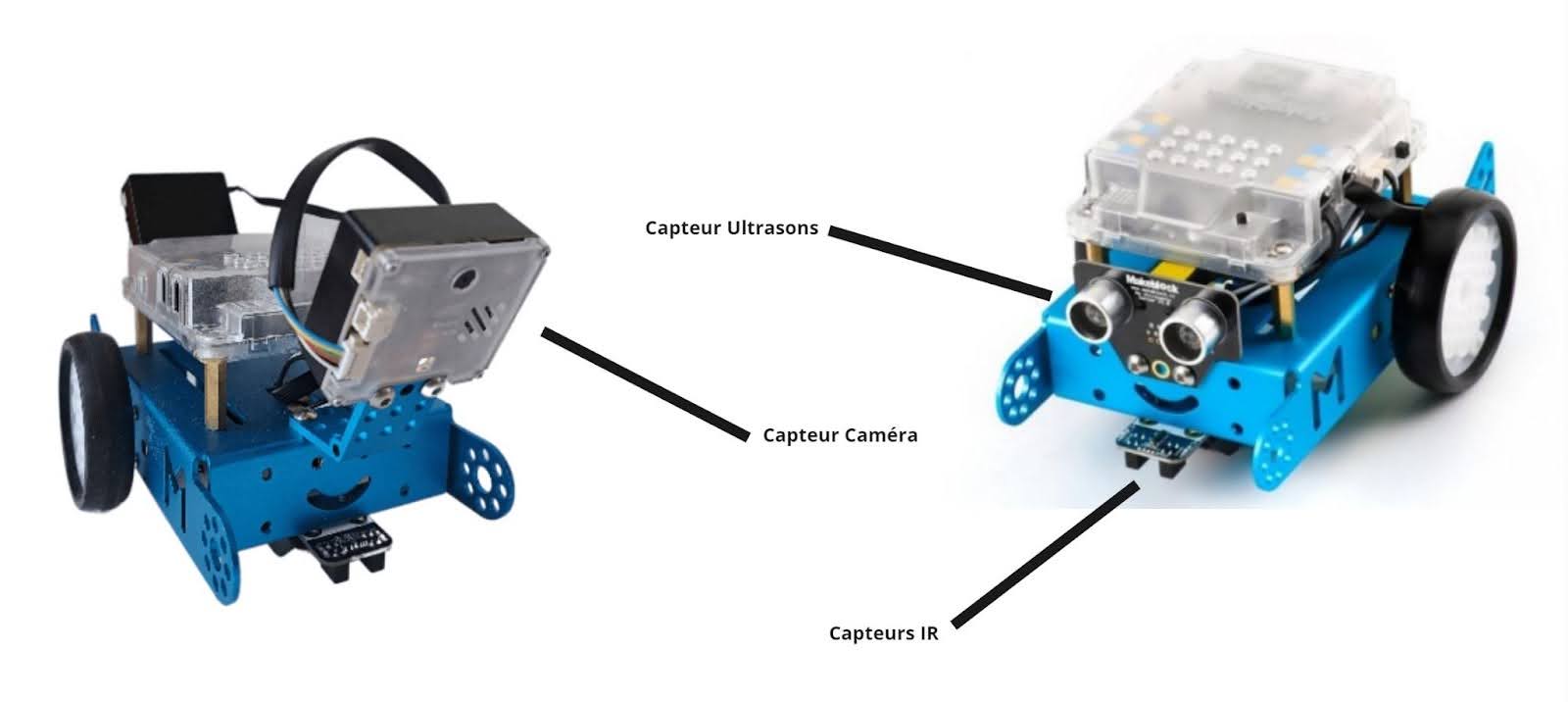

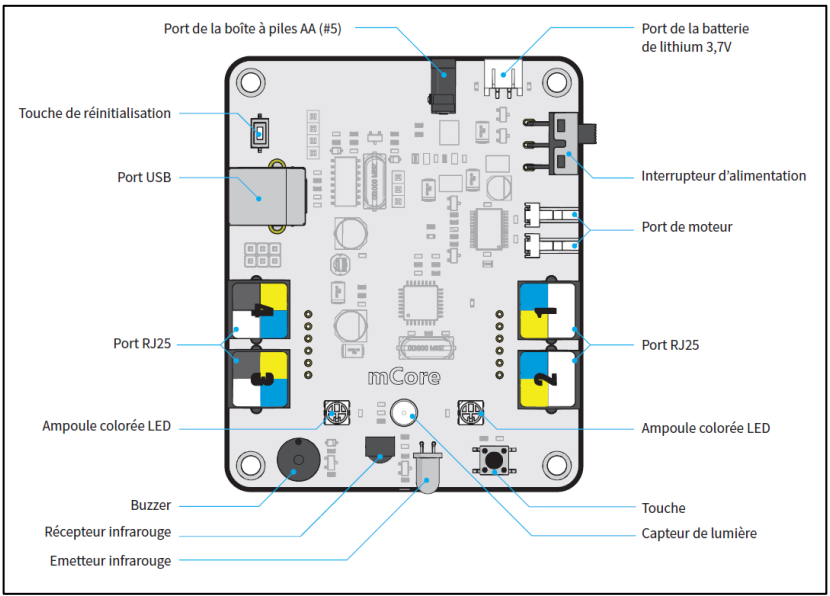

Introduction

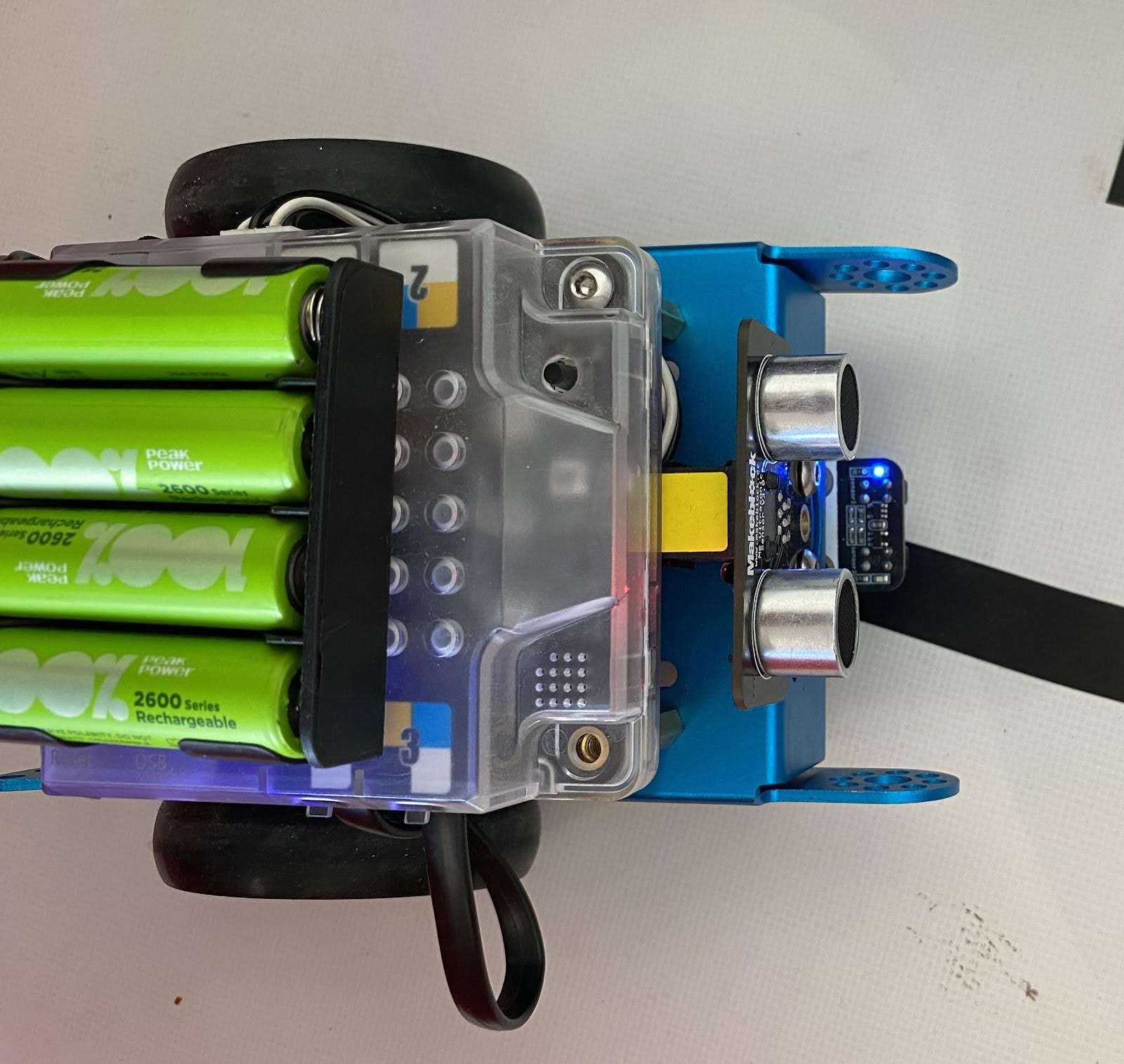

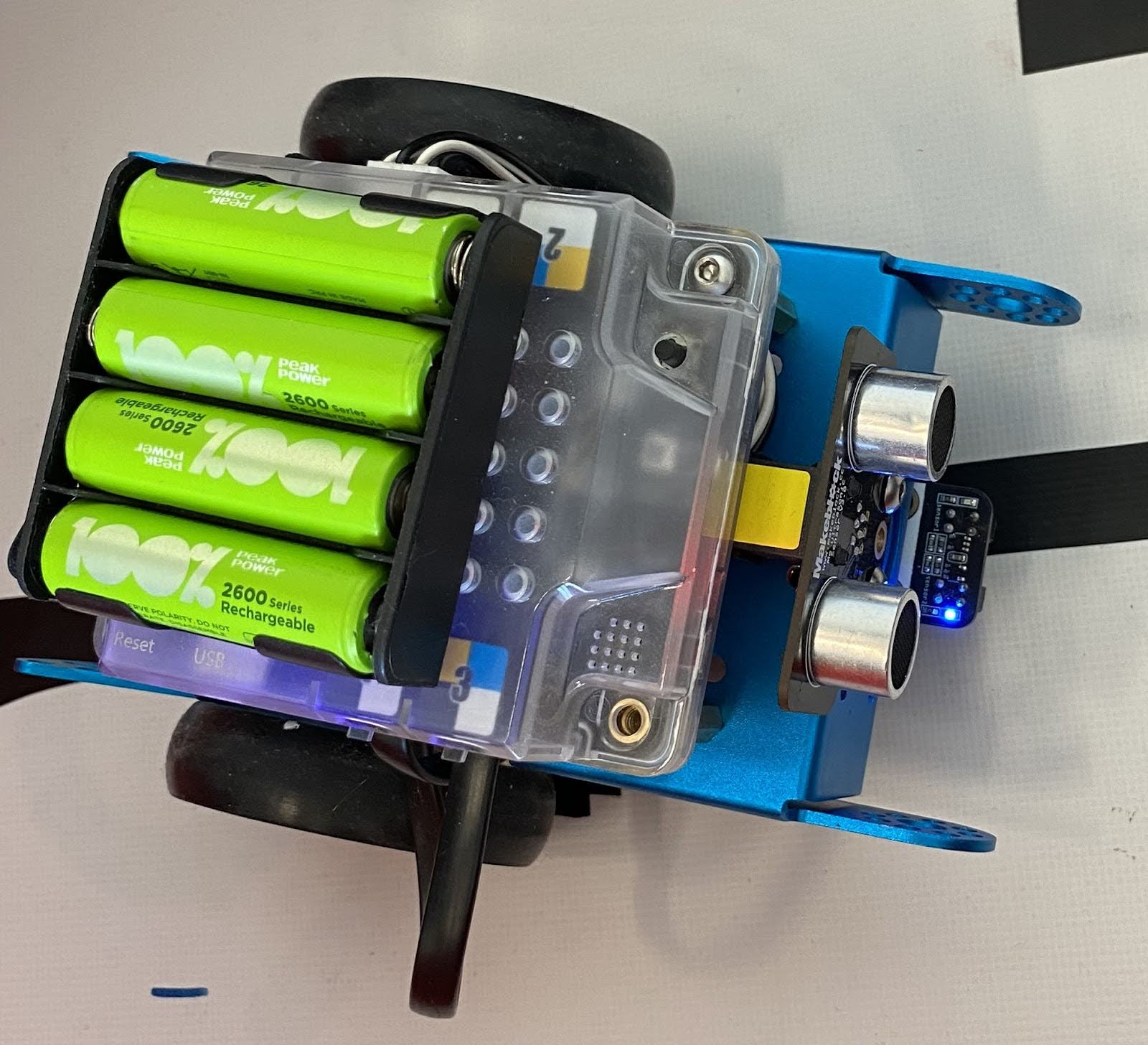

Learning Robots has designed a small, friendly-looking robot with a lot going for it!

This robot has been designed specifically for use with the AlphAI solution: its large number of sensors(in particular the wide-angle camera), its versatility and its compact size enable it to carry out all the activities available in the software.

This robot has been designed to be both robust and easy to dismantle at any time.

The hulls and bumpers are printed in-house, giving us a great deal of freedom in the design of the robot. Don't hesitate to ask us for the 3D files via our contact form if you'd like to customize them!

Composition

Sensors

- Wide-angle camera

- Ultra-sound

- 5 infrared line-following sensors

Operators

- 2-wheel drive

- 4 multi-color LEDS

- Buzzer

On-board computer

- Raspberry Pi Zero (linux, Python)

- WiFi & Bluetooth connection to PC

Hull

Attractive, shock-absorbing, removable, available in 8 colors

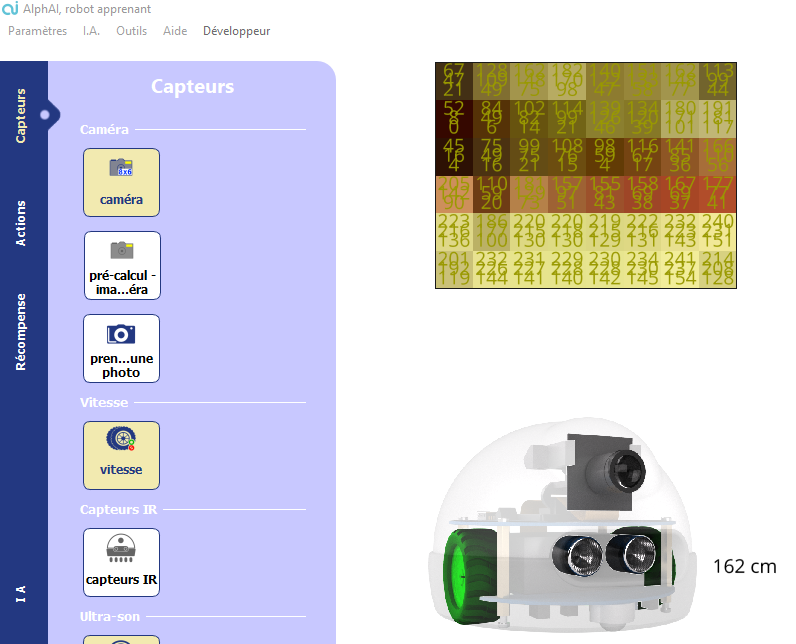

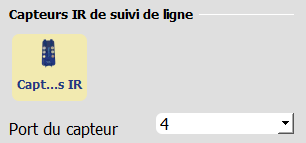

Sensors

The sensors you can use on the software are :

- Obstacle detection (wheel lock) Add a binary input (1 if the robot tried to move but failed, 0 otherwise).

In expert mode, you have access to two additional parameters:- camera motion detection threshold: used to set the sensitivity of the obstacle detector. Increase the value if you have too many false positives (sensor detecting a non-existent obstacle), and conversely decrease the value if you have too many false negatives (sensor not detecting a real obstacle).

- camera blocking height: allows you to ignore the upper part of the image when blocking is detected. With a value of 1, the entire image is analyzed, with a value of 0.5, only the lower half is analyzed.

.png)

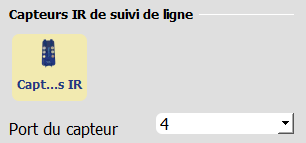

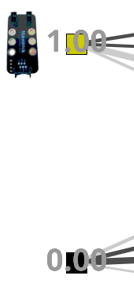

- IR sensors The 5 infrared sensors on the underside of the robot can be used. Each sensor communicates a value between 0 and 1, depending on the brightness of the surface. There are two main modes:

- Black detection: value 0 corresponds to white and value 1 corresponds to black. Recommended for tracking a black line on a white background.

- Reflection detection: value 0 corresponds to black and value 1 corresponds to white.

The binary mode option allows you to obtain only integer values 0 and 1 instead of decimal values between 0 and 1.

When binary mode is active, the IR threshold parameter is used to set the switching threshold between binary values 0 and 1. For example, when the threshold is set to 0.5 (default value), all values between 0.5 and 1 are rounded to 1, and all values between 0 and 0.5 are rounded to 0.

There are also several buttons(5 sensors, central sensor, indoor sensors, outdoor sensors) for selecting which subset of IR sensors to activate.

.png)

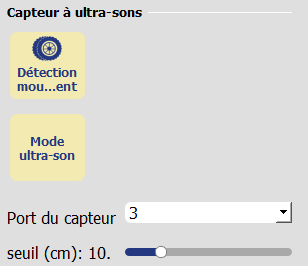

- Ultra-Sounds : uses the ultrasonic sensor on the front of the robot. It communicates a value according to the distance sensed. There are 3 operating modes:

- obstacle distance: the value returned is the distance from the obstacle measured in meters.

- obstacle proximity: the value returned is inversely proportional to the distance measured.

- Absence/presence of obstacle: the sensor returns 1 if an obstacle is detected and 0 otherwise. The obstacle detection distance can be adjusted using the slider below.

.png)

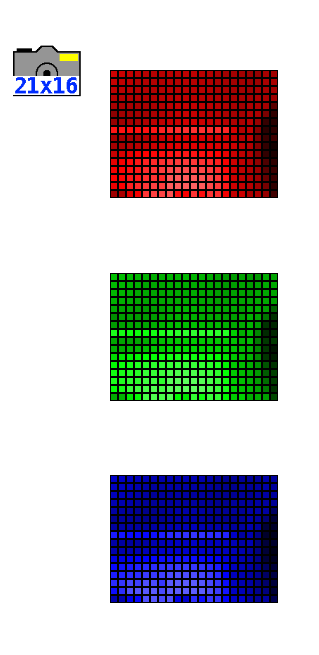

- Camera: activates the camera on the front of the robot. Several options are available to determine camera resolution and whether or not to use the zoom function.

The camera image pre-calculation button is used to modify the processed values:

- when pre-calculation is deactivated, the image defaults to color (RGB system).

- grayscale mode captures the brightness of each pixel.

- the color mode in the image detects colors. All white/gray/black pixels will obtain the value 0 and colored pixels the value 1.

- green channel mode detects only the presence of green (values close to 1) or its absence (values close to 0).

- red vs. green mode returns a value between -1 and 1 for each pixel, corresponding to the amount of red minus the amount of green.

The take photo button lets you take a photo with the robot's camera and save it on your computer.

.png)

.png)

- The last action button activates the last action memory when the robot needs to make a decision. This can be useful, for example, to avoid situations where the robot performs an action which cancels out the previous action (moving backwards after having moved forwards, or pivoting to the right after having pivoted to the left).

- In simulated robot mode, the simulated robot status sensor returns information on the position, orientation and speed of the simulated robot.

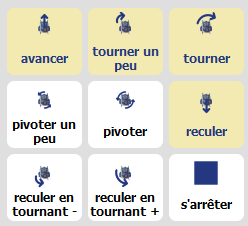

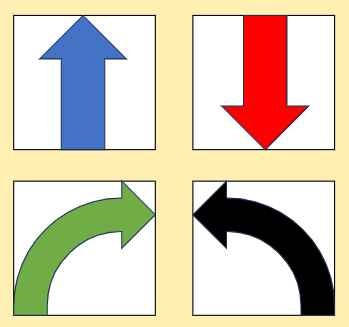

The actions

The actions you can use on the software are :

.png)

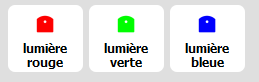

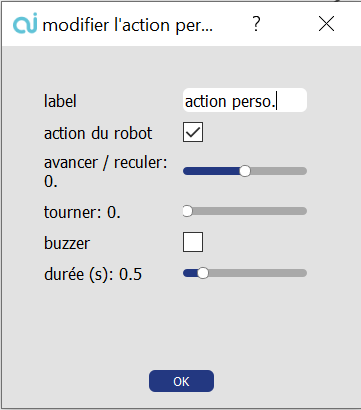

You can also create a custom action by clicking on the button:

The following window will then appear:

.png)

Name your action and check "robot action" to modify the parameters: the new action is now available.

To save it for future use, click on File > Save > Save configuration.

Operating environment

We recommend that you use the robot in an AlphAI arena, which you can find in our Online Shop.

To carry out all the activities on the software, the robot will need :

- A very flat, clean, solid-colored surface

- Exterior and interior walls in different colors (and different from the floor), higher than the robot.

- One or more lines on the ground in a color that contrasts sharply with the tarpaulin (use black scotch tape, for example; it's supplied with the arenas).

If you don't have an arena, or even a robot, there are plenty of activities you can do with the AlphAI robot, simulated in 2D in the software.

Wifi (recommended)

We recommend that you always use a WiFi connection if possible, as this enables you to communicate with the robot at a much higher speed. What's more, it's mandatory for robot updates.

- Look at the number on the underside of your robot, taking care to hold it by its base and not its shell, then switch it on by turning the PWR SWITCH to ON.

- Place the robot in the arena and wait a few moments, until the robot vibrates and flashes.

- Open your computer's WiFi connection panel: the robot will appear under the name "ALPHAI-00XXXX" (XXXX being the number you've written under the robot). Connect to the robot: the password is an exact copy of the WiFi network name (ALPHAI-00XXXX).

- Launch AlphAI software. In the top right-hand corner of the home screen, check that you have selected the AlphAI robot model.

- The robot with its number and a Wifi icon then appears on the connection screen: click on it

- The robot vibrates, its lights glow steadily and the software interface opens. And off you go!

⚠️ Before switching off your robot or changing its batteries, we advise you to press the "disconnect" button at the bottom right of the interface screen.

By Bluetooth

If you prefer to connect the robot to your computer via Bluetooth, you should be aware that the transmission rate is lower than with WiFi. What's more, when the robot needs updating, you'll need to use the WiFi connection.

- Look at the number on the underside of your robot, taking care to hold it by its base and not its shell, then switch it on by turning the PWR SWITCH to ON.

- Place the robot in the arena and wait a few moments, until the robot vibrates and flashes.

- In your computer settings, check that Bluetooth is enabled.

- Launch AlphAI software. In the top right-hand corner of the home screen, check that you have selected the AlphAI robot model.

- Make sure that the "Bluetooth Low Energy" button at the top right of your screen is activated (with a yellow background).

- The robot with its number and a Bluetooth icon then appears on the connection screen: click on it

- The robot vibrates, its lights come on continuously and the software interface opens.

⚠️ Before switching off your robot or changing its batteries, we advise you to press the "disconnect" button at the bottom right of the interface screen.

Your robot doesn't appear? → BLE deactivation

In simulation

If you don't have an AlphAI robot, you can still use our software with the 2D simulator:

- Launch AlphAI software

- Check at the top of the screen that you have selected the AlphAI robot model in the software.

- Click on "2D Simulator

- The software opens: in the bottom left-hand corner of the screen, watch a small robot simulated in a 2D arena!

- The virtual arena can be customized by changing the colors of the outer and inner walls, as well as by removing this wall. To access it, you need to activate expert mode by proceeding as follows: File → View settings → Expert then go to the Sensors tab (on the left of your screen), you'll find all the virtual arena settings at the very bottom.

Battery replacement

The robot uses rechargeable lithium-ion batteries, which are very powerful but discharge quickly. For this reason, we recommend that you always keep the spare batteries supplied charged nearby.

If the robot's batteries are about to run down, a red battery icon will appear in the bottom left-hand corner of your screen. Change the batteries in less than a minute:

- Press the "logout" button at the bottom right of the screen. You'll land on the home screen

- Lift the robot, taking care to hold it by its base and not its shell, then switch it off by turning the PWR SWITCH to OFF.

- Remove the robot shell by exerting gentle pressure on its base, then pivoting it forward to release the camera.

- The batteries are located on the rear panel: use your finger to replace them with charged batteries, taking care to observe the + and - signs.

- We recommend that you immediately place the empty batteries to be recharged on the AC charger supplied.

- Replace the shell on the robot, starting from the front; make sure the camera is correctly positioned in its slot, then check that the entire base of the shell is inserted into the robot chassis. Press gently on the back of the shell: you should hear a small "click".

- Switch the robot back on, reconnect it and resume your activity!

We recommend that you always charge the batteries used during activities at the end of the session.

Robot updates

Learning Robots is constantly developing the software, the AlphAI robot and the user experience. That's why we regularly release updates, which are automatically transmitted to the robot's Rapsberry Pi the next time it connects via WiFi.

See FAQ.

Recurring problems

Your robot won't turn on? Can't connect to the software? Are your robot's wheels blocked?...

Find the answer to your problem on this page:

See FAQ.

Support & warranty

AlphAI robots are guaranteed against malfunction for up to 2 years from date of purchase.

With intensive use, it is normal for motors to show wear: we offer motor replacement kits, which you can find in our online store. Don't hesitate to contact us if you'd like us to take care of the replacement.

The Learning Robots team remains at your disposal. If you can't find a solution to your problem on our FAQ page, please don't hesitate to contact us via our contact form.

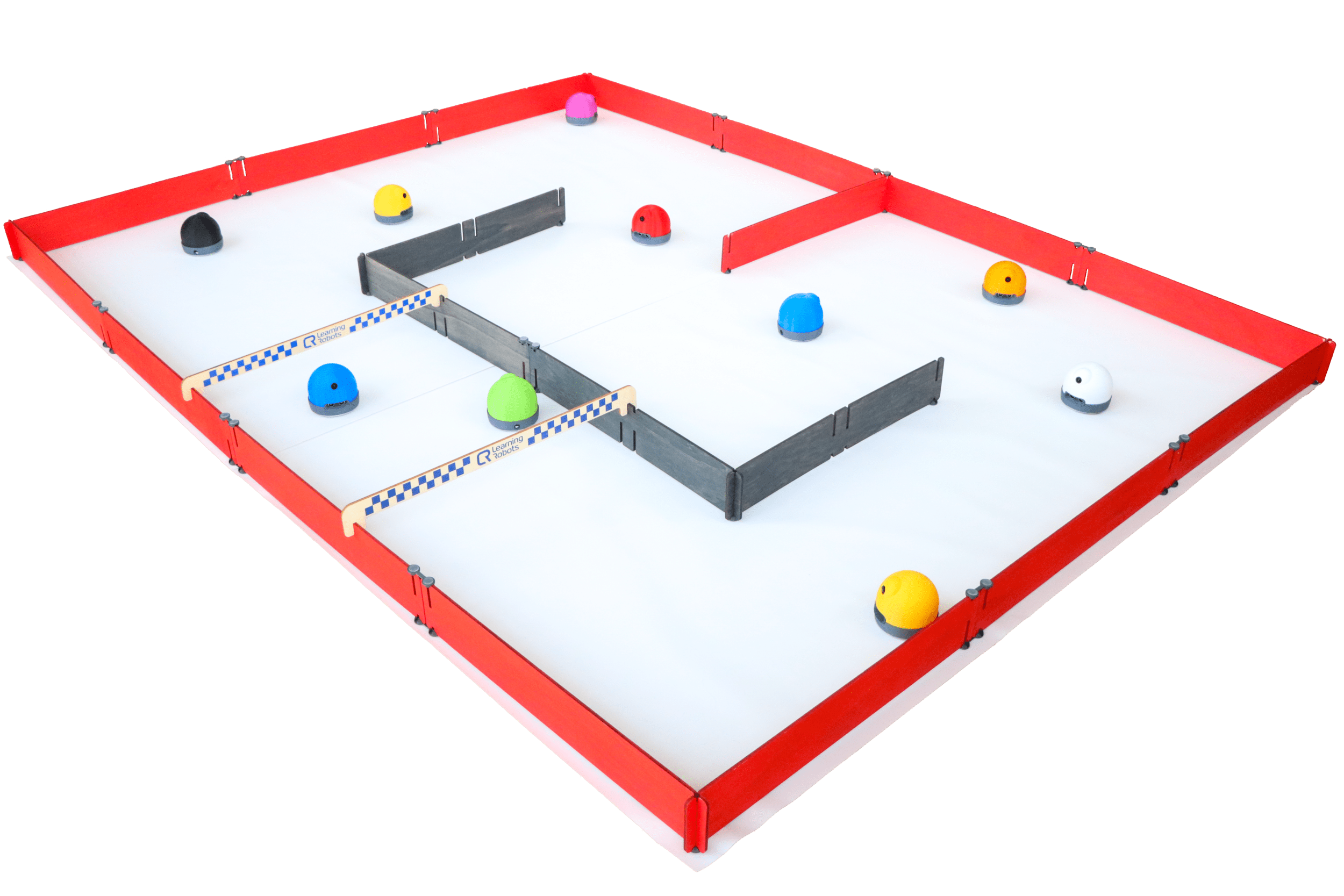

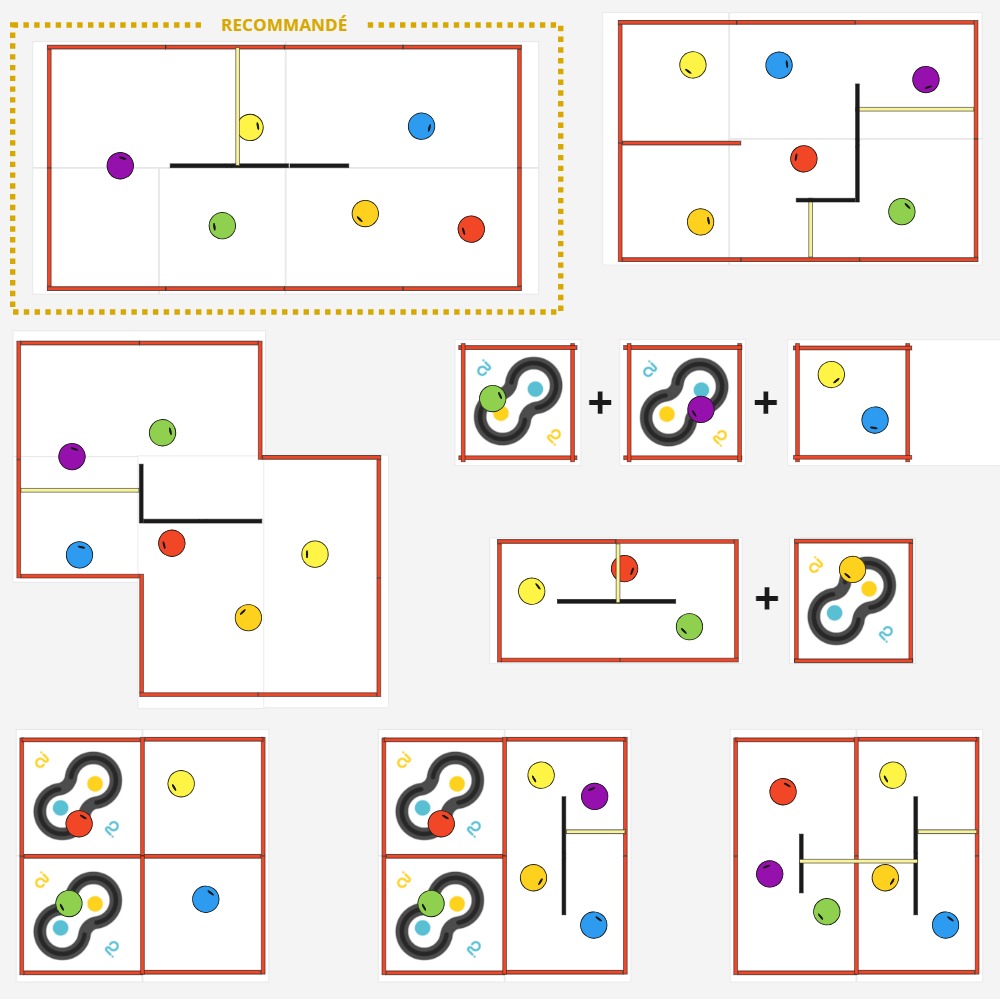

To enable the robot to evolve in a perfectly adapted environment, Learning Robots has designed a modular arena system that is easy to assemble and transport.

The arenas are available in 4 different sizes, which can be combined according to your needs and the number of robots.

They consist of painted wooden boards, tarpaulins and supports.

They are made of Jura pine by Olivier Sauge (https://www.saugeartisansdubois.com) in France.

Composition

- tarpaulin(s) to lay on the ground, with or without printed design, on a perfectly flat surface. Assemble the tarpaulins with painter's tape (included) to increase the surface area of the arena!

- red planks, which form the outer walls of the arena, to be assembled using notches and brackets

- black boards, which form the inner walls of the arena, to be assembled using notches and brackets. Hold the black boards to the red boards using the racing banners.

- race banner(s), which join interior and exterior walls, creating a race start for your robots! They are supplied with

- Supports :

- Feet: for use in corners under notches (interlocking boards) or at the ends. There's no need to use them on top.

- Connectors: for joining boards in a straight line. It is advisable to use them both above and below the connections. They can be used both parallel and perpendicular to the boards, depending on the desired layout.

Assembly

- Start by laying the tarpaulins on the ground, on a very flat surface, and hold them together with painter's tape for greater stability.

- Assemble exterior walls using notches and brackets (only underneath for feet)

- Position the inner wall(s) in the center of the arena with their foot supports.

- Connect the inside and outside walls with the racing banner(s), making sure to raise the banner(s) with the supplied risers.

The arenas can be adapted to suit your needs! Here are just a few examples:

⚠️ If you have a single black board in the center of the arena (which cannot be held to the outer red boards by the racing banner), we recommend doubling up this board using connectors for greater stability.

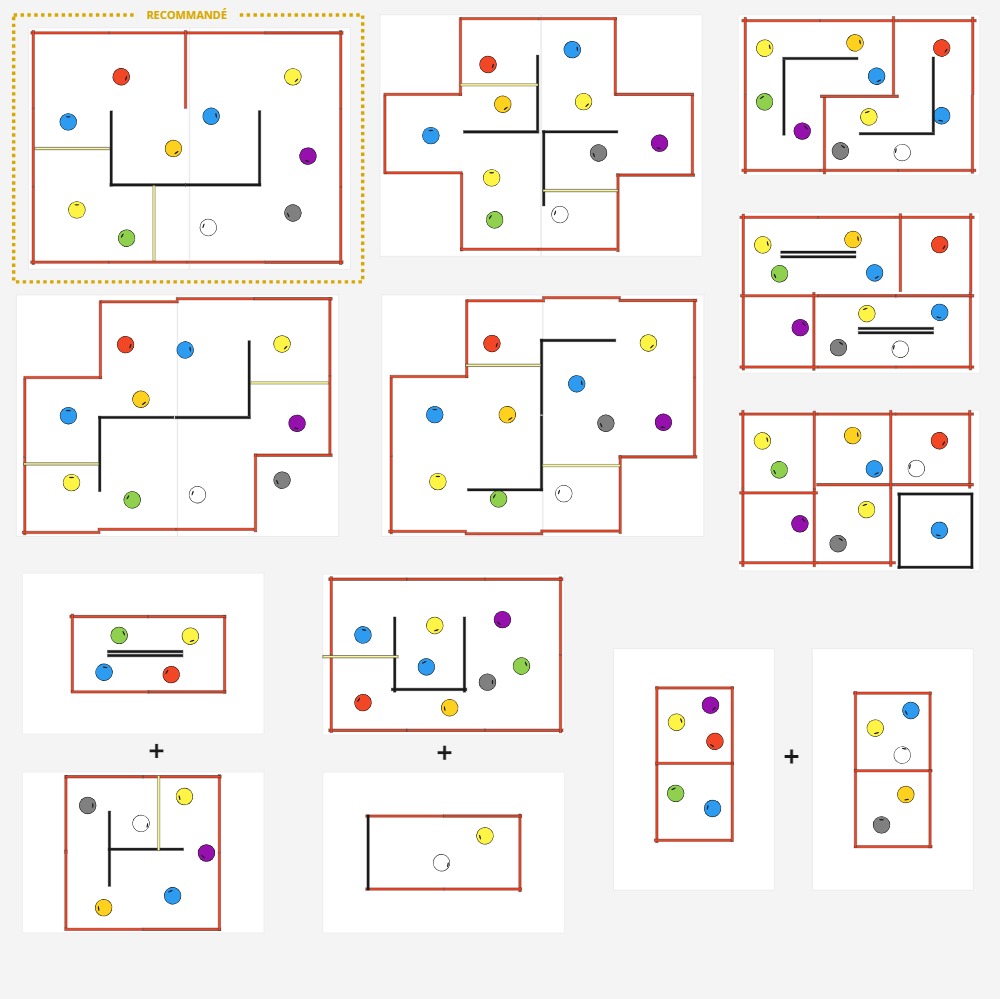

Using scotch tape

Using the black tape supplied with your arena, you can draw lines on the ground for your robot to follow! They can be easily removed from the tarpaulin at the end of the activity. See AlphAI Line Tracking Activity

The most common shape is an 8, but don't be afraid to use your imagination! Use gentle curves to avoid disturbing the robot.

Materials required:

- 2 robots minimum

- 1 computer/robot

- Racing arena

The advantages of this activity :

- Fun

- Popular with all ages

- Perfect for introducing the principle of supervised learning

Duration :

40 to 60 minutes

Age :

+ 8 years

Software configuration :

Robot race mode

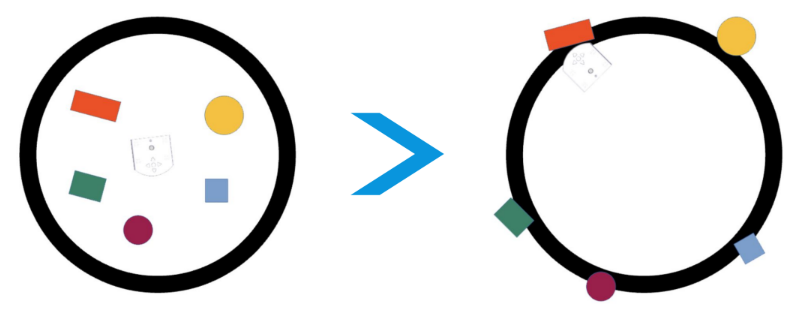

A fun activity for an arena with several robots: students train the robots to drive around a circuit, then organize a race. Through manipulation, students learn the principle of supervised learning and the importance of quality training data.

Robot racing is the recommended activity for getting started with AlphAI.

Introduction

Build your arena to form a circuit. We recommend using a racing arena designed by Learning Robots, but you can also build your own circuit: in this case, make sure there's a good visual contrast between the ground and the edges of the circuit, that the lighting is uniform and that the ground is clean.

Setting

Connect each robot to a computer, then choose the "robot race" example configuration or create your own settings.

Make sure that all robots have the same settings and, above all, the same speed.

Training

Check that the "stand-alone" button is deactivated, and that the "learning" button is activated.

It's your turn to play! You can train your robot to move by clicking on the actions on the right of the screen, or by controlling it with the arrow keys or AZEQSD on the keyboard.

We recommend that you move around the arena in a clockwise direction.

During this learning phase, there's no need to try to go fast: the aim is to teach the robot to make turns in the right direction, without bumping into walls. Take the time to choose the right action each time (if you make a mistake, click on "Forget action" next to the learning button). Be careful not to confuse left and right when the robot is moving in the opposite direction!

Teach the robot to stay away from the central obstacle to avoid getting stuck when it becomes autonomous.

You can also move the robot by hand to intentionally confront obstacles and teach it what to do in these situations.

In the control panel at the bottom of the screen, you can set the robot's top speed. We recommend a maximum speed of 30 for a small race arena, 35 for a large race arena, and 40 for a very large race arena.

The higher the speed, the faster the robot will be, but the harder it will be to control. Choosing a very high speed is not always an advantage!

Learning tests and improvements

Once you've done a few laps around the arena, you can activate autonomy. If your robot is well trained, it will then start doing tricks on its own!

But the learning process isn't over yet: even when the robot is self-piloting, you can continue to control it by pressing the arrow keys while it's moving. For example, if the robot gets stuck against a wall and doesn't know what to do, you can unblock it by asking it to move backwards (provided the "move backwards" action has been activated in the "actions" tab on the left of the software interface.

The robot race

Once your robots have been trained, organize a competition: place the competing robots on the starting line. Give the starting signal, and the teams simultaneously click on the "Autonomous" button (or press the space bar on the keyboard) to start the race.

During the race, only autonomous mode is allowed: participants must not give instructions to their robot. A referee may move robots that are blocked for more than 5 seconds, to allow them to continue the race.

The first robot to complete 3 full laps wins!

Feedback and conclusion

We have used a supervised learning algorithm. This algorithm is based on the artificial neural network displayed on the screen (but there are other types of algorithms that are not based on neural networks, such as the K-nearest neighbor algorithm). All supervised learning algorithms work as follows:

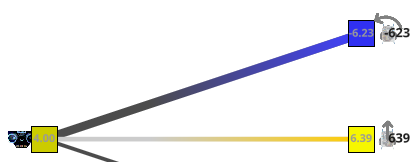

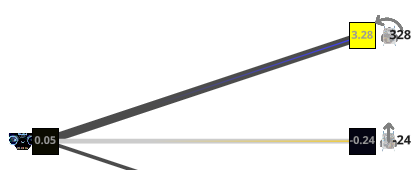

In a first phase called training, we provided the algorithm with example decisions, i.e. both images of what the robot's camera sees and the actions it should choose when the camera sees these images. During training, the artificial neural network was modified by the learning algorithm (more specifically, certain connections were strengthened, others diminished, so that the neural network became capable of mimicking the same decision making).

In a second phase, called utilization, the algorithm is able to make good decisions on new images.

We have seen that not all the robots learned the same thing: some performed better during the race, others worse. As all participants used the same algorithm, we can see that the quality of autonomous decision-making depends on the quality of the training data.

We can discuss together what makes quality training data:

- Quality of training data = absence of decision-making errors

- Data quantity not always a guarantee of autonomy quality

- Exhaustiveness of situations: the robot is more likely to make the wrong choice when faced with an unknown situation.

Further information

Now that the students have understood that the most important factor in winning the race is the quality of the training data, start the activity all over again!

You can also restart the race by adding new rules:

- Limit training data (e.g. 25 data points maximum), but allow participants to move their robot by hand during the training phase.

- Making the arena more complex

- A different arena for training and racing

Materials required:

- 2 robots minimum

- 1 computer/robot

- Racing arena

Duration :

40 to 60 minutes

Age :

+ 8 years

The advantages of this activity :

- Fun

- Popular with all ages

- Perfect for introducing the principle of supervised learning

Software configuration :

Robot race mode

Materials required:

- 1 robot minimum

- 1 computer/robot

- Flat, light-colored surface

- Black adhesive tape

Software settings :

"Line tracking" for manual editing (create connections directly on the software) or supervised learning (train the robot on the track)

Duration :

20 to 30 minutes

Age :

10+ years

The advantages of this activity :

- Little equipment required

- Quick and easy to make

- Easy-to-understand neural network

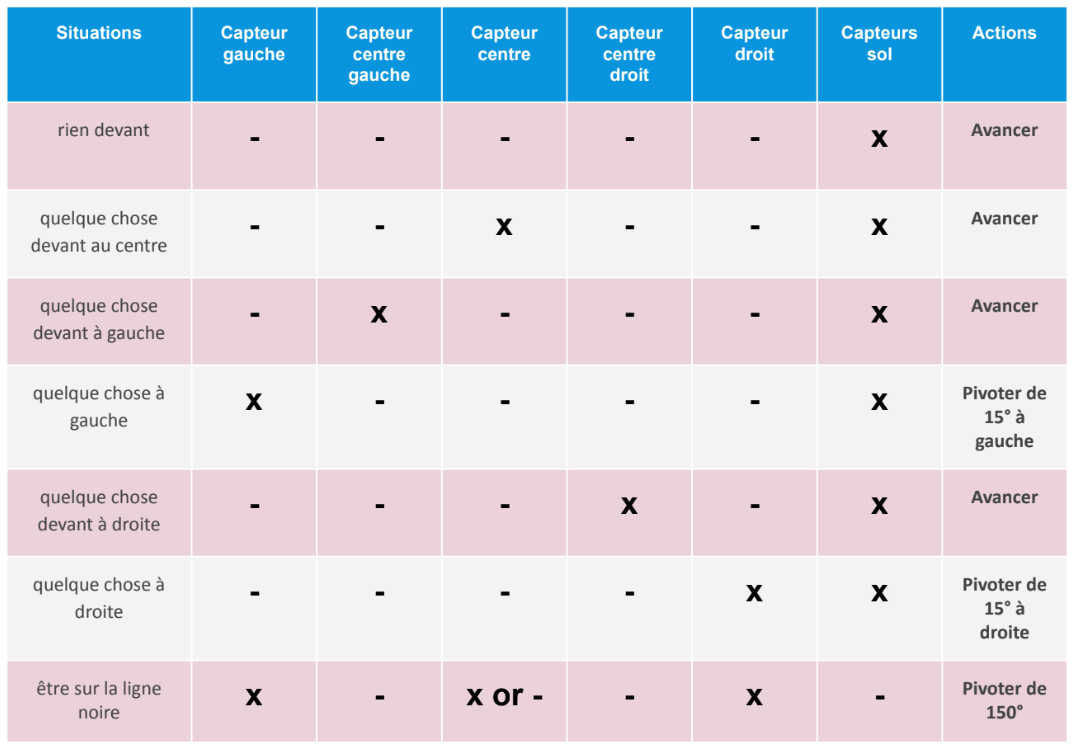

This activity is carried out with each robot individually. We're going to teach the robot to follow a line on the ground, without making any mistakes!

Students will learn that the success of supervised learning depends more on the quality and completeness of the robot's training data than on its quantity. They will be able to understand the principle of an artificial neural network very easily, as the one used in this activity is very simple and easy to read (5 inputs, 5 or 6 outputs).

[Video content coming soon]

Introduction

On a flat, light-colored surface, trace a course using black tape (supplied with the arenas).

If you want to use your own equipment, make sure that the robot perceives the contrast between the ground and the line.

The classic shape is an "8", but feel free to use your imagination!

Be sure to create gentle curves to avoid disturbing the robot.

Parameter setting (connection)

Connect the robot to a computer (see section robot connection if necessary), then choose the "line tracking" example configuration for manual editing or supervised learning, or create your own parameters.

Use the cursor at the bottom of your screen to check that the robot's speed is less than or equal to 20.

Training

If you are editing manually :

Check that the "stand-alone" and "learning" buttons are disabled, and that the "manual editing" button is enabled.

Click on the links between the input (infrared sensors) and output (robot action) neurons to create a connection. We recommend you create the following connections:

- Left IR sensor: rotate left

- Center-left IR sensor: turn slightly left

- Central IR sensor: go straight ahead

- Center-right IR sensor: turn slightly to the right

- Right IR sensor: rotate to the right

This is what your neural network should look like:

If you are a supervised apprentice :

Check that the "stand-alone" button is unchecked, and that the "learning" button is checked.

Place the robot on the line drawn on the floor to activate the sensors. Each time one of the sensors is activated, trigger the corresponding action:

- Left IR sensor: rotate left

- Center-left IR sensor: turn slightly left

- Central IR sensor: go straight ahead

- Center-right IR sensor: turn slightly to the right

- Right IR sensor: rotate to the right

- No sensor activated: back off

We recommend that you give several examples for each situation.

Learning test

Once the neural network is configured, let's see if the robot manages to follow the line!

Place it at the beginning of the course, activate the autonomy and watch how it performs.

You can then make the track more complex by adding intersections to create new challenges for the robots!

Review and feedback

Thanks to a very simple neural network and very little training data, the robot succeeded in following the line.

We can observe on the software the weight given to each connection, and understand how the robot makes its decisions: depending on which sensor is activated (or not), the algorithm assigns preferences to each of the actions to be chosen: the robot selects the action with the strongest preference.

Has your robot gone off track or taken the wrong action? Find out why! Here are a few suggestions:

- there's a bias: you've made a mistake in training the robot

- several sensors are activated at the same time, for example at a crossroads: has the robot been trained to react to this situation?

- the angle of a ground line curve is too steep

- robot speed is too high

Materials required:

- 1 robot minimum

- 1 computer/robot

- Flat, light-colored surface

- Black adhesive tape

Duration :

20 to 30 minutes

Age :

10+ years

Software settings :

"Line tracking" for manual editing (create connections directly on the software) or supervised learning (train the robot on the track)

The advantages of this activity :

- Little equipment required

- Quick and easy to make

- Easy-to-understand neural network

Materials required:

- 1 robot minimum

- 1 computer/robot

- Optional arena

(recommended for high surfaces)

Software configuration :

- example configuration:

"navigation with camera

Duration :

1 hour

Age :

Ages 8 and up

The advantages of this activity :

- Fun and visual

- Quick to set up

- Very suitable for younger children

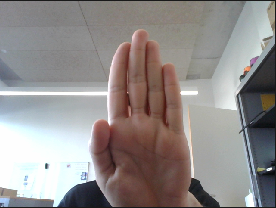

Students can teach the robot to follow their hand or a clearly identifiable object.

This can be taken a step further by letting the students' imaginations run wild, creating courses or choreographies in which the robot reacts to various visual cues, such as hand signals.

[Video content coming soon]

Introduction

Place the robot on a table with enough space to move around. You can use an arena if you want to prevent the robot from falling off the table. In this case, a small, unobstructed arena will suffice.

Setting

Connect the robot to the computer, then select the "navigation with camera" example configuration.

We'll use the camera sensor, and the following actions: move forward, rotate right, rotate left, and stop.

Be sure to adapt the speed to the size of the table.

Training and implementation (learning phase)

Training will be done in pairs, taking care to be well coordinated.

One of the students will wave to the robot, while the other manages the software.

The aim is to teach the robot to follow the student's hand (or a clearly identifiable object).

In the first phase, one of the students places his hand in the robot's camera field of view, while the other chooses the action that will bring the robot closest to the hand. Give the robot several examples for each hand position in the image.

In the second phase, you'll need to teach the robot to stop when it doesn't see a hand. Again, the robot needs several examples with different points of view: the student in charge of the software clicks on the "stop" action, while the other student places the robot in different locations (taking care not to put anything in front of the camera, of course!).

Learning tests and improvements

Now activate Stand-alone mode.

Check that the robot has learned correctly by observing whether it follows your hand correctly.

If this is not the case, deactivate autonomous mode again and re-train the robot.

Avenues for further development

- Reverse the roles. Does the robot manage to follow the other student's hand or a different object? If not: continue training until the robot is able to follow the hands of both students.

- Place the robot on a course (draw 2 parallel lines on the floor, for example), set it in autonomous mode and guide it along the course by hand. Allows you to evaluate both the robot's training and the student's guidance.

- Train one robot to follow another! The robot in front will be controlled, and the other will have to follow in autonomous mode. Tip: remember to choose a slightly slower speed for the following robot.

- Visualize training data and correct errors. This will improve the robot's behavior.

Review and feedback

The students' mission was to train an AI (supervised learning).

After learning, the robot is able to interact with a user by reacting to hand signals.

By showing the robot examples, it can correctly associate the right actions with the corresponding hand signals, thus "communicating" with it.

Key concepts:

- Training data determines robot behavior.

- Data quality (absence of errors) is very important.

- We also need to provide the robot with sufficiently diverse examples if we want it to be able to generalize the behavior it follows (e.g. following another object or a different hand).

Materials required:

- 1 robot minimum

- 1 computer/robot

- Optional arena

(recommended for high surfaces)

Duration :

1 hour

Age :

Ages 8 and up

Software configuration :

- example configuration:

"navigation with camera

The advantages of this activity :

- Fun and visual

- Quick to set up

- Very suitable for younger children

Materials required:

- 1 robot minimum

- 1 computer/robot

- Minimum individual arena (without obstacles)

Software configuration :

- example configuration: "KNN camera".

Duration :

30 minutes

Age :

+ 14 years

The advantages of this activity :

- Intuitive algorithm

- Can be performed with the simulator

- Excellent visualization of robot decision-making

Visualization and application of the K-nearest neighbor algorithm (part of the first year NSI curriculum) to teach the robot to avoid obstacles.

Expert level: in the "Advanced KNN Algorithm" activity, students can reprogram the algorithm themselves and implement it on the robot.

Introduction

Place the robot in an arena without interior walls. Make sure the arena is well lit, so that there is a strong contrast between the floor and the walls.

Setting

Connect the robot to the computer and select the "KNN camera" example configuration.

Ensure that the robot speed is 30 or less.

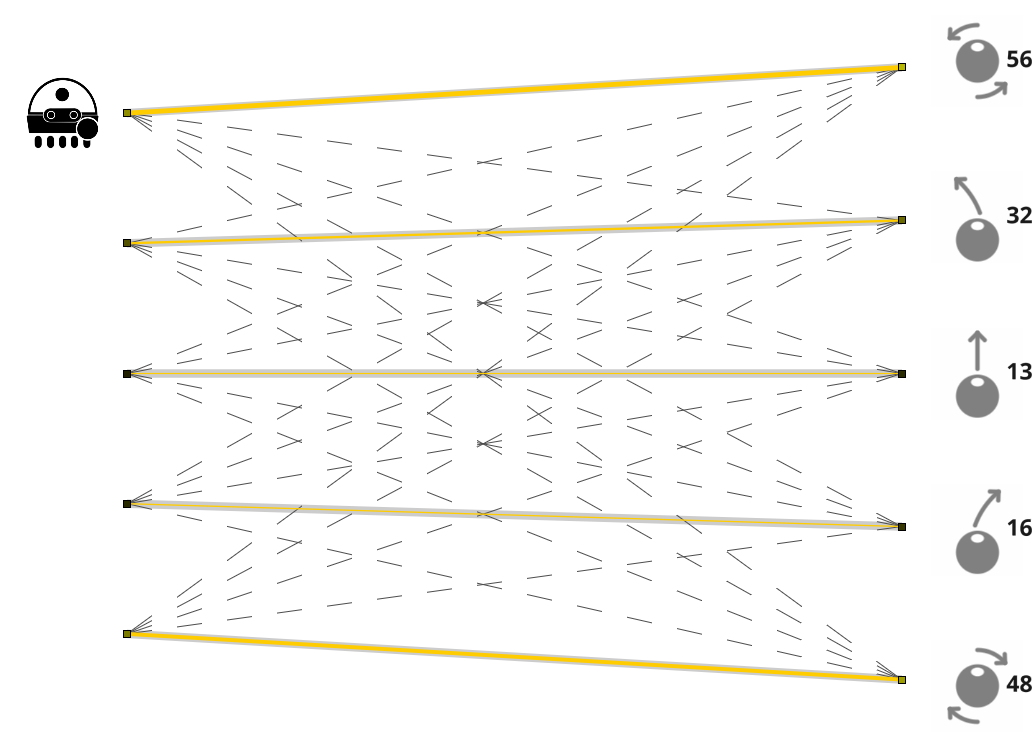

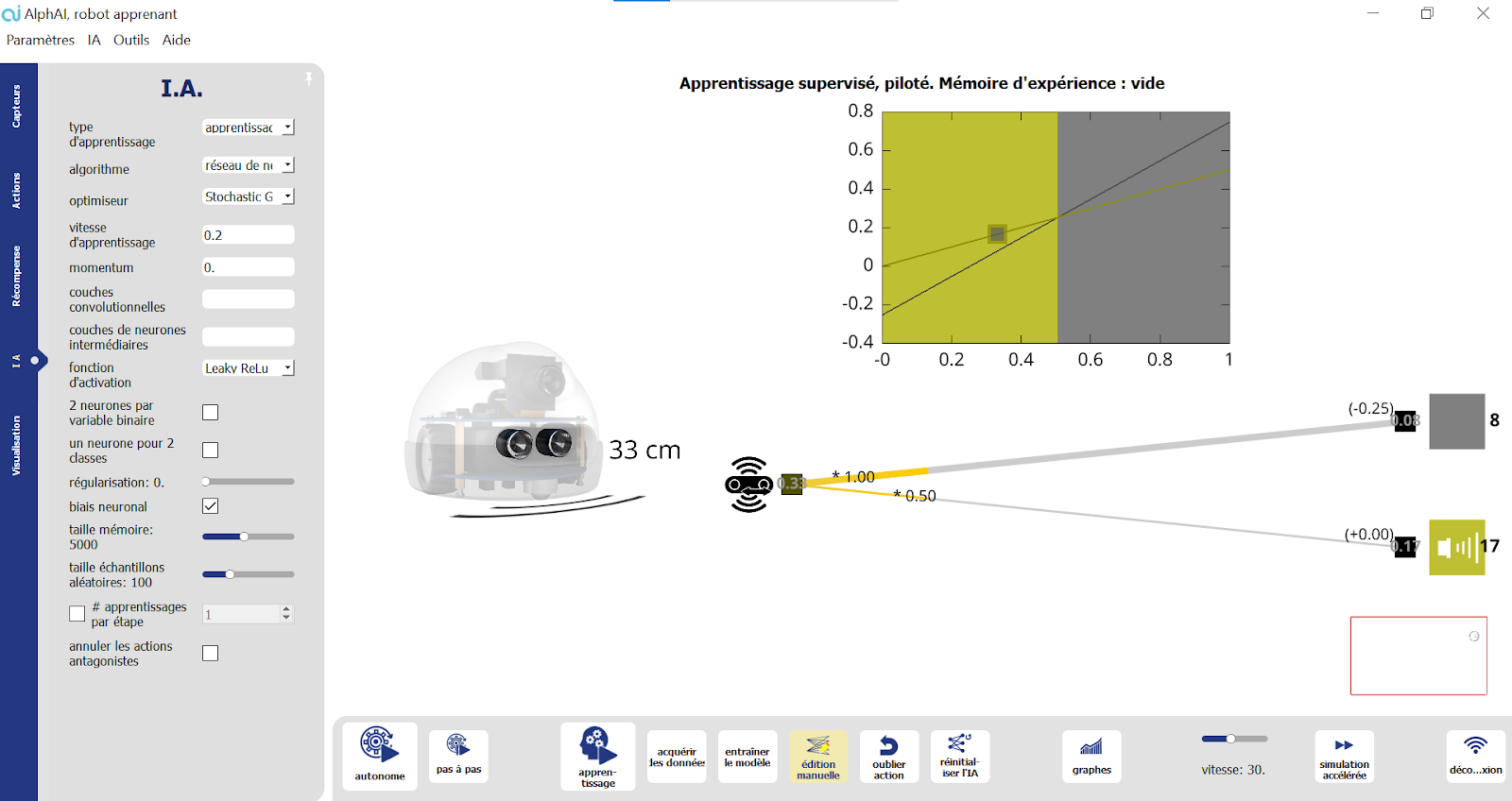

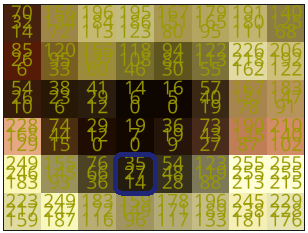

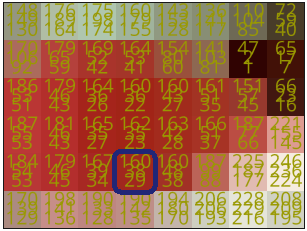

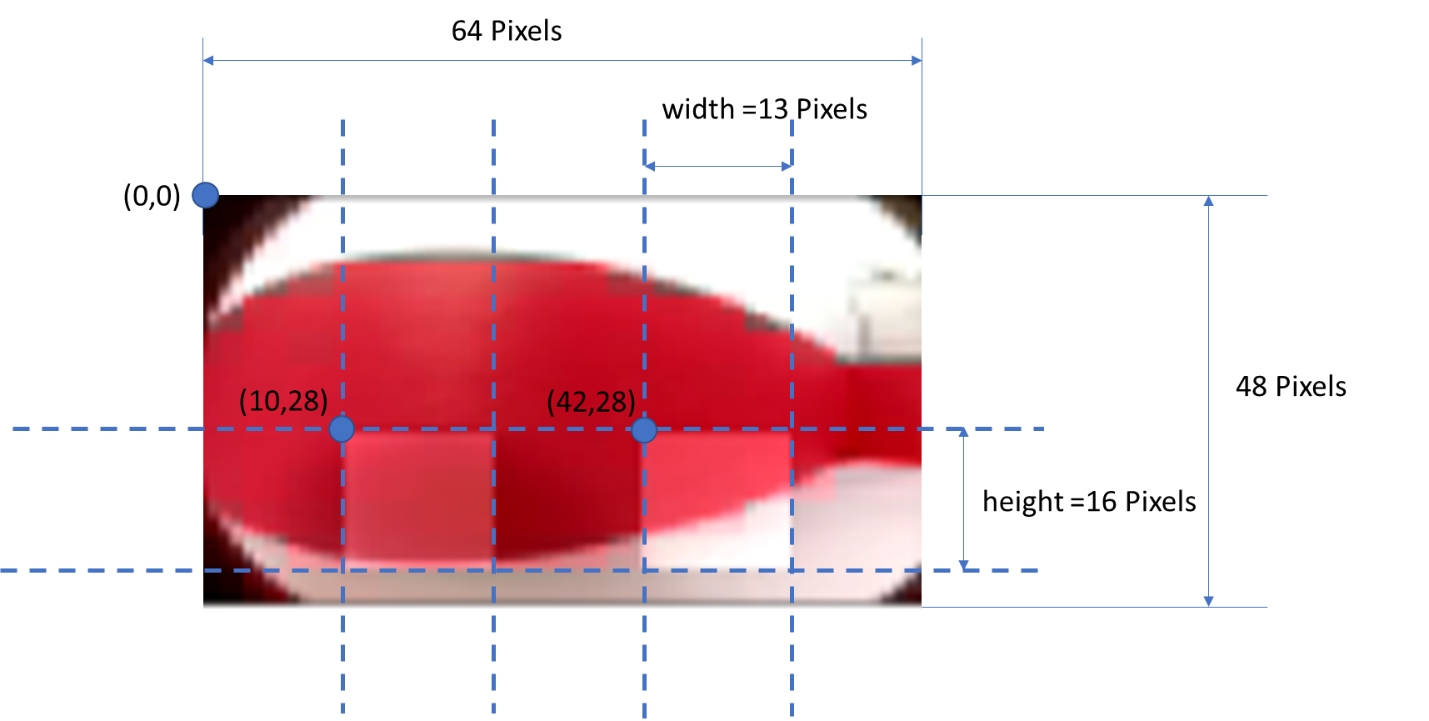

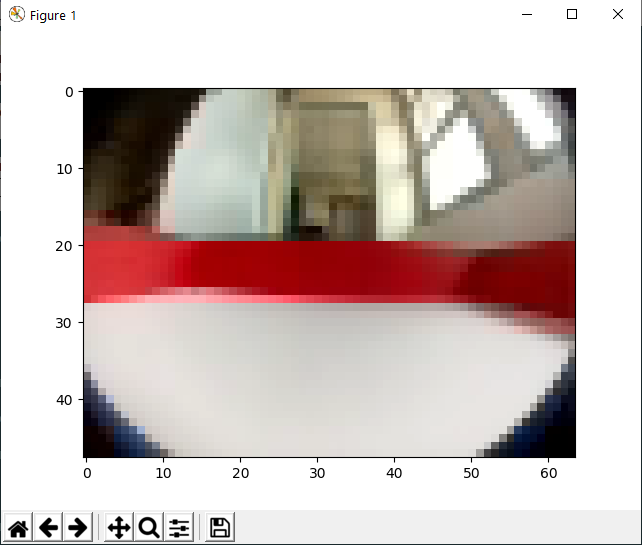

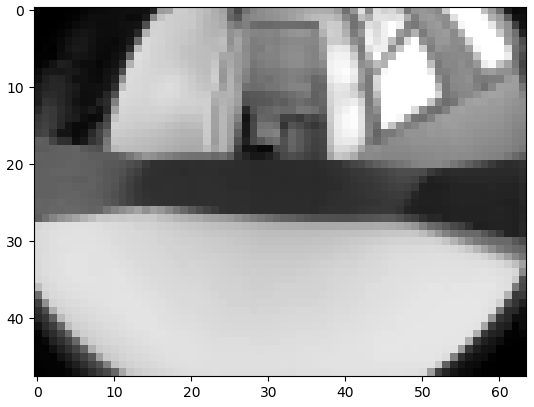

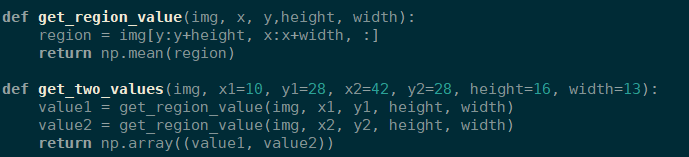

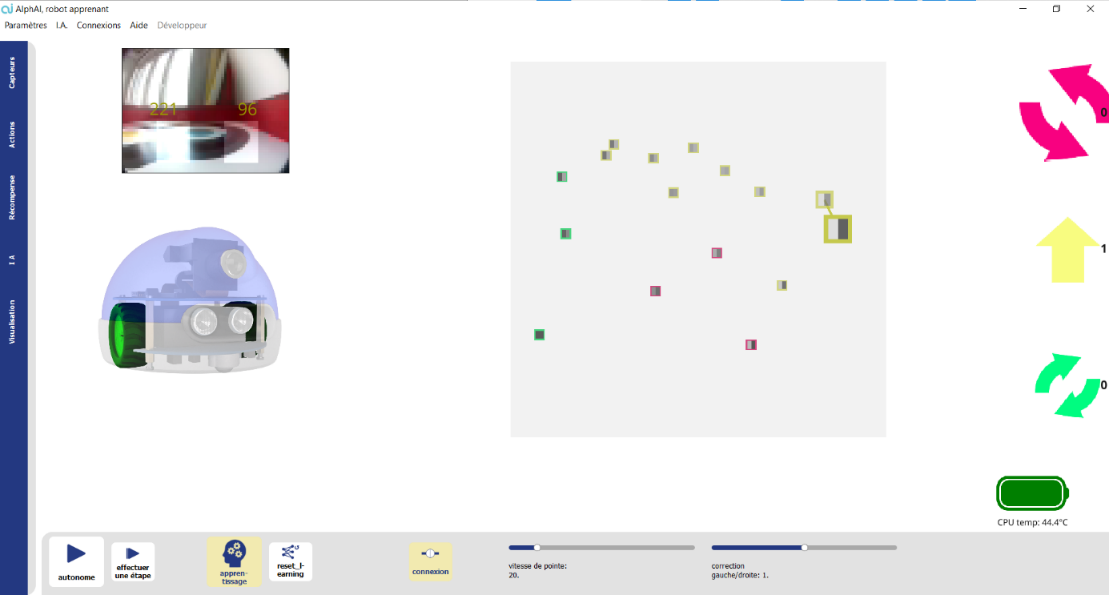

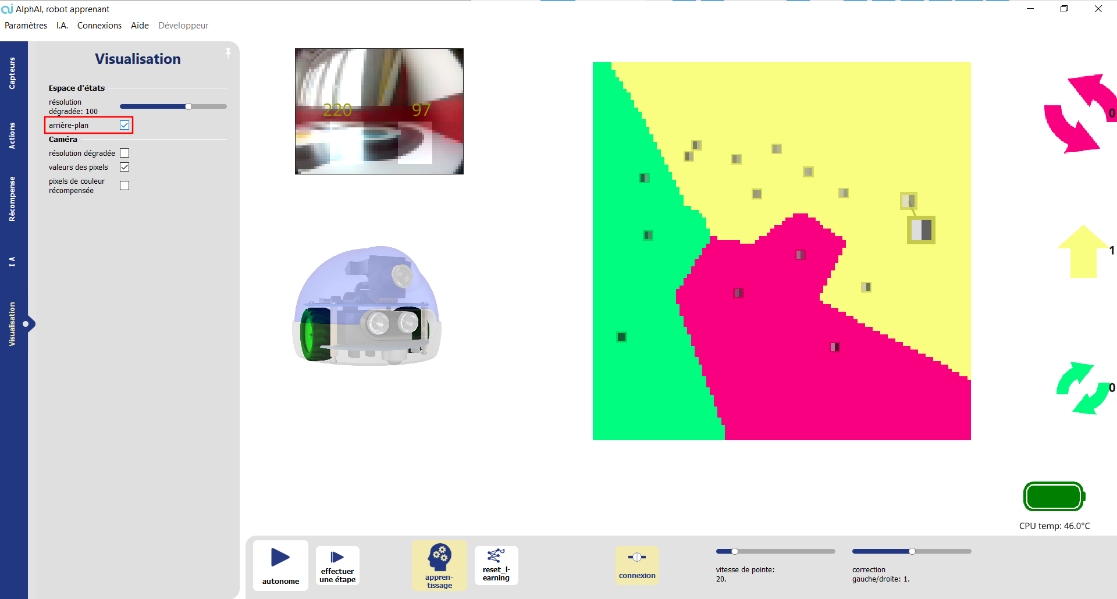

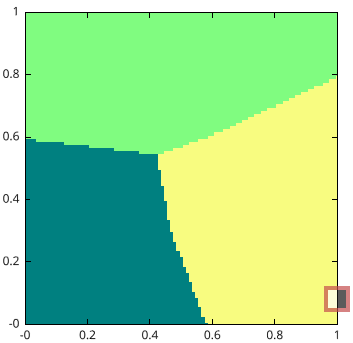

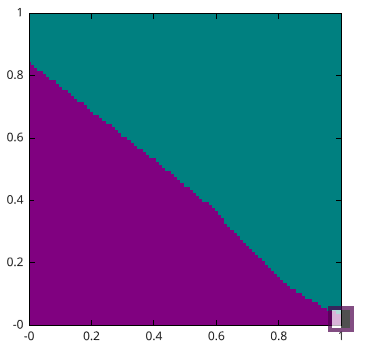

For this activity, the robot analyzes camera images whose resolution has been reduced to just 2 pixels, and without color. The result is a left pixel and a right pixel, which measure gray levels. The abscissa (left pixel) and ordinate (right pixel) of the graph show these grayscale values, with 0 corresponding to black and 1 to white.

.png)

The default actions are forward (yellow), rotate left (pink) and rotate right (green).

It is possible to add more actions for this scenario, but be sure to do so from the outset, as modifying actions causes experience memory to be erased.

Training phase

Check that the "stand-alone" button is unchecked, and that the "learning" button is checked.

Steer the robot by clicking on the arrows on the right of the screen, or by using the arrow keys on your keyboard.

Turn when the robot is close to the walls, go straight otherwise. You can also move the robot by hand to suit each situation.

After each movement, a new point appears. The position of each point is determined by its coordinates (x; y), the abscissa "x" representing the brightness in the left-hand zone and the ordinate "y" representing the brightness in the right-hand zone. The color around each point is the color associated with the chosen action (green to rotate right, yellow to rotate forward and red to rotate left).

.png)

These points are the training data. This phase is essential if the AI is to work properly. If the training data contains too many errors or approximations, the AI will not deliver a satisfactory result.

When you've finished training, open the Visualization panel and check the "Background" box in the "State space" section.

.png)

You will then see the 3 different color zones appear on the screen, corresponding to the action the robot will choose according to the brightness captured by its camera.

If your robot has been properly trained, the graph should look like this:

.png)

Brightness decreases as the robot approaches the walls. Normally, if the area on the left is the darkest, turn right, and vice versa.

When you have three clear regions on the graph, stop the training phase and activate autonomy to move on to the test phase.

Learning tests and improvements

Activate autonomy by clicking on the corresponding button on the screen or by pressing the space bar.

How does the robot behave? Does it avoid obstacles as expected?

If the robot is well trained, it will be able to avoid the edges on its own. If, on the other hand, the robot is poorly trained, or the lighting conditions in the arena are uneven, the colored areas on the graph will have more irregular contours, and the robot will perform more inappropriate actions.

Understand the algorithm's decision-making: the largest point is the one captured by the camera at that moment: it links up with the nearest point in the graph, which was recorded during the training phase: it is the action corresponding to its nearest neighbor that it will choose to perform!

Further information

- In the AI tab, vary the value of k (the number of neighbors). Observe the effect on decision making and graph background coloring. Which value of k gives the best behavior? Why or why not?

- Once you've fully understood the learning principle, repeat the learning process with a smaller number of points (e.g. 5-point training challenge only).

Review and feedback

Points to remember :

- The principle of the k-nearest neighbor algorithm: understand and explain how the robot makes decisions.

- What impact does training data have on results? How do I choose the right training data?

- What is the impact of parameter k? How do you choose the best value for this parameter?

Materials required:

- 1 robot minimum

- 1 computer/robot

- Minimum individual arena (without obstacles)

Duration :

30 minutes

Age :

+ 14 years

Software configuration :

- example configuration: "KNN camera".

The advantages of this activity :

- Intuitive algorithm

- Can be performed with the simulator

- Excellent visualization of robot decision-making

Materials required:

- 1 robot minimum

- 1 computer/robot

- a flat object (box, board, smartphone, etc.)

Software configuration :

- example configuration: "intruder detection

Duration :

2 hours

Age :

15+ years

The advantages of this activity :

- Ideal for the classroom

- Little equipment required

- Cross-disciplinary (maths / IT)

Mathematical understanding of neural networks through an activity based on the robot's ultrasonic sensor. In particular, we discover why intermediate layers of neurons are needed.

[Video content coming soon]

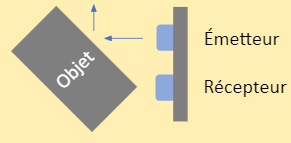

Installation

Place the robot next to the computer, facing a wall (or arena board) about 50 cm away, and provide a flat-sided object (a box, a board, a smartphone) to play the role of intruder.

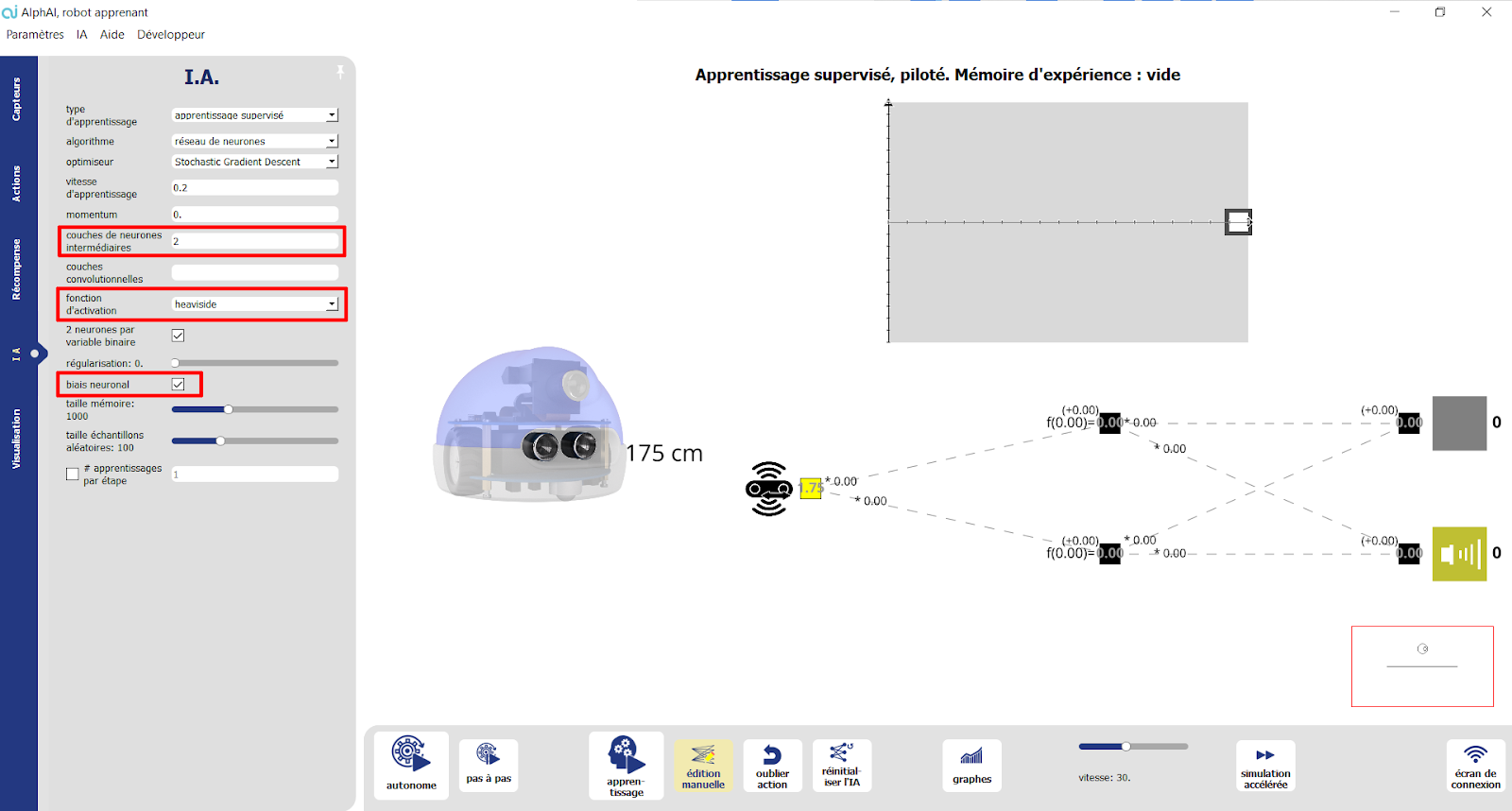

Load the"Intruder detection" configuration in the"Supervised learning" category. This scenario uses the ultrasonic sensor only.

The entire activity is carried out in"manual editing" mode, i.e. you choose the neural network parameters yourself, without using a learning algorithm.

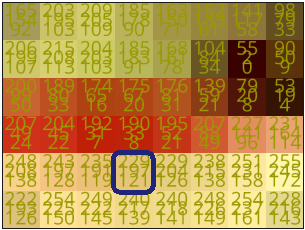

Interface presentation

In this activity, your main screen has two views:

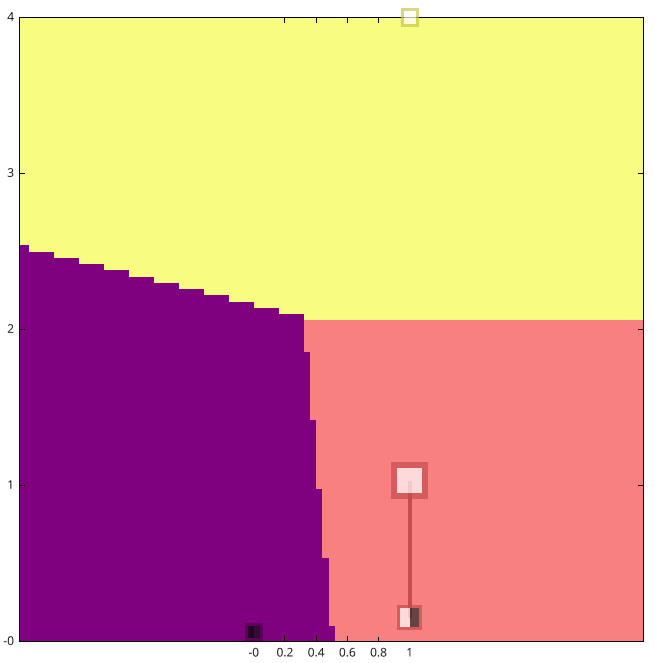

- Below, the neural network under study. At the start of the activity, the manual editing mode (in the buttons at the bottom of your software interface) must be activated, allowing you to modify the neural network parameters yourself. To modify the value of a connection, place your mouse over it (it turns red), then use your keyboard to enter the desired value, or your mouse wheel to modify the current value. To modify the value of a neuron's bias, place your mouse over the neuron itself (not the value display), then proceed as for connections.

- Above, a graph showing thestate space. On the abscissa, the distance measured by the ultrasonic sensor. On the ordinate, the activation levels of the output neurons. There are two curves represented because there are two output neurons. Curve/neuron correspondence is color-coded. The value of the output neurons is a function of the input value (distance). The background color of the graph indicates which curve is above the other for each input value, and therefore which action will be chosen by the robot for that input value.

Objectivesand issues

The robot faces a wall and must beep when someone (an intruder) passes between it and the wall.

The neural network must be configured to perform this task. Since the only sensor used is the ultrasonic sensor, the aim is to obtain a beep when the distance is small, and the "do nothing" action when the distance is normal.

Integration of neural biases

The simple "connection weight" parameters are insufficient to accomplish this task. We need to activate the "neural bias" option (in the AI tab), which unlocks new parameters that will enable us to achieve this goal.

Attempted cheating

Issues

An intruder tries to cheat by exploiting the characteristics of the ultrasonic sensor: if the flat side is placed diagonally to the sensor, the waves bounce back and the distance captured is then much greater than that of the wall! We need to adapt our neural network to detect this cheating attempt too.

Intermediate neural layers

To do this, we'll need to add an intermediate layer to our neural network (in the AI tab), in order to obtain a non-linear model thanks to the activation functions.

Review and feedback

I remember:

- A neural network is a set of neurons organized in layers. Each layer may contain one or more neurons.

- Neurons are abstract objects containing a simple numerical value.

- Neurons are linked together by connections whose values are called weights.

- Each neuron also has a bias, which is added to the neuron's value.

- Input layer neuron values are determined by sensor values.

- The neurons in the output layer correspond to the robot's actions. In autonomous mode, the action with the highest value is always selected.

- Intermediate layers enable the network to perform more complex tasks. The graph shows that the straight lines of the output neurons are replaced by increasingly complex curves as the number of intermediate layers increases.

- Training a neural network simply involves choosing a value for each of its parameters: connection weight and neuron bias. When the number of neurons and connections becomes large, this complex task is performed by a learning algorithm!

Materials required:

- 1 robot minimum

- 1 computer/robot

- a flat object (box, board, smartphone, etc.)

Duration :

2 hours

Age :

15+ years

Software configuration :

- example configuration: "intruder detection

The advantages of this activity :

- Ideal for the classroom

- Little equipment required

- Cross-disciplinary (maths / IT)

Materials required:

- 1 robot minimum

- 1 computer/robot

- Minimum individual arena

Software configuration :

- example configuration: "Reinforcement learning - obstacle avoidance

Duration :

30 minutes

Age :

Ages 8 and up

The advantages of this activity :

- Introducing reinforcement learning

- Understanding the "try and learn" principle = pedagogical benefits

- Can be performed with the simulator

This activity involves observing a robot learning autonomously, based on the principle of reinforcement learning. Some general conclusions can be drawn about the conditions required for effective learning.

[Video content coming soon]

Introduction

In this activity, we're not training the robot: it's the robot itself that will create the examples it uses to make the right decisions about which actions to take.

To help the robot distinguish between good and bad decisions, the algorithm includes a reward system.

Here, the robot receives the following rewards for its actions:

- advance: 100 points

- turn: 82 points

- back off: -50 points

- The robot also receives a penalty of -50 points for blocking.

In the "Level" bar, you can see the average reward score obtained by the robot. Its aim is to maximize this score, so it will gradually learn to choose the actions that will bring it the optimum rewards, taking into account what its sensors are telling it.

We'll now be able to observe the robot's progress as it learns. Start by setting up an obstacle-free arena, and place the robot in it.

Learning to use the robot independently

In the AlphAI software, select the example configuration: "Reinforcement learning - obstacle avoidance".

In this activity, the robot teaches itself!

Start the autonomous mode, and watch your robot. How does it behave?

When the robot has identified a rewarding action (e.g. turning), it may decide to perform only that action from now on.

We'll now activate the "explore" button: from time to time, the robot will decide to perform a random action. This will enable it to discover that the action it would have chosen may not be the optimal reward, and to enrich its learning with new data.

Normally, he learns in succession to go straight ahead, to turn around when he bumps into an obstacle, and then to recognize these obstacles in advance and turn before bumping into them! This learning process takes about 10 minutes.

Don't hesitate to deactivate the "exploration" mode when the robot starts to choose the right actions to perform.

Review and feedback

Once training is complete, stop your robot and click on "graphs" in the bottom bar (if the button doesn't appear, change the parameter display to "advanced" or "expert"). Normally, the values should be very high at the start of the activity, then gradually tend towards zero: the robot has trained itself not to make any more mistakes!

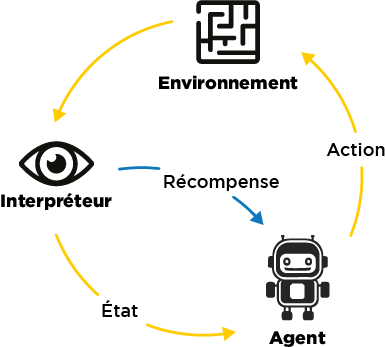

The way reinforcement learning works can be summarized as follows:

What's needed to teach the robot :

- Repetition of the same task: the robot doesn't immediately find the right solution, but only improves through repetition.

- Exploration: the robot may need to try out new ideas, to avoid being locked into a non-optimal solution.

- Rewards or penalties : the robot needs external help to assess whether its decisions are optimal or not.

- Room forerror: the robot learns from its mistakes without getting discouraged! Mistakes help it learn which actions not to repeat!

Materials required:

- 1 robot minimum

- 1 computer/robot

- Minimum individual arena

Duration :

30 minutes

Age :

Ages 8 and up

Software configuration :

- example configuration: "Reinforcement learning - obstacle avoidance

The advantages of this activity :

- Introducing reinforcement learning

- Understanding the "try and learn" principle = pedagogical benefits

- Can be performed with the simulator

Materials required:

- 1 robot minimum

- 1 computer/robot

- Individual arena

Software configuration :

- example configuration: "Blocked VS Movement" in manual editing mode, then in "reinforcement learning" mode

Duration :

90 minutes

Age :

15+ years

The advantages of this activity :

- Understanding the Q-learning algorithm

- Multidisciplinary (math/computer science)

- Can be performed with the simulator

The aim of this activity is to understand how the Q-learning algorithm works.

Q-learning is a reinforcement learning algorithm. The robot learns by trial and error, based on rewards determined by the user (as in the "Obstacle avoidance" scenario).

Using this method, we're going to train an AlphAI robot to move around an arena without getting stuck against the walls. This simple task will give us a good understanding of the mechanisms involved in the neural network.

[Video content coming soon]

Installation

Place the robot in a small, unobstructed arena.

Reward and manual editing

In the first part, we discover the principle of rewards, and use the "manual editing" mode to find the robot behavior that maximizes the rewards received.

Reinforcement learning

In the second part, we observe the robot's step-by-step learning process and the evolution of connection weights in the network. We discover the importance ofexploration in learning.

Q-learning

The next step is to discover the Q-learning algorithm itself. It mainly consists of a formula for updating the connection weights after each robot trial. This formula involves two parameters whose usefulness is debated.

We are discovering the impact of temporality on learning: we need to learn fast enough without "jumping to conclusions". The algorithm must also be able to take future rewards into account, and not just the immediate reward: it must develop a longer-term vision.

Deep Q-learning

Deep Q-learning is an evolution of the Q-learning algorithm to apply it to more complex (multi-layered) neural networks. This is the algorithm used in the "Obstacle avoidance" scenario, for example.

Materials required:

- 1 robot minimum

- 1 computer/robot

- Individual arena

Duration :

90 minutes

Age :

15+ years

Software configuration :

- example configuration: "Blocked VS Movement" in manual editing mode, then in "reinforcement learning" mode

The advantages of this activity :

- Understanding the Q-learning algorithm

- Multidisciplinary (math/computer science)

- Can be performed with the simulator

Materials required:

- 1 computer/robot

- 1 robot minimum or software simulation

- Optional activity arena (robot race)

Software configuration :

- example configuration: depends on the code situation

Duration :

1 to 2 hours

Age :

+ 14 years

The advantages of this activity :

- Can be performed with the simulator

- A very good introduction to programming

In this Python programming activity, students learn how to send commands to the robot based on the keys pressed on the keyboard, and then organize a robot race.

[Video content coming soon]

Handling the robot

The alphai.py module sends instructions written in Python to the robot.

For the module to work, the "AlphAI" software must be running. You can connect to an AlphAI robot (or its simulated version).

In your favorite Python editor, create a new project in the location of your choice and configure the Python environment to contain the alphai module by typing in the IPython console or a terminal :

pip install alphai-api

This command downloads and installs the module and its dependencies.

Open a new python document or restart the console, copy and execute the following code:

from alphai import *

motor(30, -30, 5)

If the first line of the program causes an error, the alphai library has not been installed correctly. If the line motor(30, -30, 5) causes an error, AlphAI has probably not been started.

If there is no error, you watch the robot (or the robot simulated in the software) turn on itself for 5 seconds.

The motor(left, right, duration) command sends left and right values to the robot's left and right motors for duration, after which it stops. The left and right values must be between -50 and +50. If the duration is not specified, the robot continues to move forward until the next motor(0,0) call.

⚠️ It is possible and sometimes useful to make the connection in your python script rather than by clicking "connect" in the software, using the functions connect_bluetooth(n) (replacing n with the number of your robot) or connect_wifi(), as well as disconnect() to disconnect.

The code in this case looks like this:

from alphai import *

connect_bluetooth(n)

motor(30, -30, 5)

disconnect()

On the right-hand side of this page, in the downloadable appendices, you'll find the alphai-api library documentation, which contains all the functions included in the alphailibrary . Check it out now.

First script

Now you can create a Python script in your favorite programming environment.

Create a new Python file and copy the following code:

from alphai import *

if _ _name_ _ == '_ _main_ _':

connect_bluetooth(n)

motor(30,30,1)

disconnect()

Then execute it: the robot moves forward for one second, then stops.

The motor(left, right, duration)command sends left and right values to the left and right motors. These values must be between -40 and +40. Naturally, motor(0, 0) is used to stop the robot.

On the right-hand side of this page, in the downloadable appendices, you'll find the documentation for the alpha-api library, which contains all the functions included in the alphai library . Check it out now.

Programming a sequence

To make coding easier, define the following five functions. Make them very simple: each function should only make one call to the motor function.

forward()

Moves the robot straight ahead.

backward()

Moves the robot backwards.

stop()

Stop the robot.

left()

Rotates the robot to the left.

right()

Rotates the robot to the right.

Finally, create a walk_around() function that causes the robot to perform a sequence of actions using these five functions. Test it by calling it in the main block.

Remote control programming

Reading pressed keys

Using the API function wait_for_key (see explanations on last page) and a while loop in the main function, print the keys pressed on the keyboard in the console. To avoid writing an infinite loop, use a special key to exit the loop, such as the "esc" key:

keys = []

while "esc" not in keys:

# don't forget indentation

Remote control programming

Still using the wait_for_key function and a while loop, create a remote_control()function that reacts to directional keys in such a way that the robot moves according to the instructions given on the keyboard. To retrieve the last key pressed, select the last item in the list using the -1 index. Warning: the list may sometimes be empty!

Remember to stop the robot when no key is pressed. Test your code by remote-controlling the robot!

Further information

We'll be able to organize races between your remote-controlled robots, but you'll also want to improve your program by adding new commands, as suggested below... These improvements are only suggestions, so don't hesitate to create your own!

Different curves

Create two new functions that you can use when the wait_for_key function returns a list of several keys:

forward_left()

Moves the robot to the left when the top and left arrows are pressed simultaneously. In this way, you can make the robot make both tight turns with left() (left arrow only) and wide turns with forward_left() (top and left arrows).

forward_right()

Pressing the up and right arrows simultaneously also moves the robot to the right.

Braking and boost

Add input variables to all your functions, so you can modulate the robot's speed, or the strength of turns, depending on which other keys are pressed.

For example, add a speed input variable to all your functions (e.g. forward(speed)), and call the functions with a lower speed when the space bar is pressed at the same time (braking), and a higher speed when the "x" key is pressed at the same time ("boost").

Pilot your robot and adjust the speed parameters to make it as maneuverable and fast as possible. Don't forget to practice overtaking competitors too!

Programming a sequence

On the key of your choice, have the robot perform a little choreography, for example to celebrate victory!

Review and feedback

In programming, the list of accessible program functions is called an API, for Application Programming Interface. It is used by programmers to find out how to interact with the program. You'll find the API for the alphai python module here: https: //drive.google.com/file/d/1C4ovPW_eH5KFz5Y9JvSrzLhtmdOpcp6-/view

Materials required:

- 1 computer/robot

- 1 robot minimum or software simulation

- Optional activity arena (robot race)

Duration :

1 to 2 hours

Age :

+ 14 years

Software configuration :

- example configuration: depends on the code situation

The advantages of this activity :

- Can be performed with the simulator

- A very good introduction to programming

Materials required:

- 1 robot minimum or software simulation

- 1 computer/robot

- Racing arena

Software configuration :

- example configuration: depends on the code situation

Duration :

1 to 2 hours

Age :